Das Scraping von Websites kann eine wertvolle Methode sein, um wertvolle Geschäftsdaten zu extrahieren. Wenn Sie nach einer schnellen und einfachen Lösung suchen, um Daten von WLW.de (Wer liefert was) zu sammeln, sind Sie hier genau richtig.

In diesem Artikel stellen wir Ihnen vier benutzerfreundliche Tools vor, mit denen Sie WLW.de ohne jegliche Programmierkenntnisse scrapen können. Egal, ob Sie nach Lieferanten, Produktinformationen oder Marktanalysen suchen – diese Tools machen das Datensammeln schnell und effizient.

Was ist WLW.de

WLW.de (Wer liefert was) ist eine deutsche B2B-Plattform, die Unternehmen hilft, Lieferanten, Hersteller und Dienstleister zu finden. Sie bietet einen umfangreichen Katalog und eine Datenbank für verschiedene Branchen wie Industrie, Bauwesen, Medizin, Elektronik und mehr.

Hauptmerkmale:

- Lieferantensuche: Suche nach Lieferanten mit Schlüsselwörtern, Branchen oder Firmennamen.

- Produktkatalog: Detaillierte Produktinformationen, Preise und Lieferantenkontakte.

- Branchenkategorisierung: Produkte sind nach Branchen geordnet, um eine schnelle Suche zu ermöglichen.

- Unternehmensprofile: Jedes Unternehmen hat eine eigene Seite mit Informationen und Produkten.

- Such- und Filterfunktionen: Filter nach Schlüsselwörtern, Regionen und anderen Kriterien.

- Zusatzleistungen: Marktberichte und Messeinformationen.

Erlaubt wlw.de Scraping und bietet es API-Zugriff?

WLW (Wer liefert was) hat in der Regel strikte Nutzungsbedingungen, die das Scraping ihrer Website ohne ausdrückliche Genehmigung verbieten. Scraping, also das automatisierte Abrufen von Daten, verstößt häufig gegen die Allgemeinen Geschäftsbedingungen (AGB) von Websites, wenn es nicht offiziell zugelassen ist. Es ist daher ratsam, die AGB von WLW.de zu prüfen, um genau zu verstehen, ob und in welchem Umfang das Scraping erlaubt ist.

API-Zugriff: WLW.de bietet eine API für die Integration von Daten an, jedoch ist der Zugang in der Regel kostenpflichtig und richtet sich an Unternehmen, die eine kommerzielle Partnerschaft mit der Plattform eingehen. Der API-Zugang ermöglicht es, bestimmte Daten aus dem Katalog direkt in eigene Systeme zu integrieren, was eine legalere und effizientere Methode darstellt, um auf die Informationen zuzugreifen.

Wenn Sie Scraping oder die Nutzung einer API in Betracht ziehen, sollten Sie daher:

- Die AGB von WLW.de prüfen.

- Den API-Zugang offiziell anfragen, falls Sie rechtmäßig auf Daten zugreifen möchten.

Es ist immer ratsam, die Plattform direkt zu kontaktieren, wenn Sie eine API oder andere Automatisierungsfunktionen nutzen möchten, um sicherzustellen, dass Sie die rechtlichen Anforderungen erfüllen.

Wie man wlw.de mit vier tollen Tools ohne Codierung scrapt

Um WLW (Wer liefert was) ohne Programmierung zu scrapen, können Sie Web-Scraping-Tools verwenden, die keine Codierung erfordern. Einige beliebte Tools sind:

1. Octoparse ⭐️⭐️⭐️⭐️⭐️

Octoparse ist ein benutzerfreundliches Tool, das Ihnen ermöglicht, Websites ohne Programmierkenntnisse zu scrapen. Sie können eine visuelle Benutzeroberfläche verwenden, um Daten zu extrahieren und speichern. Octoparse bietet auch vordefinierte Templates für bestimmte Websites, die die Konfiguration noch einfacher machen.

Vorteile:

- Sehr benutzerfreundlich: Octoparse bietet eine intuitive Point-and-Click-Oberfläche, die das Scrapen auch für Anfänger einfach macht.

- 500+ Templates: Octoparse bietet zahlreiche Templates für häufig verwendete Websites, wodurch das Setup beschleunigt wird.

- Flexibilität: Es unterstützt das Scraping von komplexen Webseiten mit dynamischem Inhalt, wie z.B. JavaScript.

- Cloud-Scraping: Sie können die Daten in der Cloud scrapen lassen, was die Verarbeitungsgeschwindigkeit und Effizienz verbessert.

- Datenexport: Es bietet vielfältige Exportmöglichkeiten, einschließlich CSV, Excel, JSON und Datenbanken.

Nachteile:

- Kostenpflichtige Version: Die kostenlose Version ist eingeschränkt und bietet nicht alle Funktionen (z.B. Cloud-Scraping und erweiterte Funktionen). Aber möchten Sie die Premium-Templates ausprobieren? Melden Sie sich einfach beim Support unter support@octoparse.com. Wir schenken Ihnen ca. 3 US-Dollar Kredit, damit Sie bis zu 10.000 Daten exportieren und die volle Leistung erleben können.

- Einarbeitungszeit: Auch wenn das Tool benutzerfreundlich ist, kann es eine kurze Lernkurve geben, besonders bei komplexeren Anforderungen. Aber octoparse bietet persönliche Trainings an.

2. ParseHub ⭐️⭐️⭐️⭐️

ParseHub ist ein weiteres visuelles Web-Scraping-Tool, das es ermöglicht, Daten von Webseiten zu extrahieren, ohne dass Programmierkenntnisse erforderlich sind. Es bietet eine Point-and-Click-Oberfläche und ist besonders hilfreich für das Scrapen komplexerer Seitenstrukturen.

Vorteile:

- Einfach zu bedienen: Die Point-and-Click-Oberfläche erleichtert das Scraping ohne Programmierung.

- Flexible Extraktion: Es bietet eine hohe Flexibilität bei der Auswahl von Datenpunkten.

Nachteile:

- Kostenpflichtige Version erforderlich für erweiterte Funktionen: Die kostenlose Version ist stark eingeschränkt, z.B. bei der Anzahl der Seiten, die scrapen können.

- Komplexe Benutzeroberfläche: Obwohl es einfach zu bedienen ist, kann die Benutzeroberfläche für Anfänger manchmal etwas unübersichtlich wirken.

- Begrenzte Exportoptionen in der kostenlosen Version: In der kostenlosen Version sind die Exportmöglichkeiten und die Anzahl gleichzeitiger Scraping-Jobs begrenzt.

3. WebHarvy ⭐️⭐️⭐️⭐️

WebHarvy ist ebenfalls eine einfache Lösung, um Websites zu scrapen. Es bietet eine visuelle Benutzeroberfläche, bei der Sie die gewünschten Daten durch Klicken auf die Elemente der Website auswählen können.

Vorteile:

- Automatisiertes Erkennen von Mustern: Es erkennt automatisch Muster auf Webseiten und extrahiert Daten entsprechend.

- Flexibilität: Es bietet Unterstützung für das Scraping von dynamischen Webseiten und mehrseitigen Seiten.

Nachteile:

- Kostenpflichtig: WebHarvy ist nicht kostenlos, und der Preis ist für den Einzelgebrauch relativ hoch.

- Eingeschränkte Funktionen in der Testversion: Die Testversion hat Einschränkungen, was die Anzahl der extrahierten Daten und die Exportformate betrifft.

- Fehlende Cloud-Unterstützung: Im Vergleich zu anderen Tools bietet WebHarvy keine Cloud-Scraping-Funktion, was die Performance bei großen Datenmengen einschränken kann.

4. Content Grabber ⭐️⭐️⭐️

Content Grabber ist ein weiteres Tool, das speziell für Nicht-Programmierer entwickelt wurde. Es bietet eine Drag-and-Drop-Oberfläche und ist für das Extrahieren von strukturierten Daten aus Webseiten geeignet.

Vorteile:

- Benutzerfreundlich: Es bietet eine visuelle Benutzeroberfläche und erfordert keine Programmierung.

- Unterstützt API und Cloud: Es bietet Integration mit APIs und Cloud-Scraping, was den Prozess optimiert.

Nachteile:

- Kostenpflichtig: Content Grabber ist teuer, besonders für Einzelpersonen oder kleine Unternehmen. Es gibt keine kostenlose Version.

- Eingeschränkte Testversion: Die Testversion bietet nur grundlegende Funktionen und ist zeitlich begrenzt.

- Komplexität: Aufgrund der vielen Funktionen kann die Benutzeroberfläche für Anfänger etwas überwältigend sein, obwohl sie dennoch ohne Codierung genutzt werden kann.

Alle diese Tools bieten eine benutzerfreundliche Möglichkeit, Webseiten ohne Programmierung zu scrapen, aber die Wahl des richtigen Tools hängt von Ihrem Budget, den benötigten Funktionen und der Komplexität Ihres Projekts ab.

Wie man wlw.de mit Octoparse Schritt für Schritt scrapt?

Wenn Sie nicht viel über Python und Codierung wissen und wlw.de scrapen möchten, stellen wir Ihnen Octoparse vor . Es ist ein erstaunliches und leistungsstarkes Tool zum Scrapen von wlw.de ohne jegliche Blockierung. Sie benötigen keine technischen Kenntnisse und keine Kenntnisse in Codierung, um wlw.de mit Octoparse zu scrapen, da es frei von jeglicher Codierung und einfach zu verwenden ist. Sie können auch andere erweiterte Funktionen wie geplante Aufgaben, IP-Proxy, Paginierung, Cloud-Extraktion usw. finden.

Schritte zum Scrapen von Daten von wlw.de mit Octoparse

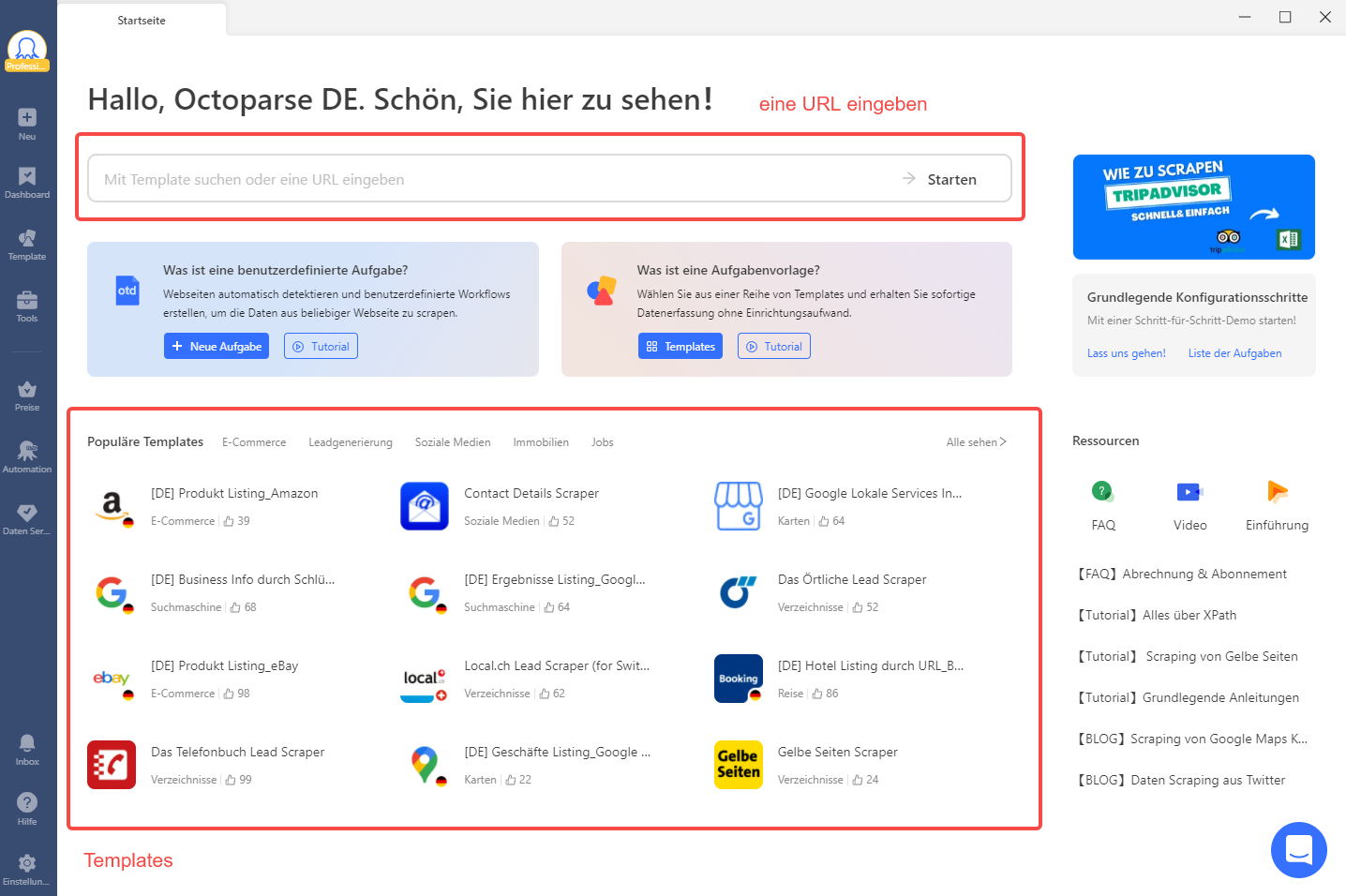

Schritt 1: Geben Sie den wlw-Seitenlink in Octoparse ein

Laden Sie zunächst Octoparse von der offiziellen Website herunter und installieren Sie es auf Ihrem Gerät. Kopieren Sie anschließend den Link zur wlw-Zielseite, die Sie scrapen möchten, und fügen Sie ihn in das Suchfeld von Octoparse ein.

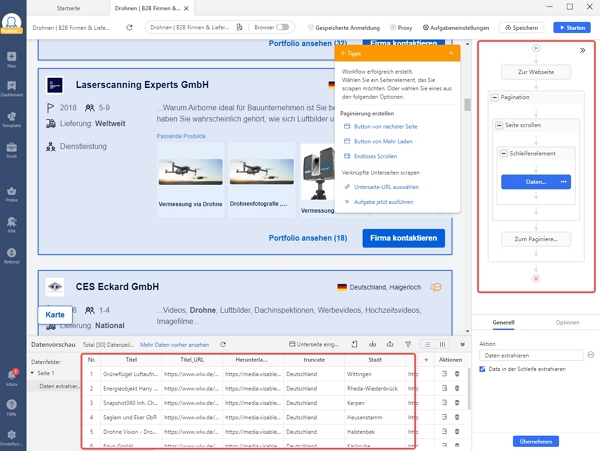

Schritt 2: Workflow anpassen und Datenfelder prüfen

Klicken Sie auf die Schaltfläche „Start“, um in den automatischen Erkennungsmodus zu wechseln. Danach finden Sie die ausgelesenen Datenfelder im Vorschaufenster. Erstellen Sie einen Workflow und nehmen Sie bei Bedarf Änderungen vor.

Schritt 3: Exportieren Sie die gescrapten wlw-Daten nach Excel

Nachdem alle Änderungen gespeichert wurden, klicken Sie auf die Schaltfläche Ausführen, um den Scraping-Prozess zu aktivieren. Sie können die Datendateien auf Ihr lokales Gerät herunterladen oder in einer Datenbank speichern.

Oder können Sie Octoparse-Vorlagen 14 Tage kostenlos testen.

https://www.octoparse.de/template/wlw-de-lead-scraper

Zusammenfassung

Egal, ob Sie ein Anfänger im Web-Scraping sind oder bereits Erfahrung mit der Datensammlung haben, diese vier Tools bieten Ihnen die Flexibilität, WLW.de problemlos zu scrapen. Mit der einfachen Handhabung und den zahlreichen Funktionen können Sie schnell und effizient die Daten extrahieren, die Sie benötigen – ganz ohne Code. Probieren Sie die Tools aus und starten Sie noch heute Ihre Datensammlung!

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.