„Können Sie Daten von Websites nach Excel ziehen?“

Möglicherweise haben Sie sich bereits ähnliche Fragen wie oben erwähnt gestellt oder schon einmal gehört. Wenn Sie Daten von einer Website herunterladen möchten, ist Excel ein einfaches und weit verbreitetes Tool zum Sammeln und Analysieren von Daten. Mit Excel können Sie problemlos einfache Aufgaben wie das Sortieren, Filtern und Gliedern von Daten und das Erstellen von Diagrammen auf der Grundlage dieser Daten erledigen. Wenn die Daten stark strukturiert sind, kann man mithilfe von Pivot- und Regressionsmodellen in Excel sogar erweiterte Datenanalysen durchführen.

Es ist jedoch äußerst mühsam, wenn Sie Daten manuell durch wiederholtes Eintippen, Suchen, Kopieren und Einfügen erfassen. Hier erfahren Sie, wie Sie ganz einfach Webseiten-Daten in Excel importieren – ideal für die Marktforschung, Lead-Listen oder Preisvergleiche.

Daten von Website in Excel importieren – Web Scraping einfach gemacht

Daten von einer Webseite in Excel importieren, um Lead-Listen zu erstellen, diverse Angebote und Preise zu vergleichen ist eine sehr einfache Möglichkeit. Wird Excel genutzt, fällt der spätere Vergleich enorm leichter. Excel bietet den Nutzern äußerst leistungsstarke Verarbeitungs- und Analyseoptionen. Mit diesen Optionen können die gesammelten Daten einfach verarbeitet werden.

Bevor man aber eine Excel-Datei analysieren und bearbeiten kann, muss sie erstellt werden. Die Daten müssen von der Webseite ausgelesen und in Excel abgespeichert werden. Diese Aufgabe ist jedoch nicht so einfach. Die Daten kopieren und in die Excel-Tabelle zu speichern bedeutet hohe Konzentration und einen enormen Zeitaufwand. Es ist darauf zu achten, dass keine Fehler beim Übertragen gemacht werden. Im folgenden Beitrag werden einfache Möglichkeiten von Octoparse gezeigt, wie man ganz einfach Daten von Website in Excel importieren kann.

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.

Web Scraping – einfach und effizient

Geht es darum, Daten von Website in Excel importieren zu wollen, gibt es einige effiziente Möglichkeiten. Zuerst aber ein kurzer Überblick auf das Web-Scraping.

Web Scraping kurz erklärt

Daten von unterschiedlichen Websites in Excel zu sammeln, um diese später zu verschiedenen Zwecken zur Hand zu haben, ist Web Scraping.

Die folgenden Zwecke benötigen zum Beispiel in der Regel die Excel Daten von Website auslesen:

- Für die Marktforschung: Wichtige Infos der Markttrends können erstellt werden, um die Geschäftsstrategien besser anzupassen.

- Zur Lead-Generierung: Mit dem Scraping können auch Informationen über zukünftige Kunden erhalten werden. So können zum Beispiel hochwertige Lead-Listen erstellt werden und die Kontaktaufnahme personalisiert werden.

- Zur Wettbewerbsanalyse: Im Internet finden sich ausreichende Informationen über die eigene Konkurrenz. Durch das Sammeln und Vergleichen der Infos kann das eigene Unternehmen erfolgreicher gemacht werden.

Daten aus Webseite auslesen in Excel speichern – die Gründe

Die folgenden Gründe zeigen klar und deutlich, warum das Daten von Website in Excel importieren sehr sinnvoll ist.

| Grund und Nutzen | Erklärung |

| Datenorganisation | Mit Excel erhält man Filteroptionen wodurch eine hohe Anzahl an Daten einfach organisiert werden |

| Integration | Excel ist sehr beliebt und kann sehr einfach mit anderen Systemen die zum Beispiel von Microsoft oder Plattformen wie CRM, outreach, Vertrieb und ähnlichen kombiniert werden |

| Offline verfügbar | Um eine Excel-Tabelle zu nutzen, ist keine Verbindung mit dem Internet notwendig. Dadurch kann man jederzeit auf die Daten zugreifen |

| Visualisierung der Daten | Diagramme oder Grafiken können durch Excel sehr einfach erstellt werden. Erkenntnisse sind damit einfacher zu verstehen |

Wie hier bereits erkennbar ist, sind die Möglichkeiten eine Excel-Tabelle zu nutzen sehr vielfältig. Excel-Tabellen machen das Bearbeiten einfacher und enorm übersichtlicher.

Methoden um Excel Daten von Website auslesen zu können

Für das Daten aus einer Webseite auslesen gibt es mehrere Möglichkeiten. Im Folgenden werden die besten Methoden für das Website Scraping vorgestellt:

- Die herkömmliche Webabfrage bzw. Kopieren und Einfügen

- Daten von Website in Excel importieren VBA

- Spezielle Tools für das Web-Scraping – Octoparse Vorlagen

Die genannten Methoden sind die gängigsten Möglichkeiten, Daten aus Webseiten auszulesen. Es gibt außerdem noch die Möglichkeit, selbst ein Programm zum Daten-Auslesen zu erstellen. Dafür werden jedoch Programmierkenntnisse benötigt.

Die herkömmliche Webabfrage bzw. das Kopieren und Einfügen

Bei der herkömmlichen Methode werden die benötigten Daten von unterschiedlichen Websites kopiert und in die Excel-Tabelle eingefügt. Diese Vorgehensweise ist dann praktisch, wenn man nicht hunderte Daten von vielen verschiedenen Websites benötigt. Zudem benötigt man keine Programmierungskenntnisse, um diese Methode durchzuführen. Sie macht aber nur Sinn, wenn die Daten bereits in Tabellenform vorliegen bzw. diese Daten bereits strukturiert sind.

Schritte für das Kopieren und Einfügen:

- die benötigten Daten markieren

- kopieren und danach

- in der Excel Tabelle einfügen

Die genannten Schritte werden für jeden benötigten Datensatz durchgeführt. Man benötigt Zeit und muss zusätzlich darauf achten, keine Fehler zu machen. Werden sehr viele Daten benötigt, ist diese Methode sehr fehleranfällig und zeitaufwendig.

Bei der Webabfrage kann Octoparse mit seinen unzähligen Vorlagen sehr praktisch sein. Dabei handelt es sich um ein Tool, das Daten aufbereitet und transformiert. Daten werden damit im Internet gesammelt und direkt in die Excel-Tabelle importiert. Die Anwendung von Octoparse benötigt zudem kein besonderes Wissen im technischen Bereich. Es ist einfach anwendbar und sehr hilfreich.

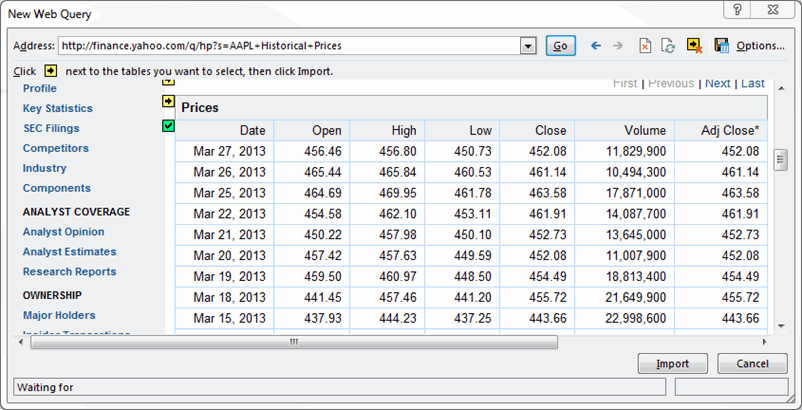

Schritt für Schritt zur Verwendung von Webabfrage generell:

Schritt 1: Excel öffnen und das Register “Daten” öffnen

Schritt 2: Den Punkt “Daten aufrufen und transportieren” anklicken und die Option “vom Web” auswählen

Schritt 3: Die Website mit den benötigten Daten eingeben und danach “ok” drücken

Schritt 4: Es dauert ein paar Minuten, bis die Website von der Software analysiert und die Daten in der Excel-Tabelle angezeigt werden

Hinweis: Bevor die Daten in die Tabelle integriert werden, erscheint ein Fenster mit einer Vorschau. Durch das Drücken auf “importieren” werden die Daten in die Tabelle integriert!

Daten von Website in Excel importieren VBA

Bei VBA oder “Visual Basic for Applications” von Microsoft handelt es sich um eine Programmiersprache. Mit VBA können Textverarbeitungs-Funktionen sowie Datenverarbeitungsfunktionen automatisiert werden. Damit kann man zum Beispiel personalisierte Diagramme und Berichte erstellen.

Schritt für Schritt zur Anwendung von VBA:

Schritt 1: In Excel wird der Menüpunkt “Entwickler” aufgerufen

Tipp: Wird der Reiter nicht sofort gefunden, geht man auf Datei – Menüband anpassen – Hauptregister – und danach wird das Kästchen “Entwickler” aktiviert.

Schritt 2: Unter dem Menüpunkt Entwickler die Option “Einfügen” und “Modul” auswählen

Schritt 3: Die Website mit den benötigten Informationen oder einen Code eingeben

Schritt 4: “F5” auf der Tastatur drücken damit der Code bzw. die Website durchsucht und die Daten übertragen werden

Eine effiziente Methode mit einem Nachteil. Bei dieser Methode benötigt man ein Basiswissen im Bereich Technik und Programmieren. Ein weiterer Nachteil des VBA sind die begrenzten Datenarten. Skripte können zum Beispiel nicht ausgeführt werden. Dafür ist es notwendig, spezielle Bibliotheken zu installieren.

Spezielle Tools für das Web Scraping

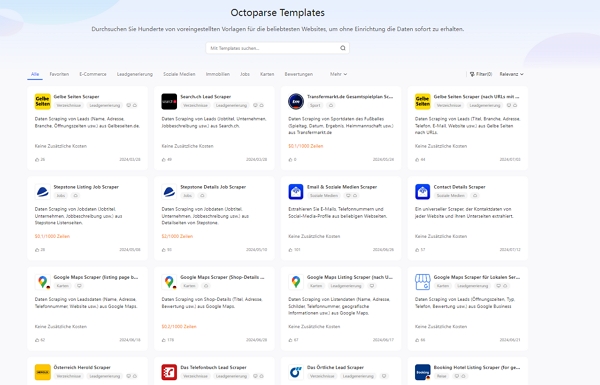

Spezielle Tools für das Web-Scraping helfen dabei, mit geringem Aufwand alle Arten von Excel-Daten von Website auszulesen und in eine Tabelle zu importieren. Diese Tools sind in der Regel sehr benutzerfreundlich und Programmierkenntnisse nicht nötig. Octoparse bietet rund 500 Vorlagen, um das Web-Scraping einfacher zu gestalten.

Zusammenfassend lässt sich sagen, dass es unzählige Tools im Internet gibt, die die Daten von Website in Excel importieren vereinfachen. Welches der Tools für Sie am geeignetsten ist, muss selbst getestet werden. Die genannten Möglichkeiten sind auf jeden Fall die effizientesten Methoden für das Excel Daten von Website auslesen. Octoparse bietet mit seinen Vorlagen die Möglichkeit, schnell und einfach Daten aus dem Web auszulesen.

Was sollte bei der Wahl des Tools berücksichtigt werden?

Werden regelmäßig Daten aus dem Internet extrahiert, ist es hilfreich, ein Tool dafür zu verwenden. Mit einem spezialisierten Tool geht das Daten aus Webseiten auslesen rasch und zuverlässig. Bei der Wahl sollte darum unbedingt auf die folgenden Faktoren geachtet werden.

| Darauf sollte man achten | Warum dieser Faktor wichtig ist |

| Das Web Scraping Tool sollte leistungsstark sein | Das gewählte Tool sollte Daten von jeder Webseite oder Plattform, egal ob beliebt oder weniger bekannt, ohne Effizienzverlust extrahieren können |

| Der einfache Import der Daten in Excel | Der Import in Excel sollte ohne Codeeingabe oder weitere Bestätigungen erfolgen um Zeit zu sparen |

| Die Kosten für das genutzte Tool | Das gewählte Tool sollte eine kostenlose Möglichkeit des Excel Daten von Website auslesen enthalten. Damit kann es vor einer Entscheidung zum Kauf getestet werden! Die Preisgestaltung generell und für zusätzliche Funktionen sollte transparent sein |

| Kombinationsmöglichkeiten mit unterschiedlichen Plattformen oder Apps | Das gewählte Tool muss es ermöglichen, mit unterschiedlichen Plattformen und Apps kombinierbar zu sein, damit kein Kontowechsel beim Auslesen von Daten notwendig wird. |

Werden diese Faktoren bei der Wahl eingehalten haben Sie sicherlich Erfolg beim Datenauslesen aus Webseiten. Sie erhalten rasch die benötigten Daten und können sie nach Bedarf speichern.

Web Scraping mit Octoparse

Rund 500 Vorlagen bietet Octoparse, damit Daten einfach und schnell extrahiert werden können. Die einzelnen Vorlagen machen es sogar möglich, bestimmte Daten gezielt zu extrahieren. Durch die benutzerfreundliche Gestaltung kann wirklich jeder gezielt die Daten aus einer Webseite auslesen und in Excel importieren. Dabei ist es ganz egal, ob es sich um Daten für die Marktforschung oder die Lead-Generierung handelt. Auch das Daten-Scraping für Analysen im Immobilienbereich steht zur Verfügung.

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.

Hier finden Sie eine Videoanleitung zum Extrahieren von Daten von jeder Website nach Excel. Nach dem Ansehen erhalten Sie einige Ideen. Oder Sie können den einfachen Schritten in den nächsten Teilen folgen, um Websitedaten ohne Codierung nach Excel zu extrahieren.

3 Schritte zum Scrapen von Daten aus einer Website in Excel 👉

Mit der folgenden Schritt für Schritt Anleitung können Sie rasch die gewünschte Daten in eine Excel-Tabelle speichern und weiter bearbeiten.

✅ Schritt 1: Fügen Sie die URL der Ziel-Website ein, um die automatische Erkennung zu starten.

✅ Schritt 2: Erstellen und ändern Sie den Workflow

Nach der automatischen Erkennung wird ein Workflow erstellt. Sie können das Datenfeld einfach nach Ihren Bedürfnissen ändern. Es wird ein Tipps-Panel eingeblendet, und Sie können die darin enthaltenen Hinweise befolgen.

✅ Schritt 3: Extrahierte Daten nach Excel exportieren

Führen Sie die Aufgabe aus, nachdem Sie alle Datenfelder überprüft haben. Sie können die gescrapten Daten schnell im Excel/CSV-Format auf Ihr lokales Gerät herunterladen oder in einer Datenbank speichern.

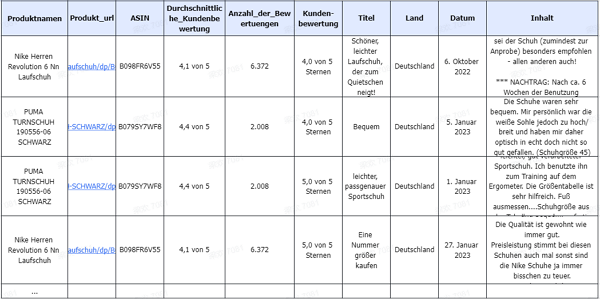

Extraktion mit Aufgabenvorlagen

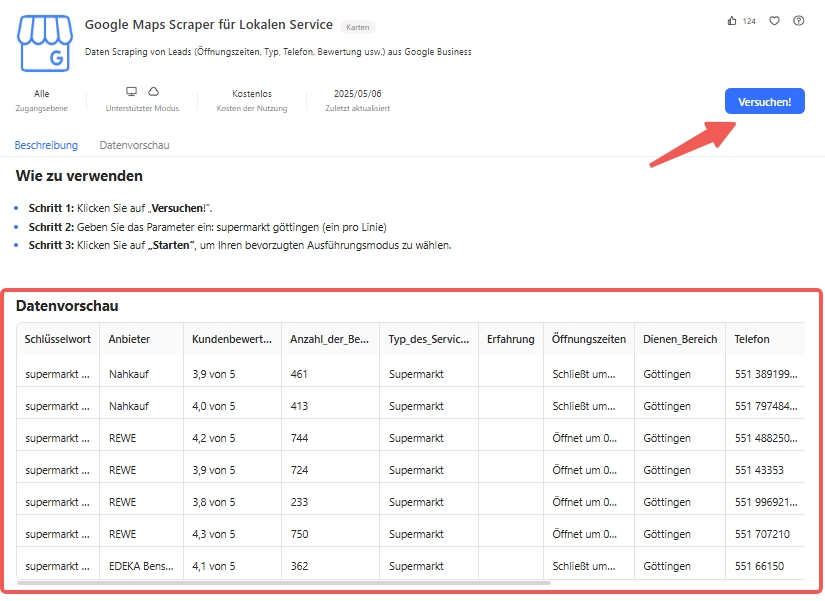

Als einfacher Web Scraper bietet Octoparse automatische Erkennungsfunktionen, die auf KI basieren, um Daten automatisch zu extrahieren. Was Sie tun müssen, ist einfach zu überprüfen und einige Änderungen vorzunehmen. Sie können auch die voreingestellten Daten-Scraping-Vorlagen für beliebte Websites wie Amazon, eBay, LinkedIn, Google Maps usw. verwenden, um die Webseitendaten mit wenigen Klicks zu erhalten. Probieren Sie die untenstehende Online-Scraping-Vorlage aus, ohne eine Software auf Ihre Geräte herunterzuladen.

https://www.octoparse.de/template/google-business-local-services-scraper

✅ Schritt 1: Wählen Sie eine Vorlage für Web Scraping

✅ Schritt 2: Verwenden Sie die Vorlage

✅ Schritt 3: Klicken Sie auf “Versuchen” und beginnen Sie mit der Extraktion

Nachdem Sie mit Octoparse Daten gesammelt haben, müssen Sie diese möglicherweise in Excel verarbeiten. Damit Sie die neuen Funktionen von Excel optimal nutzen können, finden Sie hier eine ausführliche Anleitung mit einigen nützlichen Hinweisen und Tipps.

Fazit

Zusammenfassend kann gesagt werden, dass Octoparse eine enorme Anzahl an Möglichkeiten zum Daten aus dem Web extrahieren bietet. Gerade in der Marktforschung oder der Automatisierung von Unternehmen ist es eine Methode, um rasch auf den veränderten Markt reagieren zu können. Die Ergebnisse können in der Unternehmensstrategie danach umgesetzt werden.

Das Daten von Website in Excel importieren stellt eine Möglichkeit dar, große Datenmengen innerhalb kurzer Zeit zusammenfassen zu können. Die Daten in Excel zu importieren, vereinfachen die Bearbeitung und Analyse enorm. So ist man innerhalb kurzer Zeit und ohne langes Suchen immer gut informiert.

FAQ

Einige immer wieder auftretende Fragen zum Thema Daten aus Webseiten extrahieren und speichern. Mit der Beantwortung dieser Frage ist es für Sie sicherlich einfacher, sofort mit dem Web-Scraping zu beginnen.

Was ist die einfachste Möglichkeit für Web Scraping?

Die einfachste Möglichkeit für das Web Scraping ist das Verwenden einer Scraping-Lösung wie zum Beispiel Octoparse. Damit können Sie mit Hilfe moderner Technologie in großem Umfang Daten scrapen. Einfach die Seite aufrufen, die gewünschte Vorlage auswählen, damit ist das Scraping um vieles einfacher, und loslegen. Die erforderlichen Daten erhalten Sie innerhalb kurzer Zeit und Sie können sie im beliebigen Format abspeichern.

Daten Scraping und KI?

Daten aus einer Webseite auslesen und in Excel importieren kann durch die künstliche Intelligenz schneller und gezielter durchgeführt werden. Die KI Algorithmen kombiniert mit den Weg Scraping Prozessen bieten den Vorteil, erforderliche Daten gezielt und automatisch zu liefern. Ein KI-gestütztes Scraping Tool, Octoparse zum Beispiel, eignet sich hervorragend, um die Daten von dynamischen Webseiten auszulesen. Dynamische Webseiten weisen im Übrigen Veränderungen in der Struktur und im Design auf, wodurch das Auslesen der Daten erschwert ist.

Kann man mit Octoparse auch aus Instagram Daten scrapen?

Octoparse bietet rund 500 Vorlagen, um aus dem Internet gezielt Daten zu scrapen. Dazu zählt selbstverständlich auch die Internet Plattform Instagram. Wählen Sie die gewünschte Plattform wie zum Beispiel Instagram, Tiktok, Twitter (jetzt X) oder Facebook. Scrapen Sie die von Ihnen benötigten Daten wie zum Beispiel E-Mail, Bewertungen, Namen, Telefonnummern, Rezensionen, Orte und vieles mehr. Sie können sogar durch die Keywordsuche Standorte in Google Maps auslesen und in Ihrer Tabelle speichern.

Wie wird sich das Daten von Website in Excel importieren in der Zukunft weiterentwickeln?

Daten von Website in Excel importieren wird durch KI in Zukunft zugänglicher, intelligenter und schneller werden. Durch KI unterstützte Tools wie zum Beispiel Octoparse, kann man Daten rasch und unkompliziert von Websites extrahieren. Es können aber auch regelmäßige Updates erstellt und diese automatisiert verarbeitet werden. Das funktioniert mittlerweile auch schon mit Multimedia-Inhalten. Mit Octoparse haben Sie eine wertvolle Unterstützung für das Auslesen von Multimedia-Inhalten.

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.

👉 Dieser Artikel ist ein Originalinhalt von Octoparse.