Web-Scraping ist eine beliebte Methode zur kostengünstigen Datenerfassung. Viele Unternehmen zögern jedoch aufgrund unklarer Kostenstrukturen. In diesem Artikel werden gängige Web-Scraping-Verfahren und ihre Kosten vorgestellt, um eine bessere Entscheidungsgrundlage zu bieten.

Die Lösungen und Kosten von Web Scraping

Es gibt eine Vielzahl von Möglichkeiten, wie ein Unternehmen Web Scraping durchführen kann.

Lösung 1: Outsourcing an einen Drittanbieter

Das Outsourcing eines Web-Scraping-Projekts bedeutet, dass Sie ein anderes Team oder eine andere Person beauftragen, die Scraping-Aufgabe für Sie zu erledigen. Die Unternehmen, die kein eignes Tech-Team für Daten-Scrapen haben, können das Service externer Einrichtungen in Anspruch nehmen. Wie z.B. Upwork und Guru, die Ihnen bessere Daten Service anbieten können.

Ein Daten-Team anstellen

Ein Web-Scraping-Team besteht aus technischen Fachleuten, die sich zu einer Web-Scraping-Agentur zusammenschließen. Bei einem Team-Service können die Web-Scraping-Kosten je nach Umfang des Auftrags hoch oder niedrig sein. Die Kosten liegen in der Regel zwischen 600 und 1000 Euro.

Wenn Sie den Service eines Teams in Anspruch nehmen möchten, stellen Sie sicher, dass Sie dessen Glaubwürdigkeit überprüfen, bevor Sie einen Vertrag mit ihm unterzeichnen.

Kooperation mit Freiberuflern nehmen

Mit dem Aufkommen der Gig-Wirtschaft wird diese Option immer beliebter. Bei Freiberuflern hängen die Kosten für das Web-Scraping hauptsächlich vom Ermessen des Freiberuflers ab, so dass der Preis stark variiert. Einen guten Freiberufler können Sie schon für 30 Euro/Stunde bekommen. Erfahrene Freiberufler können Ihnen bis zu 100 Euro/Stunde berechnen.

Lösung 2: Scraper selbst erstellen

Wenn Sie ein Entwickler sind oder ein Entwicklerteam in Ihrem Unternehmen haben, können Sie intern einen Scraper erstellen, um die Anforderungen des Web Scraping zu erfüllen. Das hört sich einfach an, denn es gibt viele Kurse und Videos, in denen gezeigt wird, wie man ein Web-Scraping-Skript mit Python oder Javascript schreibt. Sie werden jedoch viel Zeit damit verbringen, Verbesserungen vorzunehmen und Fehler zu beheben, und am Ende werden Sie feststellen, dass Sie viel mehr Geld ausgegeben haben, als Sie erwartet hatten. Die Kosten liegen zwischen 200 und 1000 Euro pro Monat, je nach dem Gehalt Ihres Entwicklers.

Lösung 3: Scraper mit Web Scraping Tools erstellen

Die Erstellung eines programmierten Scrapers von Grund auf ist zu zeitaufwändig. Wenn Sie den Scraper nicht selbst erstellen wollen, gibt es einen viel einfacheren Weg: Verwenden Sie ein Web Scraping Tool, um einen Scraper zu erstellen. Web-Scraping-Tools sind Software, die speziell für das Sammeln und Zusammentragen von Daten im Internet entwickelt wurde und das Web-Scraping zu einem Kinderspiel machen soll.

Es ist wichtig, das richtige Web-Scraping-Tool zu wählen, und hier sind unsere Top-Tipps:

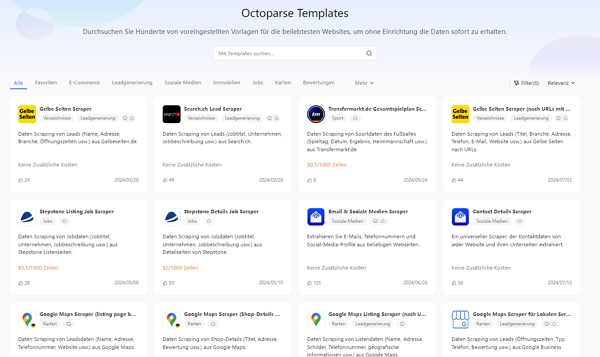

1. Octoparse

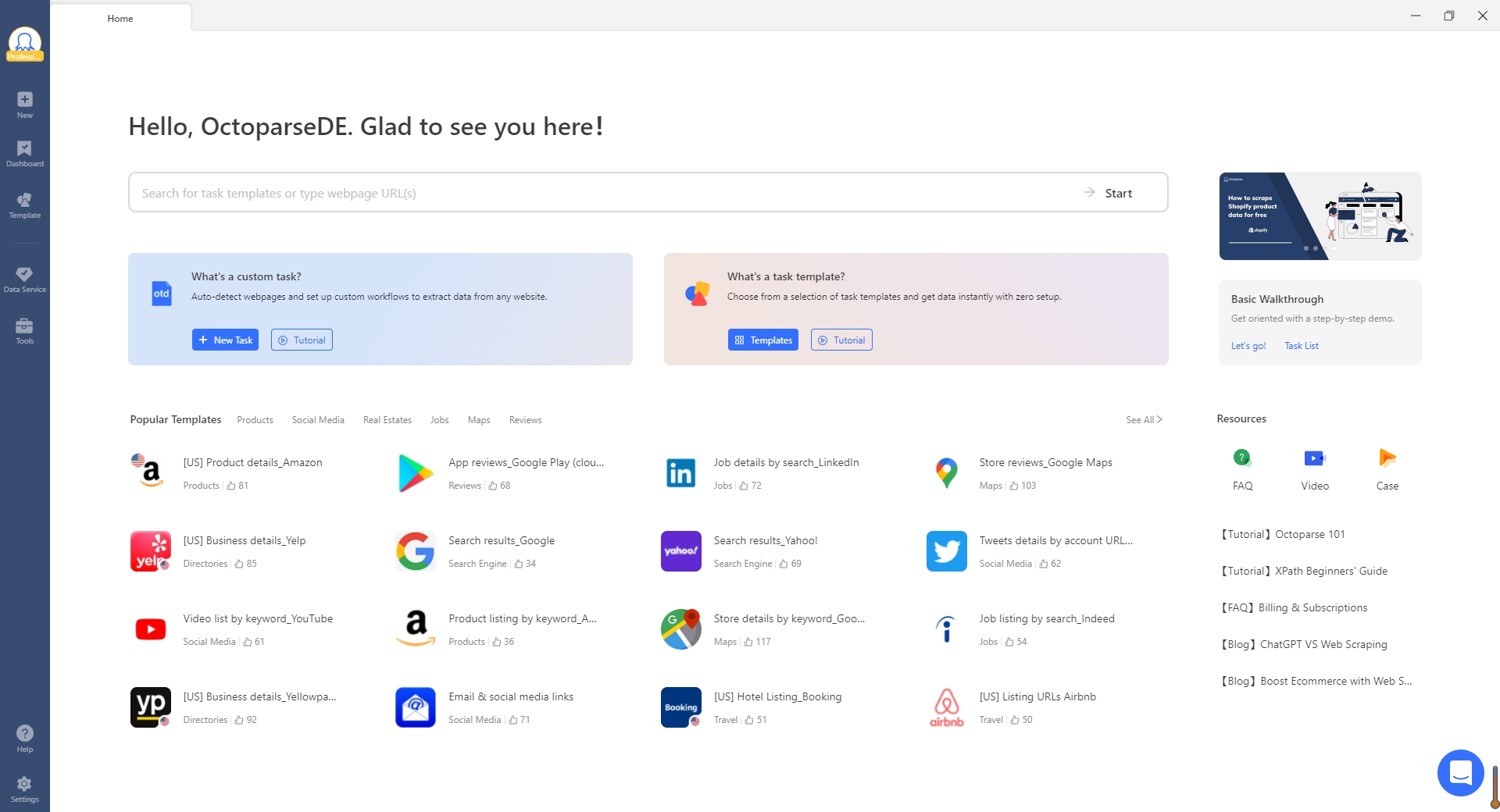

Octoparse ist ein Cloud-basierter Web-Crawler, mit dem Sie Webdaten einfach und ohne Programmierung extrahieren können. Mit einer benutzerfreundlichen Oberfläche kann es leicht mit allen Arten von Websites umgehen, egal JavaScript, AJAX oder jede dynamische Website. Sein fortschrittlicher Algorithmus für maschinelles Lernen kann die Daten genau lokalisieren, wenn Sie darauf klicken. Octoparse kann unter einem kostenlosen Plan verwendet werden und kostenlose Testversion von kostenpflichtigen Versionen ist ebenfalls verfügbar. Es unterstützt die Xpath-Einstellung, um Webelemente genau zu lokalisieren, und die Regex-Einstellung, um extrahierte Daten neu zu formatieren. Die extrahierten Daten können über Excel/CSV oder API abgerufen oder in Ihre eigene Datenbank exportiert werden. Octoparse verfügt über eine leistungsstarke Cloud-Plattform, um wichtige Funktionen wie geplante Extraktion und automatische IP-Rotation zu erreichen.

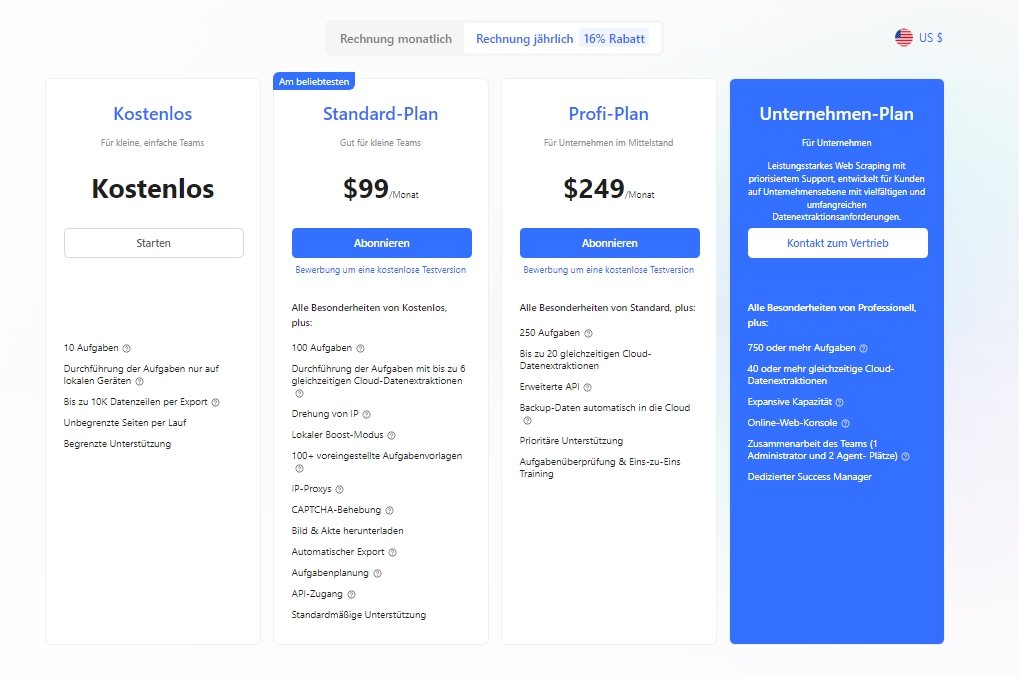

Bei Octoparse kann jeder Benutzer um einen 14-tätigen Gratis-Plan beantragen. Außerdem gibt es auch vier kostenpflichtige Versionen: Standard-Plan (99 USD/Monat), Profi-Plan (249 USD/Monat) und kundenspezifischer Unternehmen-Plan.

Octoparse bietet über 100 benutzerfreundliche Vorlagen, um Daten zu extrahieren. Ob Sie nun Produktinformationen von einer Website extrahieren möchten oder Kontaktdaten aus einem Verzeichnis – mit Octoparse ist es einfach, die benötigten Daten zu sammeln. Mit einer Vielzahl von Vorlagen können Sie Zeit sparen und effizienter arbeiten. Egal, ob Sie ein Anfänger oder ein erfahrener Benutzer sind, Octoparse bietet Ihnen die Werkzeuge, die Sie benötigen, um Webdaten schnell und einfach zu extrahieren.

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Hier bekommen Sie Octoparse! 🤩

Preis: $0~$249 pro Monat

Packet & Preise: Octoparse Premium-Preise & Verpackung

Kostenlose Testversion: 14-tägige kostenlose Testversion

Herunterladen: Octoparse für Windows und MacOs

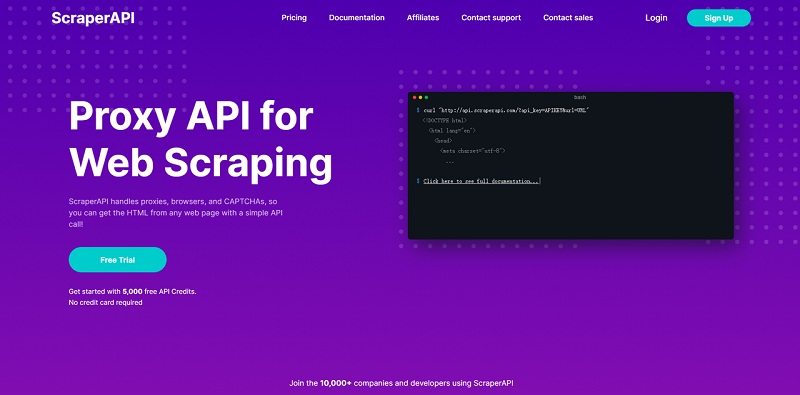

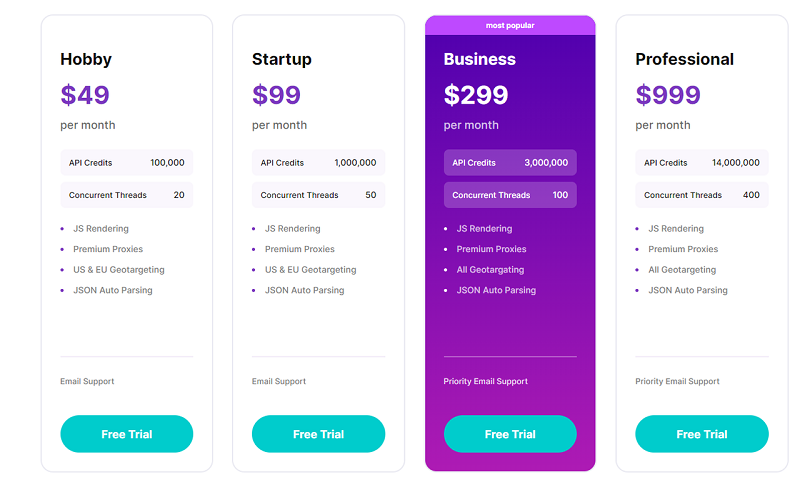

2. ScraperAPI

Bei dem Programm ScraperAPI handelt es sich um eine Software, mit der sich Webinhalte abgreifen lassen. Dazu stellt das Unternehmen eine eigene Schnittstelle zur Verfügung, mit der auf unterschiedliche Art und Weise Inhalte von Websites gezogen werden können. Die Entwickler versprechen, dass das Programm auch mit Sicherheitsmechanismen der betroffenen Seiten umgehen und die Websites dennoch durchsuchen und die Inhalte abgreifen kann. ScraperAPI ist ein Tool, das für Entwickler und IT-Unternehmen entwickelt wurde. Für den Einsatz des Tools ist technisches Verständnis von Java, Ruby, PHP, Node, Bash oder Python hilfreich.

Bei ScraperAPI kann sich jeder Benutzer um ein 7-tätiges Trial bewerben. Außerdem gibt es auch vier kostenpflichtige Versionen: Hobby (49 USD/Monat), Startup (99 USD/Monat), Business (299 USD/Monat) und Professional (999 USD/Monat).

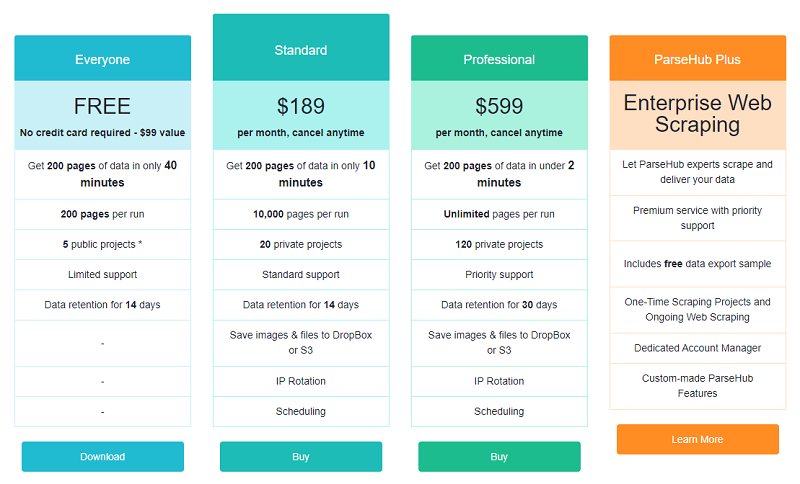

3. Parsehub

Parsehub, eine Cloud-basierte Desktop-App für Data Mining, ist ein weiterer einfach zu bedienender Scraper mit einer Grafik-App-Schnittstelle. Es funktioniert mit allen interaktiven Seiten und verwirklicht einfach und automatisch eine problemlose Duchsuchung der Formulare, Dropdowns und Anmeldungen auf Websites. Mit eingesetzter Technik ist es leicht, die Daten auf der Website von oben nach unten automatisch auszulesen. Die Registerkarte und Pop-ups sind auch leicht in Behandlung. Die Daten werden in Sekunden abgerufen und über API in CSV/ Excel, Google Sheet oder Tableau gespeichert für den späteren Zugriff.

Parsehub ist kostenlos zu starten aber es gibt auch Grenze für die Extraktionsgeschwindigkeit (200 Seiten in 40 Minuten), Seiten pro Lauf (200 Seiten) und die Anzahl der Projekte (5 Projekte) im 14-tätigen Gratis-Plan. Wenn Sie eine hohe Extraktionsgeschwindigkeit oder mehr Seiten benötigen, sollten Sie besser einen Standard-Plan (189 USD/ Monat) oder einen Professional-Plan (599 USD/ Monat) beantragen.

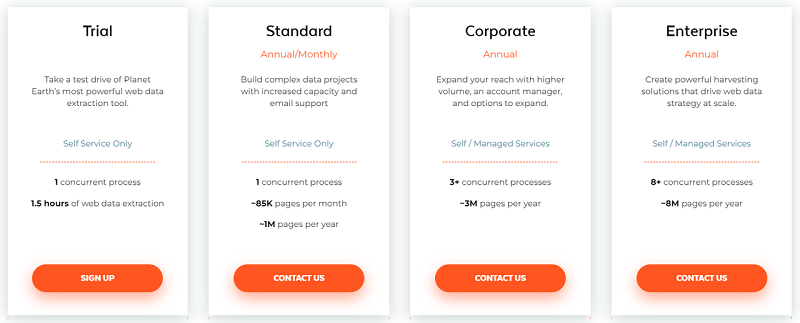

4. Mozenda

Mozenda ist ein erweiterter webbasierter Scraper, das mit über 10 Jahren Erfahrung ermöglicht, deine Web-Datenextraktion von jeder Website zu automatisieren. Mit Mozenda können Sie nicht nur Websites durchsuchen, sondern auch Daten in Dokumenten wie Excel, Word, PDF usw. extrahieren. Es unterstützt die Zugriff von Ergebnissen im CSV-, TSV-, XML- oder JSON-Format oder direkt in gängigen BI-Tools wie Amazon Web Services oder Microsoft Azure® für schnelle Analysen und Visualisierungen. Mozenda bietet ein kostenloses 30-Tage-Trial an. Sie können auch die anderen Pläne wählen: Standard Annual/Monthly, Corporate Annual oder Enterprise Annual.

5. ScrapeStorm

ScrapeStorm ist ein KI-basiertes visuelles Web-Scraping-Tool, mit dem Daten von fast allen Websites extrahiert werden können, ohne Code schreiben zu müssen. Es ist leistungsstark und sehr nutzerfreundlich. Für erfahrene und unerfahrene Nutzer stehen zwei verschiedene Scraping-Modi zur Verfügung (Smart Mode und Flowchart Mode).

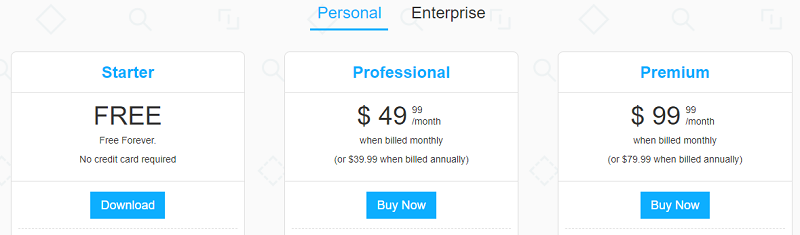

ScrapeStorm unterstützt Windows, MacOS und Linux.Sie können die Ausgabedaten in verschiedenen Formaten speichern, einschließlich Excel, HTML, Txt und CSV. Außerdem können Sie Daten in Datenbanken und Websites exportieren. Sie können eine kostenlose Testversion herunterladen, aber maximal 100 Aufgaben pro Agent. Sie können auch die anderen Pläne wählen: Professional (49.99USD /Monat) oder Premium (99.99 USD/Monat) wählen.

Lösung 4: Web Scraping Service

Wenn Sie sich den Stress oder die Lernkurve bei der Erstellung eines Scrapers nicht antun wollen, können Sie sich einfach für einen verwalteten Datenservice entscheiden. Alles, was Sie tun müssen, ist, dem Web Scraping-Dienstleister die Websites zu nennen, die Sie scrapen möchten, und er wird Ihnen alle benötigten Daten liefern. Das heißt, Sie müssen keine Zeit damit verbringen, sich in Software einzuarbeiten.

Viele Web-Scraping-Tools, wie die oben genannten, bieten Web Scraping Service an. Die Kosten für den Datenservice hängen stark von den spezifischen Datenanforderungen ab. Sie müssen den Web Scraping Service Provider kontaktieren, um ein Angebot zu erhalten. Normalerweise beginnen die Preise bei 399 Dollar.

Drei Dingen zu bestimmen, vor der Entscheidung für Web Scraping

Jetzt haben Sie die gängigsten Methoden für das Web-Scraping kennengelernt. Der nächste Schritt besteht darin, sich für einen Ansatz zu entscheiden, um loszulegen. Bevor Sie sich für eine Web Scraping Lösung entscheiden, sind einige Dinge zu beachten, die sich auf die Kosten auswirken und die Qualität der Daten bestimmen können.

Die Häufigkeit des Scrapings

Wenn Sie vorhaben, häufig große Datenmengen zu scrapen, kann es sein, dass die Website, von der Sie scrapen, Sie nach einiger Zeit für das Scraping sperrt. In diesem Fall müssen Sie sicherstellen, dass Ihr Web-Scraping-Tool über eine IP-Rotation verfügt, um eine Sperrung zu vermeiden, oder dass Ihr Web-Scraping-Team in der Lage ist, Anti-Scraping-Probleme zu lösen.

Octoparse verfügt über eine automatische IP-Rotation bei der Cloud-Extraktion und bei der lokalen Extraktion (Sie können benutzerdefinierte Proxys manuell hinzufügen). Im Gegensatz zu anderen Web-Scraping-Tools können Sie bei Octoparse benutzerdefinierte IPs ohne zusätzliche Kosten hinzufügen. Hier können Sie mehr über IP-Rotation erfahren.

Die Anzahl der Websites

Bevor Sie sich für eine Scraping-Methode entscheiden, müssen Sie auch die Anzahl der Websites berücksichtigen, die Sie scrapen wollen. Die Verwaltung von Scraping-Crawlern für so viele Websites kann ein Alptraum sein. Viele Unternehmen ziehen es vor, einen Web-Scraping-Service zu beauftragen, damit sie sich nicht um die ganze Wartungsarbeit kümmern müssen.

Wenn Sie es selbst machen wollen, sollten Sie ein Web-Scraping-Tool verwenden, das in der Lage ist, eine große Anzahl von Websites zu verarbeiten, alle Crawler gleichzeitig zu verwalten und die Datenübertragung in verschiedene Systeme zu integrieren. Alternativ können Sie auch ein Team oder einen Freiberufler beauftragen, der sich um das gesamte Projekt kümmert und Ihre Zeit spart.

Die Qualität der gescrapten Daten

Neben der Häufigkeit des Scrapings und der Anzahl der Scraping-Sites sollten Sie auch auf die Datenqualität achten, einschließlich der Datenabdeckung und der Datengenauigkeit. Sie müssen sicherstellen, dass der von Ihnen gewählte Ansatz das Scrapen ermöglicht, ohne dass wichtige Daten verloren gehen oder Daten verlegt werden. In manchen Fällen müssen die Daten für die Datenanalyse bereinigt werden. Bevor Sie eine Dienstleistung in Anspruch nehmen, sollten Sie Ihre Datenanforderungen klar formulieren. Und fragen Sie immer nach Beispieldaten, um sicherzustellen, dass die Datenergebnisse Ihren Anforderungen entsprechen.

Zusammenfassung

Nachdem Sie nun über die Kosten des Web Scrapings Bescheid wissen, ist es an der Zeit, den nächsten Schritt zu machen und das Tool oder den Service auszuwählen, der zu Ihrem Budget und Ihren Anforderungen passt. Wenn Sie gerade erst anfangen, sich mit dem Thema zu beschäftigen, könnte Octoparse eine großartige Option für Sie sein, um Webdaten in großem Umfang ohne Programmierkenntnisse abzurufen. Probieren Sie Octoparse 14 Tage lang kostenlos aus und entdecken Sie die Welt der Daten!

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Autor*in: Das Octoparse Team ❤️

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.