Unstrukturierte Daten von Webseiten werden in strukturierte Formate umgewandelt, die leicht gespeichert und analysiert werden können. Diese Technologie ist in Bereichen wie Nachrichten, E-Commerce und sozialen Medien weit verbreitet und verbessert die Effizienz sowie die Genauigkeit der Datenerfassung erheblich.

Was ist Web Scraping?

Web Scraping, das auch als Web Harvesting, Web Crawling und Data Scraping genannt wird, bedeutet hauptsächlich Datenerfassung von Webseiten per das Hypertext Transfer Protocol (HTTP) oder durch den Webbrowser.

Web Scraping wird verwendet, um Informationen von Websites zu extrahieren, die dann für verschiedene Zwecke verwendet werden können, wie zum Beispiel für Marktforschung, Preisvergleiche oder zur Überwachung von Online-Inhalten.

Es gibt verschiedene Tools und Techniken, die für das Web Scraping eingesetzt werden, darunter spezielle Software, die automatisierte Bots verwendet, um Daten von Websites zu sammeln. Ist Web Scraping legal? Es ist jedoch wichtig zu beachten, dass Web Scraping rechtliche und ethische Bedenken hervorrufen kann, insbesondere wenn es gegen die Nutzungsbedingungen einer Website verstößt. Daher ist es ratsam, vor dem Web Scraping die rechtlichen Rahmenbedingungen zu prüfen und gegebenenfalls die Erlaubnis des Website-Betreibers einzuholen.

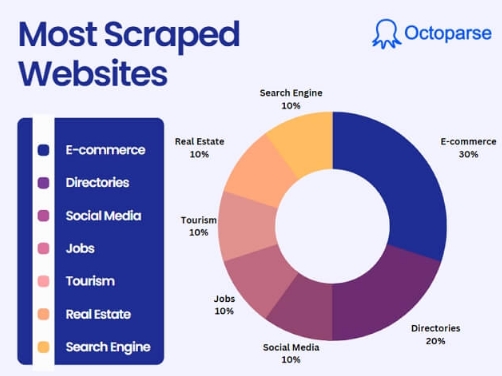

Der Einsatz von Web Scraping

Web-Scraping wird in verschiedenen Bereichen eingesetzt, z. B. in Nachrichtenportalen, Blogs, Foren, E-Commerce-Websites, sozialen Medien, Immobilien, Finanzberichten usw. Und auch die Zwecke des Web-Scrapings sind vielfältig, z. B. Kontakt-Scraping, Online-Preisvergleich, Erkennung von Website-Änderungen, Webdatenintegration, Wetterdatenüberwachung, Forschung usw.

Web Scraping Techniken

Die Web-Scraping-Technik wird durch Web-Scraping-Software-Tools realisiert. Die Tools interagieren mit Websites auf die gleiche Weise, wie Sie bei der Verwendung eines Webbrowsers wie Chrome tun. Web-Scrapers können nicht nur Daten in einem Browser anzeigen, sondern auch die Daten von Webseiten extrahieren und sie in einem lokalen Ordner oder einer Datenbank speichern. Es gibt viele Web-Scraping-Software-Tools im Internet. Octoparse ist eines davon sein, dessen Wert darin liegt, dass Sie beliebige Webdaten einfach und kostenlos extrahieren können, selbst wenn Sie eine große Menge an Quelldaten von dynamischen Webseiten (Website, die sich sehr häufig ändern) sammeln möchten.

Web-Scraping-Tools wie Octoparse ermöglichen es Ihnen, Web-Scraping-Aufgaben so zu konfigurieren, dass sie auf mehreren Websites gleichzeitig ausführen. Sie können jede Extraktionsaufgabe auch so planen, dass sie automatisch und so häufig wie gewünscht ausgeführt werden, z. B. stündlich, täglich, wöchentlich oder monatlich.

Moderne Anwendungsfälle von Web Scraping

1. Markt- und Wettbewerbsanalyse

Preisüberwachung und Wettbewerberanalyse leicht gemacht! Mit einem leistungsstarken Web Scraper können Sie Preise, Rabatte und Angebote von E-Commerce-Websites verfolgen sowie wichtige Daten wie Produktdetails und Kundenbewertungen Ihrer Wettbewerber extrahieren. Diese Informationen ermöglichen es Ihnen, eine Preisvergleichs-Website zu erstellen, die Käufern hilft, die besten Angebote zu finden. So erfüllen Sie ein wichtiges Bedürfnis und generieren Tausende von Zugriffen – Monat für Monat. Profitieren Sie von datenbasierten Einblicken und verschaffen Sie sich einen Wettbewerbsvorteil!

2. Lead-Generierung und Sales-Strategien

Die Extraktion geschäftlicher Kontaktdaten, etwa aus Gelbe Seiten, LinkedIn oder Unternehmensverzeichnissen, bildet die Grundlage für erfolgreiche B2B-Marketing-Kampagnen. Kombiniert mit der Analyse sozialer Netzwerke können Sie potenzielle Zielgruppen präzise identifizieren und personalisierte Angebote erstellen, die exakt auf deren Bedürfnisse abgestimmt sind. Diese datengetriebene Herangehensweise ermöglicht es Ihnen, relevanter und effektiver mit Ihren Kunden zu kommunizieren – der perfekte Weg, um Ihre Kampagnen auf das nächste Level zu heben und messbare Erfolge zu erzielen.

3. Immobilien- und Job-Marktplätze

Die Überwachung des Immobilienmarkts durch automatische Datensammlung von Immobilienportalen ermöglicht es, Preise, Verfügbarkeit und Standortinformationen stets im Blick zu behalten. Gleichzeitig bietet das Scraping von Stellenanzeigen eine ideale Grundlage, um Trends im Arbeitsmarkt zu erkennen oder schneller auf neue Jobmöglichkeiten zu reagieren. Beide Ansätze liefern wertvolle Einblicke, die Sie dabei unterstützen, fundierte Entscheidungen zu treffen und sowohl beruflich als auch privat einen Wettbewerbsvorteil zu erzielen.

4. Content-Aggregation und Recherche

Die Zusammenstellung von Nachrichtenartikeln zu spezifischen Themen durch Scraping von Nachrichten-Websites ermöglicht eine gezielte Content-Kuration, die aktuelle und relevante Informationen bereitstellt. Gleichzeitig eröffnet die Extraktion aus Open-Access-Datenbanken eine Fülle wissenschaftlicher Daten, die als Basis für Forschungsprojekte dienen. Beide Ansätze schaffen einen strukturierten Zugang zu Wissen und fördern datengetriebene Entscheidungsprozesse in verschiedenen Bereichen.

5. Finanzanalysen und Investitione

Das Live-Tracking von Aktienkursen und Finanzdaten liefert entscheidende Informationen für fundierte Investitionsentscheidungen. Ergänzend dazu ermöglicht das Sammeln von Finanzberichten und geschäftsrelevanten Daten eine gründliche Due-Diligence-Prüfung, um Unternehmensbewertungen präzise durchzuführen. Diese datenbasierte Herangehensweise bietet eine solide Grundlage für strategische Finanzentscheidungen und minimiert gleichzeitig Risiken bei Investitionen oder Geschäftsabschlüssen.

6. E-Commerce-Optimierung

Die Analyse von Kundenbewertungen auf Plattformen wie Amazon oder eBay bietet wertvolle Einblicke, um eigene Produkte kontinuierlich zu verbessern und an den Bedürfnissen der Zielgruppe auszurichten. Gleichzeitig ermöglicht das Verfolgen von Bestsellern, Neuheiten und Kategorien, aktuelle Markttrends zu erkennen und proaktiv auf Veränderungen zu reagieren. Diese datengetriebenen Strategien helfen dabei, wettbewerbsfähig zu bleiben und Produkte sowie Angebote optimal an die Anforderungen des Marktes anzupassen.

7. Reise- und Tourismusbranche

Durch das Scraping von Flug- und Hotelpreisen lassen sich Reisevergleichsplattformen erstellen, die Nutzern helfen, die besten Angebote zu finden. Ergänzt durch die Analyse von Bewertungen und Empfehlungen auf Plattformen wie TripAdvisor oder Google Maps können die attraktivsten Reiseziele und zuverlässigsten Dienstleistungen identifiziert werden. Mit diesen datenbasierten Insights wird die Reiseplanung einfacher, transparenter und garantiert die besten Erlebnisse für Ihre Kunden.

8. Automotive Website erstellen

Das Web Scraping kann auch verwendet werden, um eine Automotive Website zu erstellen, auf der aggregierte Auto-Listings angezeigt werden. Ein Scraping Car Listing würde bedeuten, dass Web-Crawler bestimmte Daten aus relevanten Quellen wie Websites von Fahrzeugunternehmen und anderen Automobil-Websites kratzen. Alle Informationen über verschiedene Autos zu haben, würde dazu beitragen, das Einkaufserlebnis Ihrer Nutzer zu verbessern.

9. Sportdatenservice anbieten

Die Sportdaten-Dienstleister sind Websites, die Sportdaten wie Spielerprotokolle, Spielverlauf und Sportagenturen in jeder Sportsaison verkaufen. Auch Sie können eine Website mit demselben Ziel erstellen. Es ist ein großer Markt mit wenig Wettbewerb.

Der Grund dafür ist, dass Sportdaten riesig sind. Sie können auf verschiedene Arten von verschiedenen Unternehmen mit unterschiedlichen Zielen interpretiert werden. Die Sportwetten-Buchmacher verwenden beispielsweise Sportdaten, um Wettquoten festzulegen.

10. Job Aggregator Website erstellen

Ein Job Aggregat ist eine Website, die Stellenangebote von verschiedenen Websites in einer durchsuchbaren Online-Benutzeroberfläche zusammenfasst. Menschen gehen online, um nach Jobs zu suchen. Wenn Sie also Stellenanzeigen von Indeed, LinkedIn und anderen relevanten Quellen durchsuchen können, sollten Sie in der Lage sein, eine Website zu erstellen, die Arbeitssuchenden hilft, einen guten Job zu finden.

Wie funktioniert Web Scraping?

Im Allgemeinen umfasst Web Scraping drei Schritte:

- Erstens senden wir eine GET-Anfrage an den Server. Dann werden wir eine Antwort in Form von Webinhalten erhalten.

- Nächstes analysieren wir das HTML-Code einer Webseite mit der Baumstrukturroute.

- Schließlich verwenden wir die Python-Bibliothek, um nach dem Parse-Baum zu suchen.

Ich weiß, was Sie jetzt denken – Zwar sieht Web Scrapping auf dem Papier leicht aus, ist es tatsächlich viel komplexer in der Praxis als gedacht. Wir müssen Kodierung verwenden, um die gewünschten Daten zu erhalten, aber dies erscheint zu schwierig für uns, die ohne Programmierkenntnisse erlernen. Als Alternative gibt es Scraping SAAS und Web-Scraping-Tools, die die Datenextraktion von Webseiten durch Point-and-Click automatisieren.

Ein Web Scraping Tool wie Octoparse wird die von den Benutzern angegebenen URLs laden und die gesamte Webseite scrollen, so dass die Webdaten durch einfache Schritte automatisiert extrahiert und in einer gewünschten Form auf Ihrem Computer ohne Programmieren abgelegt werden.

Es können verschiedene Daten wie Text, Bilder, Tabellen oder Links extrahiert und anschließend in einem übersichtlichen Format gespeichert werden. Octoparse bietet eine einfache Benutzeroberfläche und leistungsstarke Funktionen, um das Web Scraping effizient und benutzerfreundlich zu gestalten. Mit diesem Tool können Benutzer Zeit und Ressourcen sparen und gleichzeitig genaue und zuverlässige Daten für ihre Bedürfnisse sammeln.

Wenn Sie beispieldweise die Posten und Kommentare von Twitter extrahieren möchten, brauchen Sie nur die URL kopieren und in den Scraper einzufügen, die gewünschten Datenfelder auszuwählen sowie das Programm auszuführen. Das spart viel Zeit und Mühe bei der langweiligen Arbeit des Kopierens und Einfügens. Wie verwendet man Octoparse? Weitere Informationen finden Sie hier: Verwenden Sie Octoparse zum einfachen Web Scraping

Octoparse bietet über 100 benutzerfreundliche Vorlagen, um Daten zu extrahieren. Über 30.000 Nutzer verwenden die Vorlagenfunktion. Probieren Sie jetzt 14 Tage lang kostenlos aus.

https://www.octoparse.de/template/email-social-media-scraper

Zusammenfassung

Durch den Einsatz fortschrittlicher Tools wie Octoparse rationalisiert Web Scraping nicht nur den Prozess der Datenerfassung, sondern bietet den Nutzern auch die Flexibilität, automatisierte Aufgaben nach ihren Bedürfnissen zu planen, sei es stündlich, täglich, wöchentlich oder monatlich, um sicherzustellen, dass die Daten aktuell und genau sind und eine solide Datengrundlage für die Entscheidungsfindung bieten.

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Autor*in: Das Octoparse Team ❤️

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.