In den letzten Jahren hat jeder über Chatbots gesprochen. Große Sprachmodelle (LLM) und KI sind zu neuen Trendkonzepten geworden. Infolgedessen hat Web-Scraping viel Aufmerksamkeit erregt, da KI auf riesige Mengen an gescrapten Daten angewiesen ist. Allerdings ist Web-Scraping für Website-Besitzer nicht so willkommen. Sie setzen viele Mittel zur Verteidigung gegen Scraper ein. Um zu vermeiden, dass sie bei der Datenextraktion blockiert werden, sind immer mehr Web-Scraping-Lösungen mit IP-Proxys ausgestattet, um die Effizienz des Scrapings zu verbessern.

Verstehen, wie Websites Scraper blockieren

Ein Scraper, der Daten von einer Website abrufen will, sendet Anfragen an den Server, um den HTML-Inhalt der Seite abzurufen und die HTML-Struktur zu analysieren, um die gewünschten Daten zu extrahieren. Wenn der Scraper in kurzer Zeit zu viele Anfragen an den Server sendet, kann er den Server überlasten, was im schlimmsten Fall zum Absturz der Website führen kann. Deshalb verwenden viele Websites verschiedene Mittel, um Scraping zu verhindern.

Die gängigste Methode zur Bekämpfung von Web Scraping besteht darin, die Zugriffsrate einer einzelnen IP-Adresse zu begrenzen. Wenn zum Beispiel ein Web-Scraper in einem kurzen Zeitraum zu viele Anfragen über eine einzige IP-Adresse gestellt hat, wird die Website die IP-Adresse leicht ausfindig machen und früher oder später alle Anfragen von dieser IP-Adresse blockieren. Um eine solche Situation zu vermeiden, sollten wir das Scrapen einer Website mit einer einzigen IP-Adresse vermeiden. Daher spielen Proxyserver eine wichtige Rolle bei der Verhinderung von Blockierungen.

Was ist Proxy und wie funktioniert es?

Proxy bedeutet „im Namen eines anderen handeln“. In der Welt der Computernetze handelt ein Proxy-Server im Namen des Benutzers. Wenn wir eine Seite aufrufen, spielt ein Proxy die Rolle des Vermittlers zwischen den Endbenutzern und dem Internet. Er hilft bei der Verwaltung und Filterung von Anfragen, verbessert die Sicherheit und speichert Daten zwischen, um den Zugriff zu beschleunigen.

Wenn ein Computer eine Verbindung zum Internet herstellt, verwendet er eine IP-Adresse. Sie ist vergleichbar mit der Adresse Ihres Hauses, die eingehenden Daten mitteilt, wohin sie gehen sollen, und ausgehende Daten mit einer Absenderadresse kennzeichnet, die andere Geräte zur Authentifizierung benötigen. Ein Proxyserver ist im Grunde ein Computer im Internet, der eine eigene IP-Adresse hat. Wenn Benutzer die Proxyserver verwenden, um Anfragen an Webseiten zu stellen, gehen alle Anfragen zuerst an den Proxyserver, der die Anfrage auswertet und sie an das Internet weiterleitet. Auch die Antworten gehen zunächst an den Proxy-Server und dann an die Benutzer. Proxyserver bieten also je nach Anwendungsfall, Bedürfnissen oder Unternehmensrichtlinien ein unterschiedliches Maß an Funktionalität, Sicherheit und Datenschutz.

Warum IP-Proxy für Web Scraping wichtig ist

Wie bereits erwähnt, blockieren die Betreiber von Websites in der Regel IP-Adressen, wenn sie zu viele Anfragen von derselben Adresse innerhalb eines kurzen Zeitraums feststellen. Wenn Sie Ihre IP-Adresse zum Scrapen von Daten verwenden, wird die IP-Adresse wahrscheinlich blockiert, was zum Scheitern der Datensammlung führt. Der IP-Proxy kann solche Probleme weitgehend lösen.

IP-Sperrung vermeiden

Websites überwachen eingehende Anfragen und viele blockieren IP-Adressen, die ein verdächtiges Verhalten zeigen. Dazu gehören natürlich auch zu viele Anfragen in einem kurzen Zeitrahmen. IP-Proxys ermöglichen es Scrapern, Anfragen auf mehrere Adressen zu verteilen. Die Rotation der IP-Adressen hilft dabei, sich der Entdeckung zu entziehen und das Risiko, gesperrt zu werden, zu minimieren. Wenn zum Beispiel eine IP-Adresse einen Schwellenwert für Anfragen erreicht und blockiert wird, können andere Proxys weiterhin Anfragen stellen, um zu gewährleisten, dass die Scraper gut funktionieren.

Umgehung von geografischen Beschränkungen

Einige Websites schränken den Zugriff auf der Grundlage des Standorts der Nutzer ein, indem sie die Herkunft der IP-Adresse ermitteln. Wenn Sie Daten von Websites sammeln müssen, deren Zugriff aufgrund des Standorts oder der Lizenzierung eingeschränkt ist, können IP-Proxys helfen, indem sie den Zugriff von verschiedenen geografischen Standorten aus ermöglichen. Sie können Proxys verwenden, um sich in derselben Region wie die Zielwebsite oder in einer Region zu befinden, in der der Inhalt zugänglich ist. Dann können Sie diese geografischen Einschränkungen umgehen und auf die benötigten Daten zugreifen.

Wahrung der Anonymität

Anhaltendes Scraping von einer einzigen IP-Adresse aus kann es für Websites einfacher machen, die Scraping-Aktivitäten zu identifizieren und zu verfolgen, was zu potenziellen rechtlichen oder sicherheitsrelevanten Problemen führen kann. Im Gegensatz dazu können Proxys die Anonymität wahren und das Risiko verringern, dass die Scraping-Aktivitäten bis zur ursprünglichen Quelle zurückverfolgt werden. Denn Proxys maskieren Ihre echte IP-Adresse, indem sie Anfragen so aussehen lassen, als kämen sie von der IP des Proxys.

Verwaltung der Anfragerate

Viele Websites verfügen inzwischen über Mechanismen zur Erkennung und Abschwächung überhöhter Anfrageraten. Proxy-Pools können dieses Problem lösen, indem sie es den Benutzern ermöglichen, die Anfragen gleichmäßig auf mehrere IP-Adressen zu verteilen. So können Sie die Anfragerate effektiv verwalten und Ratenbegrenzungen und Sperrungen vermeiden.

Angesichts dieser vielen Vorteile beschleunigen IP-Proxys den Datenerfassungsprozess und ermöglichen eine effizientere Bearbeitung umfangreicher Scraping-Aufgaben. Viele Anbieter von Web-Scraping-Diensten haben dieses Phänomen erkannt und ihre Tools mit Proxy-Funktionen ausgestattet.

Vorteilen von Proxy für Web Scraping

Wenn Sie Web Scraping betreiben, ist es oft empfehlenswert, einen Proxy-Server zu verwenden, um die folgenden Vorteile zu nutzen:

– Vermeidung von Blockaden: Ein Proxy-Server kann dazu beitragen, dass Sie nicht von einer Website blockiert werden, wenn Sie viele Anfragen stellen. Websites können erkennen, dass Sie ein automatisiertes Skript verwenden, um ihre Daten abzurufen, und Ihren Zugriff blockieren. Ein Proxy kann dazu beitragen, dies zu vermeiden, indem er Ihre IP-Adresse verdeckt und es schwieriger macht, Sie zu erkennen.

– Anonymität: Ein Proxy-Server kann Ihre Identität verbergen und es schwieriger machen, Sie zurückzuverfolgen. Wenn Sie Web Scraping betreiben, möchten Sie möglicherweise anonym bleiben, um unerwünschte Aufmerksamkeit zu vermeiden.

– Geolokalisierung: Ein Proxy-Server kann dazu beitragen, dass Sie geografisch gesperrte Inhalte abrufen, indem er Ihre IP-Adresse in eine andere Region verlegt.

Wenn Sie einen Proxy-Server für Web Scraping verwenden, ist es wichtig, auf die Geschwindigkeit und Zuverlässigkeit des Servers zu achten, da langsame oder unzuverlässige Server dazu führen können, dass Sie Daten langsamer abrufen oder fehlerhaft abrufen. Außerdem sollten Sie sicherstellen, dass Sie die Nutzungsbedingungen der von Ihnen genutzten Websites einhalten und keine illegalen oder unethischen Handlungen ausführen.

Top 4 Web Scraping Tool mit IP Proxy

IP-Proxys funktionieren recht effektiv, um Website-Blockaden zu umgehen. Eine einfache Möglichkeit, IP-Proxys zu nutzen, ist die Verwendung von Web-Scraping-Tools, die bereits solche Proxy-Funktionen anbieten, wie Octoparse. Diese Tools können mit den Ihnen zur Verfügung stehenden IP-Proxys oder mit den in die spezifischen Tools integrierten IP-Proxy-Ressourcen eingesetzt werden.

Es wird immer empfohlen, ein Web-Scraping-Tool zu verwenden, das mit IP-Proxys arbeitet, wenn Sie Websites scrapen müssen, die eine Art von Anti-Scraping-Maßnahmen verwenden. Einige beliebte Scraper-Tools sind Octoparse, Mozenda, Parsehub und Screen Scraper.

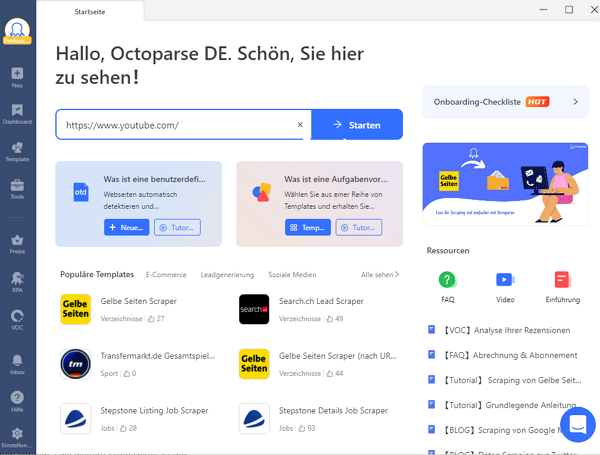

Octoparse

Octoparse ist ein leistungsstarkes und kostenloses Web-Scraping-Tool, das fast alle Websites scrapen kann. Seine Cloud-basierte Datenextraktion läuft mit einem großen Pool von Cloud-IP-Adressen, was die Wahrscheinlichkeit, blockiert zu werden, minimiert und Ihre lokalen IP-Adressen schützt. Octoparse verfügt über mehrere länderbasierte IP-Pools, aus denen Sie auswählen können, so dass Sie Websites, die nur für IPs einer bestimmten Region/eines bestimmten Landes zugänglich sind, effektiv scrapen können. Mit Octoparse können Sie auch dann, wenn Sie den Crawler auf Ihrem lokalen Gerät ausführen, eine Liste von benutzerdefinierten Proxys verwenden, um den Crawler auszuführen, damit Ihre echte IP nicht preisgegeben wird. (Hier ist eine Anleitung, wie man Proxys in Octoparse einrichtet).

Proxy-seller ist ein Proxy-Anbieter, der für alle Scraping-Software im Netz geeignet ist. Er bietet nicht nur private IPv4- und IPv6-Proxys für Rechenzentren, sondern auch rotierende mobile 4G/LTE-Proxys, die sich hervorragend für Scraping eignen und das Risiko, blockiert zu werden, erheblich verringern. Neben den Octoparse-Pools verfügt proxyseller über einen der größten Pools von DC-Proxys, der über 250 Tausend IPs umfasst. Basierend auf dem Standort, gibt es eine Option, um einen bestimmten Staat oder eine Stadt zu wählen. Es wird kein Problem sein, Proxyseller Proxyseller in Octoparse zu konfigurieren, da der Kundendienst rund um die Uhr arbeitet und die Möglichkeit bietet, alles über einen Remote Desktop zu konfigurieren.

Mit Octoparse stehen Ihnen über 100 benutzerfreundliche Vorlagen zur Verfügung, um Daten schnell und einfach zu extrahieren. Darüber hinaus ermöglicht Ihnen die Octoparse-Vorlage die gezielte Extraktion der gewünschten Daten auf einfache Weise. Die Benutzerfreundlichkeit der Octoparse-Vorlage ist besonders hervorzuheben!

https://www.octoparse.de/template/contact-details-scraper

Mozenda

Mozenda ist ebenfalls ein einfach zu bedienender Desktop-Daten-Scraper. Es bietet Geolocation-Proxys und benutzerdefinierte Proxys zur Auswahl an. Mit Geolokalisierungs-Proxys können Sie den Datenverkehr Ihres Crawlers durch einen anderen Teil der Welt leiten, so dass Sie auf regionsspezifische Informationen zugreifen können. Wenn die Standard-Geolokalisierung die Anforderungen Ihres Projekts nicht erfüllt, können Sie über benutzerdefinierte Proxys eine Verbindung zu Proxys von einem Drittanbieter herstellen.

Parsehub

Parsehub ist ein einfach zu erlernendes, visuelles Tool zum Sammeln von Daten aus dem Web, das auch Cloud Scraping und IP-Rotation ermöglicht. Nachdem Sie die IP-Rotation für Ihre Projekte aktiviert haben, kommen die Proxys, die für Ihr Projekt verwendet werden, aus vielen verschiedenen Ländern. Darüber hinaus haben Sie die Möglichkeit, ParseHub im Rahmen der IP-Rotation eine eigene Liste mit benutzerdefinierten Proxys hinzuzufügen, wenn Sie auf eine Website aus einem bestimmten Land zugreifen möchten oder wenn Sie lieber Ihre eigenen Proxys anstelle der für die IP-Rotation bereitgestellten verwenden möchten.

Apify

Apify ist eine Web-Scraping- und Automatisierungsplattform zum Sammeln von Daten. Es bietet nicht nur einen Datenerfassungsdienst, sondern auch einen Proxy-Dienst, der die Blockierung Ihres Web-Scrapings reduziert. Apify Proxy bietet Zugang zu privaten und Rechenzentrums-IP-Adressen. Rechenzentrums-IPs sind schnell und billig, können aber von den Ziel-Websites blockiert werden. Wohn-IPs sind teurer und schwerer zu blockieren.

Jetzt sollten Sie wissen, was ein Proxyserver ist und wie er für Web Scraping eingesetzt werden kann. Auch wenn Proxys das Web-Scraping effizienter machen, ist es wichtig, die Scraping-Geschwindigkeit unter Kontrolle zu halten und eine Überlastung der Ziel-Websites zu vermeiden. Wenn Sie in Frieden mit den Websites leben und das Gleichgewicht nicht stören, können Sie die Daten kontinuierlich erhalten.

Einrichtung von IP Proxy in Octoparse

Sie folgen jetzt einem Tutorial für die neueste Version von Octoparse. Wenn Sie zur Zeit eine ältere Version verwenden, empfehlen wir Ihnen kräftig es, ein Upgrade zu machen, weil sie schneller, leichter und stärker ist! Herunterladen und Installierung eines Upgrades hier, wenn Sie nicht so bereits machen!

Wenn Sie auf eines der folgenden Probleme gestoßen sind, sollten Sie versuchen, IP-Proxys manuell in Octoparse einzurichten:

– Es ist nicht möglich, sich bei Octotoparse anzumelden, weil Ihr Unternehmen oder Ihre Institution ein Intranet verwendet und externe Anfragen einschränkt

– Die Ziel-Webseiten reagiert sehr empfindlich auf Web Scraping und setzt Anti-Scraping-Strategien wie IP-Sperren ein, um Scraping zu unterbinden

In diesem Tutorial zeigen wir Ihnen, wie Sie Proxys mit der neuesten Version einrichten, um die oben genannten Probleme zu lösen.

Es gibt zwei Möglichkeiten, um das Ziel zu verwirklichen:

Möglichkeit 1 Verwendung von Proxy, um sich bei Octoparse anzumelden (nur für Anmeldeprobleme)

Möglichkeit 2 Wechseln externes Proxyservers, um der IP-Blockierung entgegenzuwirken

Möglichkeit 1 Verwendung von Proxy, um sich bei Octoparse anzumelden (nur für Anmeldeprobleme)

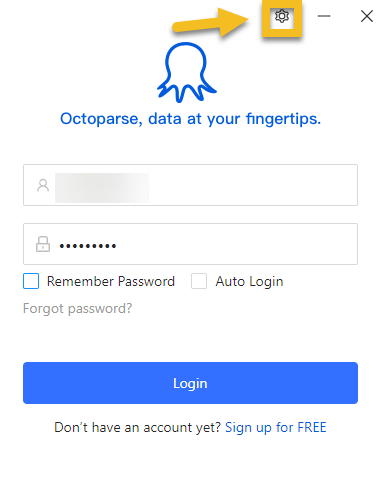

Schritt 1: Klicken Sie auf den Einstellung-Button in der Anmeldungsplatte.

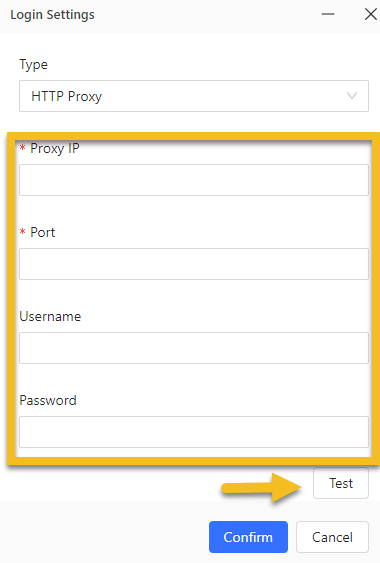

Schritt 2: Geben Sie bei Bedarf Proxy-Informationen ein.

Schritt 3: Sie können überprüfen, um anzuschauen, ob die Verbindung gut ist. Dann drücken Sie „Confirm“ zur Speicherung der Einstellungen.

Möglichkeit 2 Wechseln externes Proxyservers, um der IP-Blockierung entgegenzuwirken

Octoparse Cloud-IPs sind Rechenzentrums-IPs, die blockiert werden können. Wenn eine Website Ihre IP oder unsere Cloud blockiert, können Sie in den Aufgabeneinstellungen einen IP-Proxy einrichten. Sie können Ihre eigenen IP-Proxys oder die in Octoparse integrierten Proxys verwenden.

– Einrichtung der in Octoparse intergrierten Proxys

Octoparse-Proxys sind Wohn-IPs, so dass sie besser funktionieren können, um nicht blockiert zu werden.

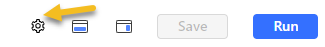

Schritt 1: Öffnen Sie die Aufgabe, für die Sie Proxys einrichten möchten.

Schritt 2: Klicken Sie auf den Einstellung-Button oben links.

Schritt 3: Wählen Sie „Access websites via proxies“.

Schritt 4: Klicken Sie auf „Use Octoparse proxies“.

Schritt 5: Wählen Sie „Default“ oder Länder/Regionen, die Sie für die IP-Adresse haben möchten. („Default“ bedeutet es, dass Sie die IPs aus beliebigen Ländern verwenden.)

Schritt 6: Wählen Sie „Rotate time“ für das Rotationsintervall aus.

Schritt 7: Klicken Sie auf „Save“ Button in der oberen linken Ecke der Benutzeroberfläche, um Ihre Einstellungen zu speichern.

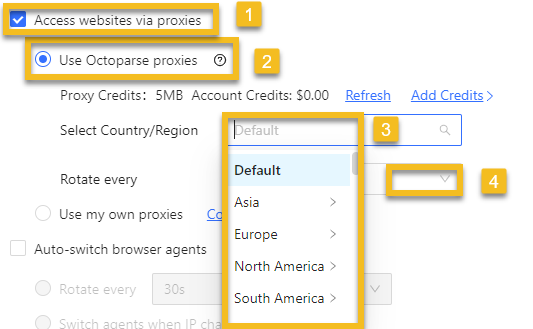

– Verwendung Ihrer eigenen IP-Proxys

Eine andere Möglichkeit, IP-Proxys einzurichten, ist der Zugriff auf Ihre eigene IP in Octoparse. Aber eigene IP-Proxys können nur in lokalen Läufen verwendet werden.

Schritt 1: Klicken Sie auf „Use my own Proxies“.

Schritt 2: Klicken Sie auf „Configure“.

Schritt 3: Geben Sie IP-Proxys in den Kasten ein.

Schritt 4: Speichern Sie bei dem Klick auf „Confirm“ die Einstellungen.

Tipps!

Beachten Sie, dass Octoparse nur HTTP-Proxys unterstützen – Bitte trennen Sie durch einen Doppelpunkt die IP-Adresse des Proxyservers und die Portnummer. Z.B. 58.22.214.29:2318.

Zusammenfassung

Ein Proxy-Server (Proxy) ist ein Computerserver oder eine Anwendung, die als Vermittler zwischen einem Client und dem Internet fungiert. Er kann verwendet werden, um die Sicherheit zu erhöhen, die Privatsphäre zu schützen, die Leistung zu verbessern und den Zugang zu kontrollieren. Im Bereich der Web-Crawler helfen Proxys, IP-Sperren zu vermeiden, die Anonymität zu wahren und geografische Beschränkungen zu umgehen. Beliebte Web-Crawling-Tools wie Octoparse, Mozenda, Parsehub und Apify bieten integrierte Proxy-Funktionen, um die Effizienz des Daten-Crawlings zu verbessern. Bei der Verwendung von Proxys sollten Sie auf deren Geschwindigkeit und Zuverlässigkeit achten und sich an die Nutzungsbedingungen der Website halten.

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Autor*in: Das Octoparse Team ❤️

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.