Es gibt im Internet so viele Data Scraping Tools. Wenn Sie noch nicht wissen, welches Tool Sie wählen sollten, würden Sie in diesem Artikel eine Antwort finden.

Grundwissen über Data Scraping

Kennen Sie Data Scraping und seine Tools wirklich?

Haben Sie Schwierigkeiten und Verluste bei der Auswahl eines Data Scraping Tools? Data Scraping ist jetzt kein neues Wort mehr; wenn Sie nicht wissen, was sie bedeuten, lassen Sie mich für Sie kurz vorstellen. Data Scraping, Web Scraping oder Datenextraktion bedeuten die Verwendung von Bots, um Daten oder Inhalte von einer Website in ein verwendbares Format zur weiteren Verwendung zu extrahieren. Ein Data Scraping Tool ist wichtig, weil es Menschen hilft, eine große Menge Informationen rechtzeitig zu erhalten.

In der Welt konkurrieren Unternehmen miteinander mit massiven Informationen, die von einer Menge Nutzern gesammelt werden – ob es um ihr Konsumverhalten, was sie in sozialen Medien teilen, oder die Aufmerksamkeit von Prominenten geht. Bevor ihre Entscheidungen sollten Menschen zuerst Informationen sammeln, z.B. sie sich die Bewertungen anschauen, um zu entscheiden, ob sie diese Dinge kaufen. Deshalb sollen Sie zumindest über einige Web Scraping Kenntnisse für die weitere Verwendung oder den Erfolg verfügen.

Obwohl wir im Zeitalter von Big Data leben, sind viele Unternehmen und Branchen im Datenbereich immer noch anfällig. Einer der Hauptgründe liegt in dem minimalen Verständnis der Datentechnologie oder deren Mangel. Deshalb ist es notwendig, das Beste aus den Data Scraping Tools zu machen. Heute sind Data Scraping Tools oder Web Scraping Software ein wesentlicher Schlüssel zum Aufbau einer datengetriebenen Geschäftsstrategie. Wenn Sie die Programmiersprache kennen, können Sie Python, Selenium und PHP verwenden, um die Websites zu scrapen. Als Bonus ist es großartig, wenn Sie sich Programmieren meistern. Wenn Sie jedoch überhaupt keine Programmiersprache kennen, seien Sie bitte nicht ängstlich. Lassen Sie mich einige Web Scraping Tools für Sie vorstellen, um müheloses Scraping zu erleichtern.

Heutzutage werden immer mehr Data Scraping Tools auf dem Markt erstellt. Einige Tools wie Octoparse bieten Scraping-Vorlagen und -Dienste, die den Unternehmen viel helfen können, denen es an Data Scraping Fähigkeiten mangelt. Auf der anderen Seite erfordern einige Web Scraping Tools, dass Sie über Programmierkenntnisse verfügen, um fortschrittliches Scraping zu konfigurieren, z.B. Apify. Deshalb hängt es wirklich davon ab, was Sie scrapen möchten und welche Ergebnisse Sie erzielen möchten. Wenn Sie keine Ahnung haben, wie Sie mit Data Scraping Tools beginnen, folgen Sie mir und beginnen Sie von Anfang an mit grundlegenden Schritten.

3 grundlegende Schritte zum Scraping mit Data-Scraping-Tools online

Zuerst verbringen Sie einige Zeit damit, Ziel-Website in Betracht zu ziehen. Es bedeutet nicht, dass Sie die Website analysieren müssen. Sie surfen einfach gründlich die Website. Zumindest sollen Sie wissen, wie viele Seiten und welche Daten auf den Websites Sie scrapen möchten. Machen Sie einige Notizen, weil das gut für das spätere Scraping sein würde.

Zweitens, achten Sie auf die Website-Struktur, die im Wesentlichen die HTML-Struktur bedeutet. HTML besteht aus einer Reihe von Elementen, die dem Browser mitteilen, wie der Inhalt angezeigt werden soll. Einige Websites sind nicht in einer Standardform geschrieben. Wenn die HTML-Struktur chaotisch ist und Sie den Inhalt immer noch scrapen müssen, müssen Sie ihren XPath ändern.

Wenn Sie nicht wissen, was XPath ist, lesen Sie was ist XPath und wie ihn zu verwenden.

Drittens, finden Sie ein geeignetes Tool. Nachdem Sie Ihre Ziel-Webseiten und ihre HTML-Struktur kennengelernt haben, sollen Sie einige Ideen für sie und Datenanforderungen haben. Dann können Sie einige Datenextraktionssoftware auf dem Markt durchgehen. Recherchieren Sie, egal ob Sie online suchen, Freunde fragen oder andere Methoden ausprobieren. Schließlich überlegen Sie sich umfassend und treffen Sie eine Entscheidung basierend auf Ihrer eigenen Situation.

Wenn Sie Datenextraktionstools nicht kennen und nicht wissen, wo Sie anfangen sollen, würden einige folgende persönliche Erfahrungen und Gedanken in Bezug auf Scraping Tools Ihnen helfen.

7 beste Data Scraping Tools

1. Octoparse

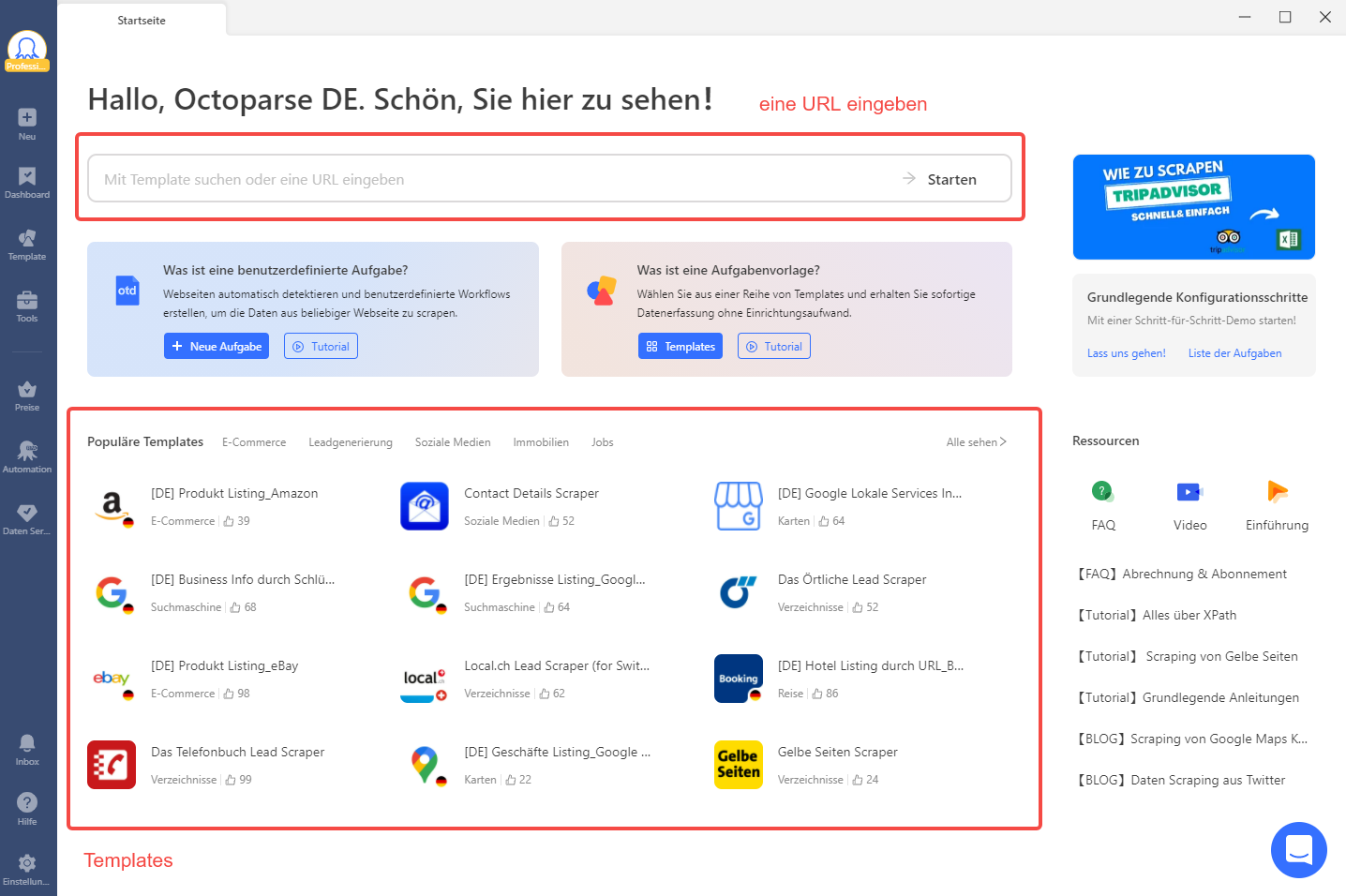

Octoparse ist ein kostenloser und leistungsstarker Web Scraper mit umfassenden Funktionen, die sowohl für Mac-Benutzer*innen als auch für Windows-Benutzer*innen verfügbar ist. Es simuliert den menschlichen Scrapenprozess, deshalb ist der gesamte Scrapenprozess super einfach und flüssig. Es macht nichts, wenn Sie keine Ahnung von der Programmierung haben, weil es die automatische Erkennungsfunktion hat, die Ihnen beim automatischen Web Scraping helfen könnte.

Darüber hinaus verfügt Octoparse über eingebaute Vorlagen von Web Scraping, darunter Amazon, 11880, LinkedIn, Google Maps und viele beliebte Webseite-Vorlagen für Anfänger. Zum Beispiel, wenn Sie die Daten von LinkedIn scrapen möchten, können Sie es einfach als ein LinkedIn Data Scraping Tool bezeichnet. Egal ob, dass Sie manuell eine Aufgabe erstellen oder unsere vorgestellte Vorlagen verwenden. Es ist wirklich freundlich und gut für die Anfänger, die keine Ahnung haben, wie einen Crawler erstellt wird, um die gewünschten Daten zu scrapen. Alles, was sie tun müssen, ist, eine anpassende vorgestellte Vorlage auszuwählen und einige Informationen einzugeben. Dann scrapt der Scraper automatisiert die gewünschten Daten für Sie.

Vorteile: Octoparse hat einzigartige eingebaute Aufgabentemplates, die für neue Benutzer freundlich sind, um mit dem Scraping zu beginnen. Darüber hinaus bietet es kostenlose unlimitierte Crawl, Regex-Tools und Xpath, um 80% der fehlenden Datenprobleme zu lösen, selbst beim Scraping dynamischer Seiten. Es kann auch Scraping planen und Daten in der Cloud ausführen, das Scraping abschließen und sogar Ihren Computer herunterfahren.

Nachteile: Leider hat Octoparse noch keine PDF-Datenextraktionsfunktion und downloadet keine Bilder direkt (kann nur Bild-URLs extrahieren)

Schauen Sie das Video an, um mehr über Octoparse zu erfahren.

Hier bekommen Sie Octoparse! 🤩

Preis: $0~$249 pro Monat

Packet & Preise: Octoparse Premium-Preise & Verpackung

Kostenlose Testversion: 14-tägige kostenlose Testversion

Herunterladen: Octoparse für Windows und MacOs

2. Mozenda

Mozenda ist ein Cloud-basierter Web Scraping Service. Es umfasst eine Web Konsole und einen Agent-Builder, mit dem Sie Ihre eigenen Agenten ausführen, Ergebnisse anzeigen und organisieren können. Außerdem können Sie extrahierte Daten in einen Cloud-storage-anbieter wie Dropbox, Amazon S3 oder Microsoft Azure exportieren oder veröffentlichen.

Vorteile: Die Harvesting-Server von Mozenda teilen listenbasierte Aufgaben in viele Threads auf, um die Bearbeitung zu beschleunigen. Es scrapt Websites durch verschiedene geografische Positionen, was für Websites nützlich ist, die regionsspezifische Daten bieten. APT-Access: Kontrollieren Sie Ihre Agenten und Datensammlungen, ohne manuell auf die Web Console zuzugreifen.

Nachteile: Die Gebühren richten sich nach Seiten. Es wird stundenweise abgerechnet, auch für den Testplan. Darüber hinaus braucht Mozenda Windows PC zum Laufen und hat Instabilitätsprobleme beim Umgang mit extra-großen Websites.

3. Diffbot

Diffbot ist ein Data Scraper und einer der Top-Inhalt-Extraktoren auf dem Markt. Es ermöglicht Ihnen, dass Sie Seiten automatisch mit der Analyse-API-Funktion identifizieren und Produkte, Artikel, Diskussionen, Videos oder Bilder extrahieren. Diffbot scrapt nicht nur Texte, sondern auch Entitätsanpassung und Themen-Level Sentiment usw.

Vorteile: Es kann eine strukturierte Suche sein, um nur die passenden Ergebnisse zu sehen. Visuelle Verarbeitung kann die meisten nicht-englischen Webseiten scrapen. Es bietet JSON- oder CSV-Format. Es gilt für Artikel, Produkt, Diskussion, Video, Bildextraktion APIs und Custom Crawling Controls.

Nachteile: Es ist ein bisschen teuer. Preispläne beginnen bei $299 pro Monat, was ziemlich teuer und ein Nachteil für das Tool ist.

4. Import.io

Import.io ist eine Web Scraping Plattform, die die meisten Betriebssysteme unterstützt. Es gibt ein benutzerfreundliches Interface, das einfach zu beherrschen wird, ohne Code zu schreiben. Sie können auf alle Daten klicken und diese extrahieren, die auf der Website angezeigt werden. Die Daten werden tagelang auf dem Cloud-Service gespeichert. Es ist besonders eine gute Wahl für Unternehmen-Benutzer.

Vorteile: Import.io ist benutzerfreundlich und unterstützt fast alle Systeme. Es ist ziemlich einfach zu verwenden mit seinem schönen, sauberen Benutzerinterface, einfachem Dashboard und Screenshot.

Nachteile: Der kostenlose Plan ist nicht mehr verfügbar. Sie können Preise anfordern mit der Beratung. Es können billig oder teuer sein. Sie werden es nach der Projektevaluierung wissen.

5. Parsehub

Parsehub ist eine Desktop-APP. Im Gegensatz zu anderen Web Crawling Apps unterstützt Parsehub die meisten Betriebssysteme wie Windows, Mac OS X und LINUX. Außerdem hat es eine Browser Extension, mit der Sie sofort scrapen können. Sie können pop-ups, Landkarten, Kommentare und Bilder scrapen. Die Tutorials sind gut dokumentiert, was definitiv ein großer Vorteil für neue Benutzer sind.

Vorteile: Parsehub ist benutzerfreundlicher für Programmierer mit API-Access. Im Vergleich zu Octoparse unterstützt es mehr Systeme. Und es ist auch flexibel, Daten online mit unterschiedlichen Anforderungen zu scrapen.

Nachteile: Der kostenlose Plan ist jedoch in Bezug auf gescrapte Seiten oder Projekte beschränkt. Die bezahlten Pläne reichen von $189 bis $599 pro Monat. Starkes Scraping können den Scrapenprozess verlangsamen. Deshalb gelten kleine Projekte gut für Parsehub.

6. Apify

Apify ist eine interessante Web Scraping Plattform für Programmierer. Wenn Sie grundlegende Programmierkenntnisse haben, möchten Sie es vielleicht versuchen. Es hat keine Click-and-Extract-Funktion. Im Gegenteil müssen Sie JavaScript schreiben, um dem Crawler mitzuteilen, was Sie extrahieren möchten.

Vorteile: Es ist ein Vorteil, dass Sie mit Websites mit unregelmäßigen Strukturen umgehen können. Es hat JQuery-Integration, die ein Open-Source-JavaScript-Library ist. Die kostenlose Version ermöglicht das Crawlen von bis zu 5000 per Monat.

Nachteile: Der Nachteil ist ziemlich unverkennbar. Für die meisten Menschen, die keine Programmierkenntnisse haben, ist es sehr schwierig zu verwenden. Der Preis für einen Entwickler ist kostenlos. Für alle anderen Benutzer*innen liegt der Preis zwischen $49 und $499 pro Monat. Und es hat eine kurze Zeit der Datenretention. Erstellen Sie bitte sicher, dass Sie extrahierte Daten rechtzeitig speichern.

7. Zyte

Zyte ist ein Cloud-basierte Webplattform. Es hat verschiedene Arten von Tools – Scrapy Cloud, Smart Browser, API, Automatic Extraction und Splash. Es ist großartig, dass Zyte eine Sammlung von IP-Adressen für mehr als 50 Länder bietet, die eine Lösung für IP-Ban Probleme ist.

Vorteile: Zyte bietet verschiedene Web Services für verschiedene Arten von Menschen, einschließlich Open Source Framework Scrapy.

Nachteile: Scrapy ist für Programmierer verfügbar. Das bedeutet, dass es für Anfänger nicht einfach zu verwenden ist.

Ich hoffe, dass Sie jetzt ein klareres Verständnis für Data Scraping Tools und Vor- und Nachteile von den sieben besten Web Data Scraping Tools haben. Damit können Sie die bedeutende Entscheidung treffen, ein geeignetes Tool für Ihr Data Scraping Projekt auszuwählen. Ich wünsche, dass Sie eine ausgezeichnete Scraping-Reise starten können!

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Autor*in: Das Octoparse Team ❤️

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.