Auf dem heutigen hart umkämpften Arbeitsmarkt kann der Zugriff auf die richtigen Informationen den entscheidenden Unterschied ausmachen, wenn Sie Ihren Traumjob ergattern möchten. Web Scraping ermöglicht es Arbeitssuchenden, wertvolle Daten von verschiedenen Jobbörsen und Karriere-Websites zu sammeln, was ihnen einen Wettbewerbsvorteil verschafft. In diesem Beitrag untersuchen wir die Bedeutung von Web Scraping für Arbeitssuchende und zeigen Ihnen, wie Sie ohne Codierung Daten von monster.de scrapen können.

Was ist Monster

Monster.de ist eine der weltweit führenden Jobsuchmaschinen und verbindet Arbeitssuchende mit Arbeitgebern aus einer Vielzahl von Branchen. Die Seite enthält Millionen von Stellenanzeigen und ist damit eine wahre Goldgrube an wichtigen Informationen für Personen, die sich einen besseren Überblick über den Arbeitsmarkt verschaffen möchten. Das manuelle Abrufen von Daten von monster.com kann jedoch eine zeitaufwändige und mühsame Aufgabe sein. Hier kommt Web Scraping zur Hilfe, denn es ermöglicht Ihnen, den Prozess zu automatisieren und Daten effizient zu extrahieren.

Warum Monster.de scrapen?

Aufgrund der großen Datenbank von Monster.de mit vielfältigen und hochwertigen Stellenangeboten und den ständigen dynamischen Änderungen ist die Site ideal für die Suche nach aktuellen Daten und Erkenntnissen zum Arbeitsmarkt.

Große Datenbank mit Möglichkeiten

Als eines der größten Online-Stellenportale hat Monster.deZugriff auf Millionen von aktiven Stellenangeboten von Arbeitgebern aus aller Welt. Scraping ermöglicht die Sammlung dieses breiten Angebots an einem Ort.

Umfangreiches Datenfeld

Einzelne Stellenausschreibungen auf monster.de bieten detaillierte Informationen wie Firmenname, Standort, Anforderungen, Vorteile usw. Dies ergibt einen umfangreichen Datensatz, der sich perfekt für benutzerdefinierte Suchen und statistische Analysen eignet.

Beliebte Seite

Dank jahrzehntelanger Erfahrung und Millionen von Besuchern jeden Monat erhalten Stellenausschreibungen auf monster.de eine hohe Anziehungskraft auf Bewerber mit hoher Qualität. Wenn Sie hier nach Stellen suchen, gelangen Sie zu einigen der gefragtesten Angebote.

Dynamische Daten

Jobs werden ständig in Echtzeit hinzugefügt, entfernt oder aktualisiert. Scraping bietet eine automatisierte Möglichkeit, über alle Änderungen auf dem Markt auf dem Laufenden zu bleiben.

Breite Kategorien

Die Einträge auf Monster.de decken ein breites Spektrum an Fähigkeiten, Rollen, Branchen und Erfahrungsstufen ab. Durch Scraping erhalten Sie an einem Ort Zugriff auf ein ebenso breites Spektrum an Karrieremöglichkeiten.

Ist das Scraping von Monster legal?

Obwohl das Scraping öffentlicher Seiten im Allgemeinen legal ist, verbieten die Richtlinien von Monster es. Scraper wären erforderlich, um negative Auswirkungen oder eine unbefugte Weiterverteilung von Daten zu vermeiden und so das potenzielle rechtliche Risiko zu verringern. Beim Scraping von monster.de sind einige rechtliche Faktoren zu berücksichtigen:

- Nutzungsbedingungen: Die Bedingungen von Monster verbieten ausdrücklich das Crawlen, Scrapen oder den sonstigen programmgesteuerten Zugriff auf ihre Website ohne Genehmigung. Ein Verstoß gegen die Nutzungsbedingungen kann zu einer Unterlassungsverfügung führen.

- Robots.txt-Datei: Monster verfügt über eine Robots.txt-Datei, die Scraping-Bots den Zugriff auf bestimmte Seiten verwehrt. Die Einhaltung dieser Datei zeigt, dass Sie gute Absichten haben und nicht einen böswilligen Akteur.

- Zweck des Scrapings: Es ist wichtig, dass die Daten nur für zulässige Zwecke gescrapt werden, beispielsweise für Recherchen, Preisvergleiche oder die Analyse von Lebensläufen – und nicht für die erneute Veröffentlichung zu Wettbewerbszwecken oder für Marketingzwecke.

- Häufigkeit und Volumen : Das aggressive und kontinuierliche Scraping großer Datenmengen könnte die Server von Monster überlasten und als Dienstverweigerung angesehen werden. Das gelegentliche Scraping kleinerer Datensätze ist rechtlich weniger riskant.

- Datennutzung und -speicherung: Die Scraped-Daten dürfen nur vom Scraper privat genutzt und nicht ohne Zustimmung kommerziell verbreitet werden. Sie müssen außerdem sicher gespeichert und nach angemessener Verwendung für Forschungszwecke gelöscht werden.

Erstellen Sie mit Octoparse einen Monster Scraper

Web Scraping ist eine Methode, mit der Sie Webdaten effizienter erfassen können. Im Gegensatz zu herkömmlichen Online-Scraping-Methoden, bei denen Benutzer das Skript selbst erstellen müssen, bietet Octoparse eine Web Scraping-Lösung ohne Code für jedermann. Mit Octoparse können Sie Daten von monster.de in großen Mengen extrahieren, ohne eine einzige Zeile Code schreiben zu müssen. Es kann auch als Ihr KI-Web Scraping-Helfer dienen und zeitnahe Ratschläge zum Erstellen eines Lead Scrapers geben.

Laden Sie zunächst Octoparse herunter und installieren Sie es auf Ihrem Gerät. Erstellen Sie dann ein neues Konto oder melden Sie sich mit Ihrem Google- oder Microsoft-Konto an, um das erweiterte Scraping-Tool zu verwenden und mit nur vier Klicks einen Lead Scraper zu erstellen!

Schritt 1: Erstellen Sie eine neue Aufgabe zum Scrapen von Monster.de

Kopieren Sie die URL der Seite, von der Sie Daten sammeln möchten, und fügen Sie sie in die Suchleiste von Octoparse ein. Klicken Sie anschließend auf „Start“, um einen neuen Scraping-Auftrag zu starten. Die Website wird dann in den integrierten Browser von Octoparse geladen. Warten Sie, bis die Seite vollständig geladen ist, bevor Sie fortfahren.

Schritt 2: Monster.de – Daten automatisch erkennen

Sobald die Seite geladen ist, gehen Sie zum Bereich „Tipps“ und klicken Sie auf „Webseitendaten automatisch erkennen“. Dieses leistungsstarke, KI-gestützte Tool scannt die gesamte Seite und „errät“ die gesuchten Daten und hebt alle gefundenen Informationen für Sie hervor. Sie können eine Vorschau dieser Daten im Browser anzeigen, um zu sehen, ob Octoparse eine genaue Vorhersage macht.

Schritt 3: Workflow erstellen und ändern

Nachdem Sie alle gewünschten Daten ausgewählt haben, klicken Sie auf „Workflow erstellen“. Daraufhin wird auf Ihrer rechten Seite ein automatisch generierter Workflow angezeigt. Sie können jede Aktion Ihres Lead Scrapers in diesem Flussdiagramm sehen. Durch Klicken auf jede Operation können Sie überprüfen, ob der Scraper wie vorgesehen funktioniert. Im Diagramm können Sie neue Aktionen hinzufügen und nicht benötigte löschen.

Schritt 4: Ausführen der Aufgabe und Exportieren der extrahierten Daten

Nachdem Sie alle Details überprüft haben, klicken Sie auf die Schaltfläche „Ausführen“, um die Aufgabe auszuführen. Entscheiden Sie als Nächstes, ob Sie die Cloud-Server von Octoparse oder Ihr Gerät zum Ausführen der Aufgabe verwenden möchten. Größere Projekte eignen sich hingegen besser für die Cloud-Server von Octoparse, die rund um die Uhr in Betrieb sein können, damit Sie die aktuellsten Daten erfassen können.

Wenn der Scraping-Vorgang abgeschlossen ist, können Sie die Scraping-Daten zur späteren Verwendung in einer lokalen Datei wie Excel oder einer Datenbank wie Google Sheets speichern.

So verwenden Sie Octoparse-Vorlagen

Octoparse wird mit einer Fülle von Vorlagen geliefert, die das Scrapen zum Kinderspiel machen. Hier erklären wir den Scraping-Vorgang mithilfe von Monster-Vorlagen.

https://www.octoparse.de/template/monster-de-job-scraper

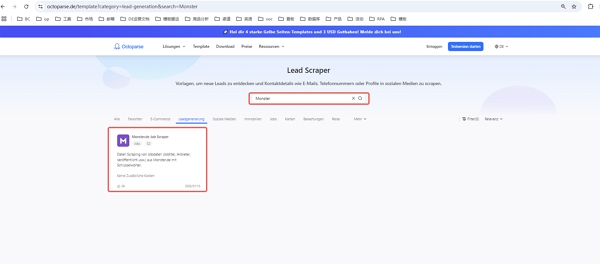

Schritt 1. Wählen Sie eine Vorlage aus.

Sobald Sie sich bei Octoparse angemeldet haben, geben Sie „Monster“ in das Suchfeld ein. Anschließend wird die Monster-Vorlage angezeigt. Bitte wählen Sie die Vorlage mit der Bezeichnung „Monster.de Job Scraper“ aus.

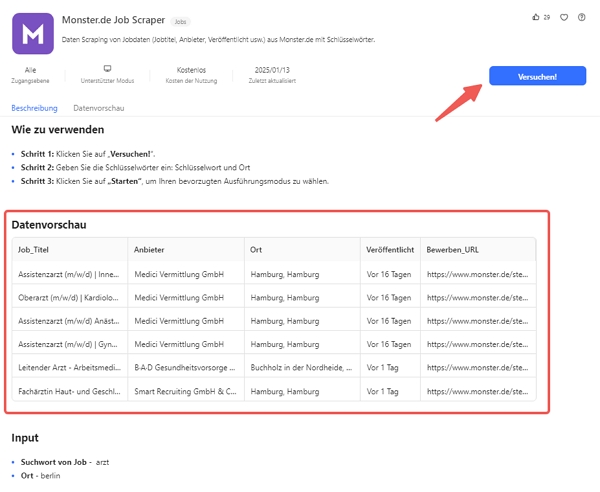

Schritt 2. Datenerfassungsbedingungen festlegen

Geben Sie nach dem Öffnen der Vorlage die URL der Daten ein, die Sie auf der Monster-Site erfassen möchten. Kopieren Sie zuvor die URL der nach bestimmten Bereichen oder Bedingungen eingegrenzten Immobilienliste.

Fügen Sie es anschließend in das Parametereingabefeld von Octoparse ein. Wenn die Eingabe abgeschlossen ist, drücken Sie die Schaltfläche „Ausführen“.

Schritt 3. Scraping ausführen

Sobald die Einstellungen abgeschlossen sind, beginnen Sie mit dem Scraping. Octoparse zeigt die erfassten Daten in Echtzeit auf einem Vorschaubildschirm an, sodass Sie im weiteren Verlauf sehen können, welche Informationen erfasst werden.

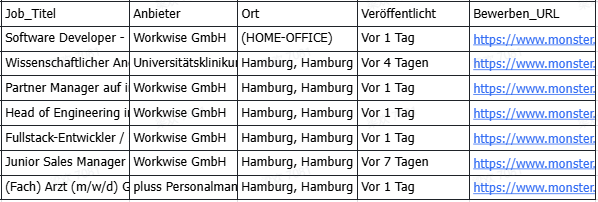

Schritt 4. Gesammelte Daten exportieren.

Einmal gesammelte Daten können im Excel- oder CSV-Format exportiert werden. Nutzen Sie dies, um Daten zu verarbeiten und zu analysieren.

Schritt 5. Nutzen Sie die exportierten Daten

Nach Excel etc. exportierte Mietdaten können durch Organisation und Bearbeitung vielfältig genutzt werden. Beispielsweise ist es möglich, die durchschnittliche Miete in einer Region zu berechnen oder Materialien durch die grafische Darstellung von Daten zu erstellen.

Zusammenfassung

Web Scraping ist eine wichtige Fähigkeit für Arbeitssuchende, da es ihnen Einblicke in den Arbeitsmarkt ermöglicht und ihnen Zugang zu einer Vielzahl von Informationen verschafft, die ihnen einen Wettbewerbsvorteil verschaffen. Durch das Scraping von Daten von monster.de können Sie Zeit sparen, Stellenanzeigen nach Ihren Interessen filtern und verborgene Möglichkeiten entdecken.

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.