Reddit ist ein weit verbreitetes Online-Diskussionsforum, in dem Menschen über fast alle möglichen Dinge und Themen sprechen. Egal, welches Thema Sie interessiert, Sie werden ein entsprechendes Subreddit finden. Das heißt, Reddit ist eine großartige Plattform zum Sammeln sozialer Daten.

Wenn Sie sich also mit Sozialforschung, Internetmarketing oder einem anderen verwandten Gebiet beschäftigen, kann das Scraping von Reddit eine großartige Quelle für Daten zu Forschungszwecken, Analysen, als Referenz und für andere Zwecke sein. In diesem Artikel erfahren Sie mehr über den besten Reddit-Scraper, mit dem Sie Reddit-Daten einfach und schnell extrahieren können.

Reddit und Web Scraping

Erlaubt Reddit Scraping?

Reddit erlaubt die Verwendung öffentlich verfügbarer Daten über die offizielle Reddit-API. Dies ermöglicht den Entwicklern eine Reihe nützlicher Möglichkeiten, mit der Site zu interagieren, allerdings mit einigen Einschränkungen und Beschränkungen.

Um die Reddit-API zu verwenden, müssen Sie authentifiziert sein. Für die kommerzielle Nutzung der API ist eine spezielle Autorisierung erforderlich. Darüber hinaus müssen sich Entwickler registrieren und das Token erhalten, um die offizielle API verwenden zu können, und zwar gemäß den von der Site festgelegten Regeln.

Sie können sogar Web Scraping Tools zum Extrahieren von Daten von Reddit und anderen Websites ohne Bedenken verwenden, da deren Verwendung nicht illegal ist. Stellen Sie einfach sicher, dass Sie die von der Site festgelegten Richtlinien und Regeln einhalten.

Welche Daten können Sie von Reddit scrapen?

Es gibt verschiedene Arten von Daten, die von Reddit gescrapt werden können. Hier sind einige spezifische Beispiele für Daten, die von Reddit gescrapt werden können:

- Beitragstitel und -inhalte

- Kommentare und Antworten

- Anzahl der Upvotes und Downvotes

- Erstellungszeitpunkt von Beiträgen und Kommentaren

- Bilder, Videos und andere Mediendateien

- Subreddit und Themen

- Benutzernamen, Profile, Karma-Werte usw.

Vorteile des Scrapings von Reddit-Daten

Sie fragen sich vielleicht, warum wir Reddit-Daten scrapen und in eine Excel-Datei exportieren müssen. Hier sind einige Gründe oder, besser gesagt, die Vorteile aufgeführt, warum wir Daten von Reddit scrapen sollten.

Für Marktforschung:

Das Scraping von Daten von Reddit kann wertvolle Einblicke in Kundenbedürfnisse und -präferenzen liefern und bei der Marktforschung helfen. Außerdem können Sie durch das Scraping der Informationen Ihrer Konkurrenten eine Wettbewerbsanalyse durchführen.

Zur Inhaltserstellung:

Reddit ist eine reiche Quelle für Ideen und Inspirationen zur Inhaltserstellung. Durch das Scraping der relevanten Daten können Sie beliebte Themen, Trends und Diskussionen identifizieren, die zur Erstellung ansprechender und relevanter Inhalte verwendet werden können.

Für die Stimmungsanalyse:

Reddit ist eine Plattform, auf der Menschen ihre Meinungen und Gefühle zu verschiedenen Themen äußern. Indem Sie Daten aus relevanten Subreddits extrahieren, können Sie eine Stimmungsanalyse durchführen, um zu verstehen, wie Menschen über Ihre Marke, Produkte oder Dienstleistungen denken.

Bester Web Scraper für Reddit ohne Codierung

Wie im obigen Teil des Themas erläutert, ist die Verwendung der offiziellen API von Reddit zum Datenscraping mit vielen Einschränkungen verbunden und auch die Art der Daten, die extrahiert werden können, ist begrenzt. Hier stellen wir ein benutzerfreundliches Web-Scraper-Tool vor, mit dem Sie mühelos Reddit-Daten scrapen können, ohne Code schreiben zu müssen.

Octoparse ist ein Tool, das sowohl auf Windows- als auch auf Mac-Systemen basiert und automatisch Daten von Websites wie Reddit extrahiert. Der Vorgang des Datenscrapings ist einfach und Sie können schnell die Daten einschließlich Gruppenname, Titel, Artikel, Autor usw. abrufen. Es unterstützt auch die Cloud-Extraktion, sodass Sie IP-Blockierungen vermeiden können. Es gibt auch eine Option für die geplante Extraktion, bei der eine bestimmte Zeit für das Datenscraping festgelegt werden kann. Die endgültigen gescrapten Reddit-Daten können als Excel-Datei heruntergeladen oder in Ihre Datenbank exportiert werden.

Schritte zum Scrapen von Reddit-Daten mit Octoparse

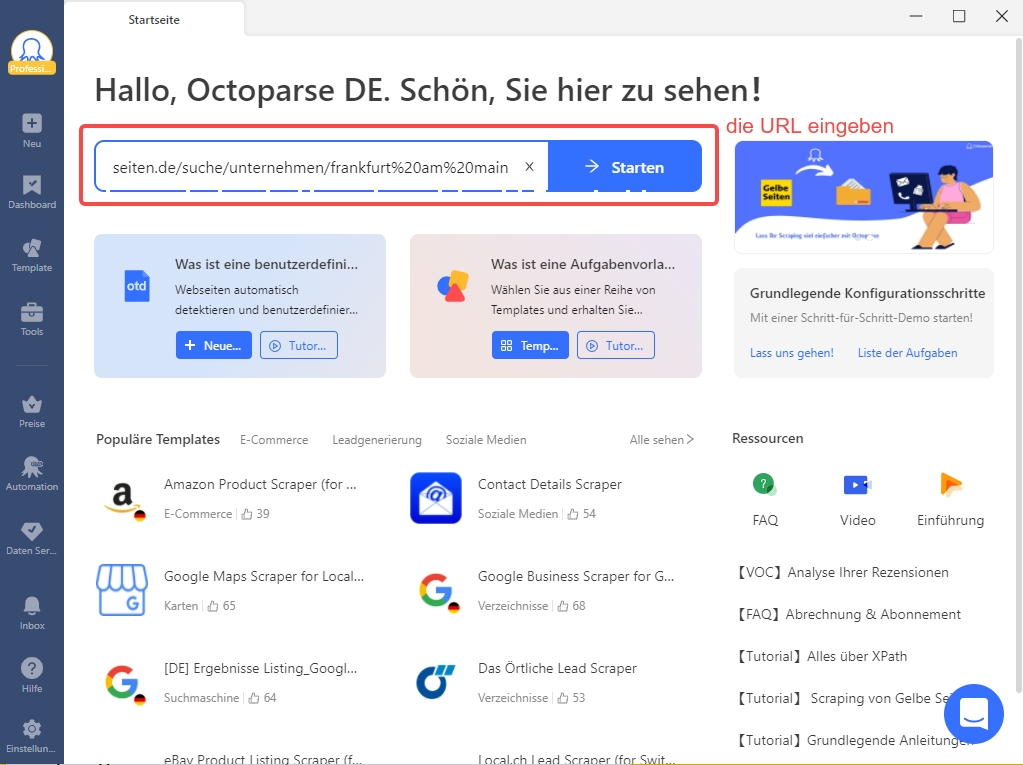

Schritt 1: Starten Sie Octoparse und fügen Sie Ihren Reddit-Link ein

Starten Sie zunächst Octoparse, nachdem Sie es heruntergeladen und auf Ihrem Gerät installiert haben. Fügen Sie den kopierten Reddit-Link in die Hauptoberfläche ein und Sie wechseln standardmäßig in den automatischen Erkennungsmodus. Oder Sie können für weitere Optionen in den erweiterten Modus wechseln.

Schritt 2: Workflow erstellen und Datenfeld anpassen

Als nächstes wird nach der schnellen automatischen Erkennung ein Workflow erstellt. Sie können das Scrollen nach unten einstellen, wodurch Sie alle Elemente auf einer Seite laden können. Weitere benutzerdefinierte Optionen können ebenfalls mit mehreren Klicks vorgenommen werden.

Schritt 3: Daten aus Reddit extrahieren

Sobald die vorherigen Schritte abgeschlossen sind, ist es Zeit, die Daten zu extrahieren. Klicken Sie auf die Schaltfläche Ausführen, um den Scraping-Vorgang zu starten. Nach einer Weile können Sie die Daten als Excel- oder CSV-Datei herunterladen.

Vordefinierte Reddit-Daten-Scraping-Vorlage

Octoparse bietet auch voreingestellte Vorlagen zum Scrapen von Daten von Reddit und anderen beliebten Websites. Sie können problemlos Daten wie Postbilder, Titel, Autoren und mehr von Reddit extrahieren. Diese voreingestellten Vorlagen zum Daten-Scraping finden Sie im Vorlagenfenster von Octoparse, oder Sie können den Online-Reddit-Scraper unten ausprobieren.

Reddit-Follower mit Python scrapen

Wenn Sie gut mit dem Programmieren umgehen können, können Sie Daten von Reddit auch extrahieren, indem Sie Ihren Scraper mit Python, der fortgeschrittenen Programmiersprache, entwickeln. Sie können auch Bibliotheken und Frameworks von Drittanbietern nutzen, die Sie bei der Erstellung von Scrapern und Webcrawlern unterstützen.

Um Reddit-Daten mit Python zu scrapen, wird das Modul PRAW (Python Reddit API Wrapper) verwendet, das die Verwendung der API von Reddit mithilfe von Python-Skripten erleichtert.

Schritte zum Scrapen von Reddit mit Python

Schritt 1. Zuerst müssen Sie PRAW installieren. Dazu müssen Sie die Befehlszeile „pip install praw“ in der Eingabeaufforderung ausführen.

Schritt 2. Als nächstes muss zur Datenextraktion eine Reddit-App erstellt werden. Wählen Sie die Option, Entwickler zu sein und eine App zu erstellen.

Schritt 3. Nachdem die App erstellt wurde, müssen Prawn-Instanzen erstellt werden, von denen es zwei Typen gibt: schreibgeschützte Instanzen und autorisierte Instanzen.

Schritt 4. Abhängig von der Art der zu extrahierenden Daten wird der Befehl gegeben. Während der Befehl verarbeitet wird, erfolgt die Datenextraktion.

Weitere Einzelheiten finden Sie auf dieser Seite: https://www.geeksforgeeks.org/scraping-reddit-using-python/

Zusammenfassung

Wir glauben, dass das Scraping von Reddit-Daten Ihnen sicherlich dabei helfen wird, Informationen für Ihr Unternehmen zu sammeln. Stellen Sie jedoch sicher, dass Sie ein effizientes Scraping-Tool verwenden, damit alle benötigten Daten einfach und sicher gescrapt werden können. Darüber hinaus sollte das ausgewählte Scraping-Tool es Ihnen ermöglichen, die extrahierten Daten in mehreren und leicht lesbaren Formaten zu speichern.

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.