Web Scraping hat sich zu einem unverzichtbaren Werkzeug entwickelt, das Unternehmen und Einzelpersonen hilft, wertvolle Informationen effizient aus dem riesigen Datenmeer des Internets zu extrahieren. Besonders im Bereich der Elektronik und Haushaltsgeräte, wie auf der Plattform Expert.de, spielt diese Technologie eine zentrale Rolle, um stets aktuelle Daten zu Produktpreisen, Verfügbarkeiten und Rabatten zu erhalten.

In diesem Artikel erfahren Sie, wie Sie mit Web Scraping gezielt Daten von Expert.de sammeln und wie dies für Ihre Analysen und strategischen Entscheidungen von Nutzen sein kann.

Was ist Web Scraping und wie hilft es beim automatischen Sammeln von Informationen für Expert.de?

Web Scraping ist eine Technologie zum automatischen Sammeln von Informationen von Websites. Es wird in vielen Bereichen eingesetzt, um notwendige Daten effizient aus dem Informationsmeer des Internets zu extrahieren. Hinter dieser Technologie steckt ein Programm namens „Site Crawler“, das nach bestimmten Informationen sucht und diese sammelt.

Das Internet ist ein Informationsschatz, in dem stündlich riesige Datenmengen generiert werden. Web Scraping wird verwendet, um spezifische Datenpunkte wie Titel, Preise, Bilder oder Links zu extrahieren.

Gerade im Bereich der Elektronik und Haushaltsgeräte ist es wichtig, Informationen schnell und genau zu sammeln. Für Technikfans und Experten sind Analysen und Vergleiche auf der Grundlage der neuesten Daten unerlässlich, und Web Scraping wird als leistungsstarkes Tool zur Erfüllung dieser Anforderungen positioniert. Wenn Sie mehr über den detaillierten Mechanismus und Anwendungsbeispiele von Web Scraping erfahren möchten, lesen Sie bitte die entsprechenden Artikel.

Vorteile der automatischen Erfassung von Informationen zu Elektronikprodukten mithilfe von Web Scraping

Viele Benutzer vertrauen Expert.de als Informationsquelle für Elektronik und Haushaltsgeräte, die detaillierte Daten zu Produkten, Preisen und Verfügbarkeiten in Deutschland bietet. Durch das Sammeln dieser Informationen mittels Web Scraping können sie für verschiedene Zwecke genutzt werden.

Spezifische Vorteile:

- Analyse von Preisentwicklungen und Rabatten:

Trends in Preisen und Sonderaktionen lassen sich einfach verfolgen und analysieren. - Überwachung der Produktverfügbarkeit:

Verfolgen Sie die Bestände neuer und gefragter Produkte in Echtzeit. - Marktanalysen:

Beliebte Produkte und Marken können frühzeitig erkannt werden, was bei Marketingstrategien hilft. - Konkurrenzanalyse:

Daten von Expert.de können mit anderen Anbietern verglichen werden, um Wettbewerbsvorteile zu erzielen.

Durch das Sammeln großer Mengen dieser Informationen und deren Analyse als Big Data können sie auf vielfältige Weise genutzt werden. Dazu gehören die Verbesserung von Verkaufsstrategien, die Optimierung von Lagerbeständen und die Bereitstellung besserer Angebote für Kunden.

Das manuelle Sammeln dieser Daten ist jedoch äußerst zeitaufwändig und ineffizient. Da sich Preise, Verfügbarkeiten und Angebote regelmäßig ändern, sind schnelle Aktualisierungen entscheidend. Mit Web Scraping können Informationen von Expert.de automatisch erfasst werden, sodass Unternehmen und Kunden stets auf dem neuesten Stand sind.

Wie man Web-Scraping-Daten von Expert.de durchführt

Expert.de ist eine der führenden Plattformen für Elektronik- und Haushaltsgeräte in Deutschland. Die Website bietet umfassende Informationen zu Produkten, Preisen, technischen Spezifikationen und Verfügbarkeiten.

Web Scraping ist eine effektive Methode, um Daten aus dieser umfangreichen Quelle effizient zu sammeln. Hier stellen wir zwei Ansätze vor, wie Sie Daten von Expert.de scrapen können.

1. Python

Python ist eine der beliebtesten Programmiersprachen für Web Scraping. Es verfügt über zahlreiche Bibliotheken und Frameworks, die den Scraping-Prozess erleichtern, ohne dass Sie alles von Grund auf neu programmieren müssen.

Beliebte Bibliotheken:

- BeautifulSoup: Ideal für das Parsing und die Strukturierung von HTML-Seiten.

- Scrapy: Ein Framework, das für größere und komplexere Scraping-Projekte entwickelt wurde.

- Selenium: Besonders nützlich, wenn es darum geht, dynamisch geladene Inhalte zu extrahieren.

Mit diesen Tools können Sie effizient Daten wie Produktnamen, Preise, Verfügbarkeiten und technische Spezifikationen von Expert.de extrahieren.

Beispielanwendungen:

- Automatisiertes Preis-Monitoring.

- Analyse von Rabattaktionen.

- Überwachung der Lagerbestände.

Weitere Informationen zur Verwendung von Scrapy finden Sie in unserem Artikel:

[Für Anfänger: Einführung in Python Scrapy und seine Anwendungsmöglichkeiten]

2. Scraping-Tools

Auch ohne Programmierkenntnisse können Sie mithilfe cloudbasierter Web-Scraping-Tools effizient Daten von Expert.de extrahieren. Diese Tools analysieren die Struktur einer Website automatisch und erfassen die gewünschten Daten mit wenigen Klicks.

Beispiel-Tool: Octoparse

- Einfache Bedienung: Besuchen Sie die Website Expert.de, geben Sie die Datenelemente an (z. B. Produktnamen, Preise, Kategorien), und das Tool startet automatisch die Datenerfassung.

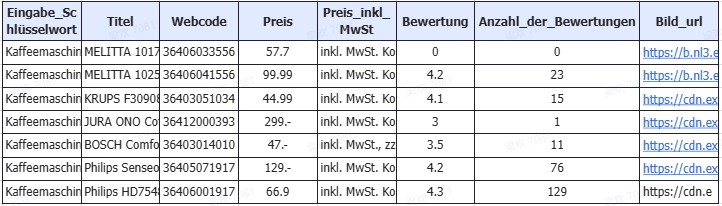

- Datenexport: Die extrahierten Daten können als CSV- oder Excel-Dateien gespeichert werden, um sie weiterzuverarbeiten.

- Effizienz: Besonders geeignet für das Sammeln großer Datenmengen ohne Programmieraufwand.

So scrapen Sie Daten von „Expert.de“ mit Octoparse

Von hier aus erklären wir Ihnen in konkreten Schritten, wie Sie mit dem Web-Scraping-Tool Octoparse Daten von Expert.de sammeln.

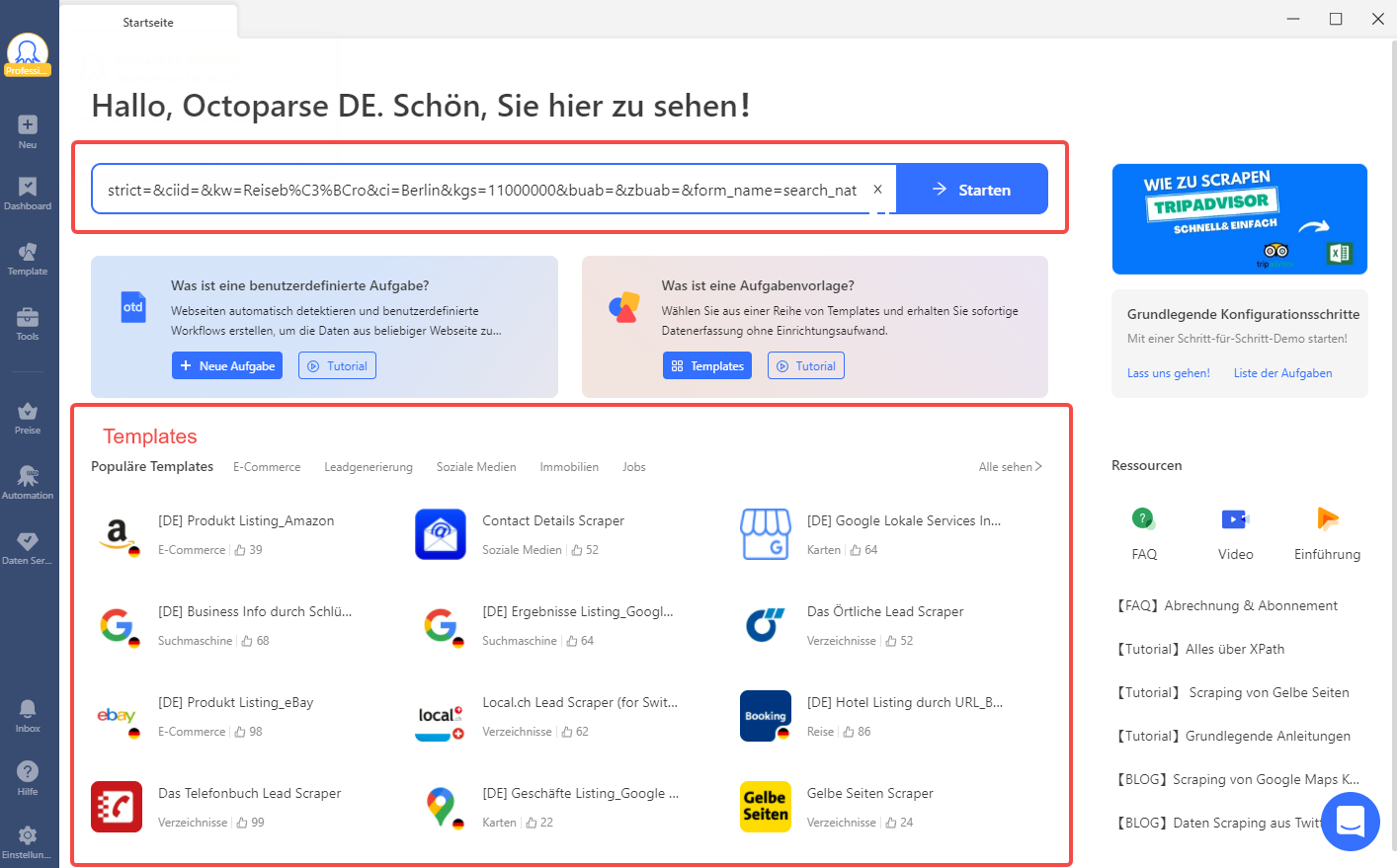

Schritt 1: Die URL eingeben

Sobald die entsprechende Seite geöffnet ist, kopieren Sie die URL.

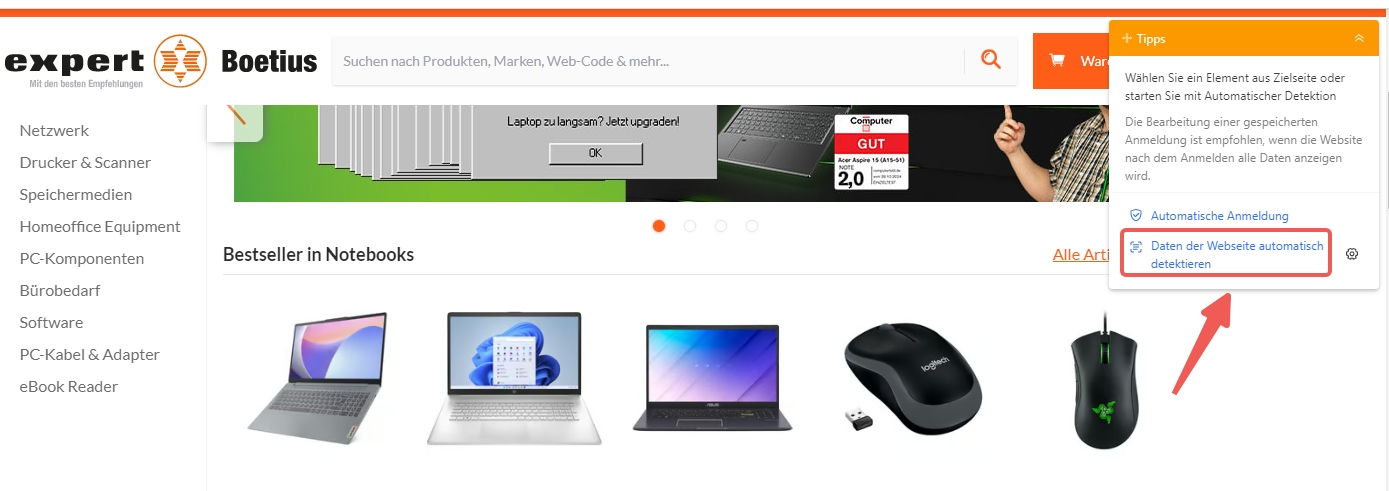

Schritt 2: Automatische Erkennung aktivieren und Workflow erstellen

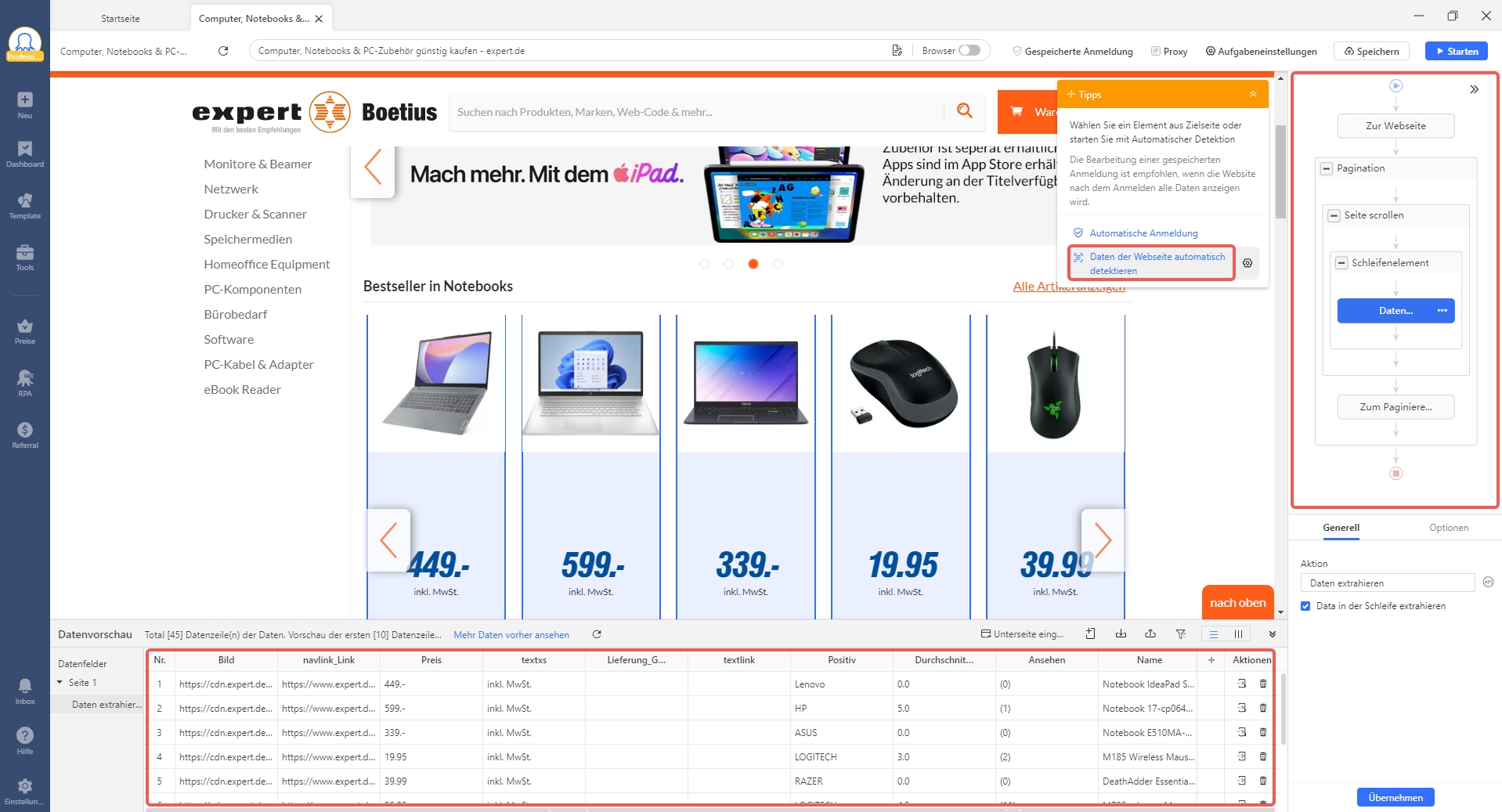

Sobald die Seite geladen ist, erscheint ein Pop-up mit der Option „Automatische Erkennung“.

Klicken Sie auf „Automatische Erkennung starten“, und Octoparse beginnt automatisch, die Struktur der Seite zu analysieren.

Schritt 3. Starten Sie das Scrapen-Aufgabe

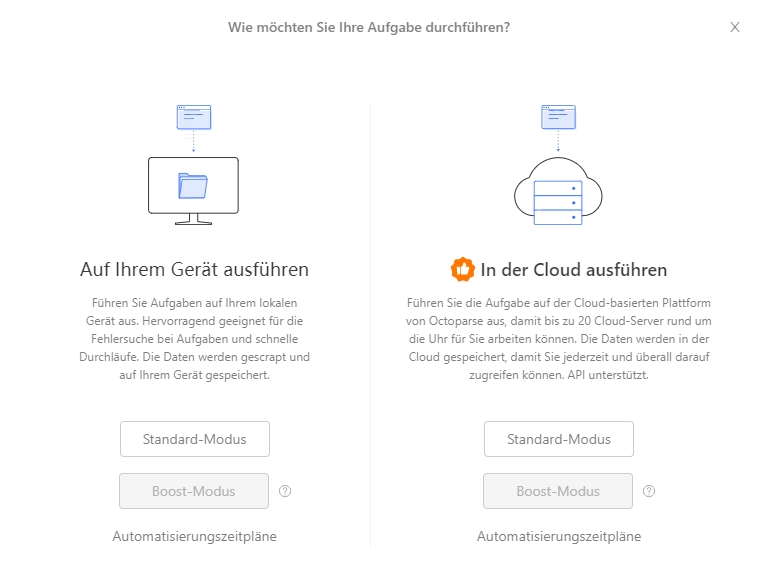

Wenn Sie mit dem Workflow zufrieden sind, klicken Sie auf die Schaltfläche „Ausführen“.

Sie können den Aufgabenausführungsmodus zwischen „Lokale Extraktion“ und „Cloud-Extraktion“ wählen. Wenn Sie sich für die Cloud-Extraktion entscheiden, erhöht sich Ihre Scraping-Geschwindigkeit, Sie benötigen jedoch möglicherweise einen kostenpflichtigen Plan für Octoparse. Selbst wenn Sie sich für eine lokale Absaugung entscheiden, reicht diese dennoch für Ihre Grundbedürfnisse beim Scrapen aus.

Wenn die Aufgabe startet, beginnt sie mit dem Extrahieren von Daten von den angegebenen Seiten. Sie können den Fortschritt auf dem Bildschirm überprüfen. Warten Sie, bis das Scrapen abgeschlossen ist.

Wenn das Scrapen abgeschlossen ist, wird die Meldung „Ausführung abgeschlossen!“ angezeigt. Klicken Sie auf „Daten exportieren“, um die extrahierten Daten zu speichern. Als Exportformat können Sie zwischen Excel, CSV, HTML und JSON wählen.

Durch die Verwendung dieser Methode ist es möglich, die erforderlichen Pferderennendaten effizient von Netkeiba zu sammeln und für Analysen und Vorhersagen zu verwenden.

Schritte zur Nutzung der Expert-Vorlage in Octoparse

1. Octoparse öffnen und Vorlage auswählen:

- Melden Sie sich in Ihrem Octoparse-Konto an.

- Suchen Sie nach der Expert.de-Vorlage im Template Center.

2. URL eingeben:

- Geben Sie die Expert.de URL in Octoparse ein und wählen Sie die Vorlage aus, um automatisch Daten zu extrahieren.

3. Daten filtern und anpassen:

- Überprüfen Sie die automatisch erkannten Datenpunkte und passen Sie sie bei Bedarf an.

- Fügen Sie Filter hinzu, um nur die relevanten Daten zu extrahieren.

3. Daten exportieren:

Starten Sie die Extraktion und exportieren Sie die gesammelten Daten in Ihrem bevorzugten Format.

Die Expert-Vorlage in Octoparse erleichtert den Web-Scraping-Prozess erheblich, indem sie eine schnelle und effiziente Möglichkeit bietet, Daten von Expert.de zu extrahieren. Sie ist besonders nützlich für Nutzer, die regelmäßig Produktdaten sammeln müssen, und spart Zeit und Aufwand, indem viele Schritte automatisiert werden.

Beim Web Scraping zu beachtende Punkte

Insbesondere große Websites wie Expert.de, die umfangreiche Daten zu Produkten und Dienstleistungen bereitstellen, können häufige Scraping-Aktivitäten einschränken.

Eine große Anzahl unbefugter Zugriffe kann den Server der Website belasten und die Servicequalität beeinträchtigen. Wir empfehlen daher, die Website in angemessenen Abständen zu scannen, um die Server nicht unnötig zu belasten und die Website-Nutzung nicht zu stören.

Darüber hinaus muss der Verwendungszweck und die Weitergabe der erhobenen Daten aus urheberrechtlicher und datenschutzrechtlicher Sicht sorgfältig gehandhabt werden. Achten Sie darauf, dass die gesammelten Daten nicht gegen geltende Gesetze oder die Nutzungsbedingungen der Website verstoßen, insbesondere in Bezug auf den Schutz personenbezogener Daten und geistiges Eigentum.

Referenz: 15 häufig gestellte Fragen zum Web Scraping

Zusammenfassung

Zusammenfassend lässt sich sagen, dass Web Scraping eine kraftvolle Methode darstellt, um Daten von Expert.de und anderen großen Plattformen schnell und effizient zu extrahieren. Ob zur Marktanalyse, Preisüberwachung oder Lagerbestandskontrolle – die Anwendungsmöglichkeiten sind vielfältig. Mit Tools wie Octoparse können auch Nutzer ohne Programmierkenntnisse diese Technik nutzen und wertvolle Informationen in kürzester Zeit sammeln. Denken Sie jedoch daran, beim Scrapen stets die rechtlichen und ethischen Richtlinien zu beachten, um mögliche rechtliche Konflikte zu vermeiden und einen fairen Umgang mit den gesammelten Daten zu gewährleisten.

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.