Bei der Förderung von Webmarketing- und SEO-Maßnahmen ist es äußerst wichtig, effizient eine Liste von URLs innerhalb einer Seite zu sammeln. Tools zur Massen-URL-Extraktion sind besonders nützlich, um die URL-Struktur der Websites Ihrer Mitbewerber zu verstehen und interne Links auf Ihrer Website zu verwalten. Viele Menschen sind jedoch verwirrt darüber, welches Tool sie unter den vielen verfügbaren Tools auswählen sollen.

Dieses Mal stellen wir fünf empfohlene URL-Extraktionstools vor, mit denen Sie URLs von Webseiten in großen Mengen abrufen und als Daten verwenden können. Darüber hinaus erklären wir Ihnen ausführlich die Handhabung und welche Punkte es bei der Werkzeugauswahl zu beachten gilt.

Verwendung nach dem Extrahieren der URL von der Webseite

Zusätzlich zum Extrahieren von URLs aus Webseiten variieren die Ergebnisse Ihres Marketings stark, je nachdem, wie Sie diese Daten verwenden. Hier erklären wir Ihnen konkrete Möglichkeiten zur effektiven Nutzung von URLs.

Interne Linkoptimierung

Von Webseiten gewonnene URL-Daten können zur internen Linkoptimierung verwendet werden. Interne Links erhöhen nicht nur den Nutzerverkehr, sondern sind auch wichtige Indikatoren für Suchmaschinen. Als Grundlage für die Erstellung einer effektiven Linkstruktur und die Verbesserung des Suchrankings sollten Sie zunächst alle URLs innerhalb einer Seite verstehen.

Analyse der Konkurrenzseite

Durch das Extrahieren von URLs von konkurrierenden Websites können Sie die Seitenstruktur und Inhaltsstrategie anderer Unternehmen verstehen. Dies sind wertvolle Daten, um die internen Links und Inhaltskategorien Ihrer Konkurrenten zu untersuchen und Verbesserungsmöglichkeiten auf Ihrer eigenen Website zu finden. Wenn viele Links zu einer bestimmten Inhaltsseite vorhanden sind, kann diese Seite außerdem Traffic anziehen.

Inhaltsverwaltung und Updates

Indem Sie regelmäßig eine Liste der URLs auf der Website Ihres Unternehmens abrufen, können Sie Inhalte effizient verwalten und aktualisieren. Dies erleichtert das Auffinden veralteter Seiten und defekter Links, erhöht den Benutzerkomfort und ist auch als SEO-Maßnahme wirksam. Darüber hinaus können URL-Daten beim Erstellen und Aktualisieren von Sitemaps verwendet werden, um die Indexierung durch Suchmaschinen zu fördern.

Prüfung und Überprüfung externer Links

Sie können Ihre SEO-Effektivität verbessern, indem Sie ein URL-Extraktionstool verwenden, um eine Liste externer Links zu erhalten und die Zuverlässigkeit und Relevanz der Linkziele zu überprüfen. Unangemessene externe Links schaden nicht nur dem Vertrauen der Nutzer, sondern beeinträchtigen auch Ihre Reputation bei Suchmaschinen. Regelmäßige Kontrollen sind daher unerlässlich. Sie können Ihren Benutzern auch wertvolle Informationen bereitstellen, indem Sie nützliche externe Links richtig platzieren.

So wählen Sie ein Tool zur URL-Erfassung aus

Es gibt verschiedene Arten von URL-Erfassungstools. Bei der Auswahl ist es jedoch wichtig, ein Tool auszuwählen, das je nach Zweck und Nutzungsszene über die entsprechenden Funktionen verfügt. Hier erläutern wir die wichtigsten Punkte, auf die Sie bei der Auswahl eines Tools zur URL-Erfassung achten sollten.

Funktion zur Massen-URL-Erfassung

Um URLs effizient zu sammeln, ist es zunächst wichtig, die Möglichkeit zu haben, URLs in großen Mengen abzurufen. Mit dieser Funktion können Sie URLs von mehreren Webseiten oder ganzen Domains gleichzeitig extrahieren und so viel Zeit und Mühe sparen. Dies ist eine wesentliche Funktion, insbesondere bei der Ausrichtung auf große Websites oder mehrere Webseiten.

Datenausgabeformat

Um die gewonnenen URL-Daten effektiv nutzen zu können, ist auch das Ausgabeformat der Daten wichtig. Beispielsweise erleichtern Tools, die im CSV- oder Excel-Format ausgeben können, die spätere Organisation und Analyse von Daten. Wenn es das JSON- oder XML-Format unterstützt, lässt es sich einfacher mit anderen Systemen und Anwendungen verknüpfen und verbessert so die Benutzerfreundlichkeit. Stellen Sie sicher, dass das für Ihr Unternehmen geeignete Ausgabeformat unterstützt wird.

Verarbeitungsgeschwindigkeit und Stabilität

Beim Extrahieren einer großen Anzahl von URLs sind die Verarbeitungsgeschwindigkeit und die Stabilität des Tools sehr wichtig. Wenn die Verarbeitungsgeschwindigkeit langsam ist, verringert sich die Geschäftseffizienz und das Abrufen von Daten von umfangreichen Webseiten nimmt Zeit in Anspruch. Darüber hinaus besteht bei Werkzeugen mit mangelnder Stabilität die Gefahr, dass während des Prozesses Fehler auftreten oder der Prozess unterbrochen wird. Wählen Sie Werkzeuge mit hoher Geschwindigkeit und Stabilität, um einen reibungslosen Prozess zu gewährleisten.

Anpassbarkeit

Einige URL-Extraktionstools verfügen über umfangreiche Anpassungsfunktionen. Wenn Sie die Möglichkeit haben, die Extraktion mithilfe bestimmter URL-Muster oder -Bedingungen einzugrenzen, können Sie Daten entsprechend Ihrem Zweck effizient sammeln. Darüber hinaus ermöglichen Tools zur Feinabstimmung von Filtern und Crawling-Einstellungen eine anspruchsvolle Datenerfassung, die auf Ihre spezifischen Anforderungen zugeschnitten ist. Es empfiehlt sich zu prüfen, ob es an den Zweck Ihres Unternehmens anpassbar ist.

Preis und Wirtschaftlichkeit

Auch Preis und Wirtschaftlichkeit sind wichtige Aspekte bei der Implementierung von Werkzeugen. Einige Tools sind kostenlos, verfügen jedoch möglicherweise über eingeschränkte Funktionalität. Bezahlte Tools hingegen verfügen über erweiterte Funktionen und Support, sodass sie sich für Großprojekte und die kontinuierliche Datenextraktion eignen. Die Wahl eines kostengünstigen Tools, das zu Ihrem Budget und Ihren Anforderungen passt, führt zu langfristigen Kosteneinsparungen.

5 empfohlene URL-Extraktionstools

Hier stellen wir fünf speziell empfohlene URL-Extraktionstools vor. Vergleichen Sie die Funktionen und Vorteile der einzelnen Tools, um das beste für Sie zu finden.

1. Octoparse

Octoparse ist ein leistungsstarkes Data-Scraping-Tool, mit dem Sie Webdaten ohne Code sammeln können. Es verfügt über eine multifunktionale und intuitive Benutzeroberfläche und eignet sich für ein breites Benutzerspektrum, vom Anfänger bis zum fortgeschrittenen Benutzer.

- Die Batch-URL-Erfassung ist einfach und Daten können auch von komplexen Websites effizient extrahiert werden.

- Eine Vielzahl von Datenausgabeformaten (Excel, CSV, API-Verknüpfung usw.)

- Die Cloud-Unterstützung ermöglicht den Zugriff und die Projektverwaltung von mehreren Geräten aus

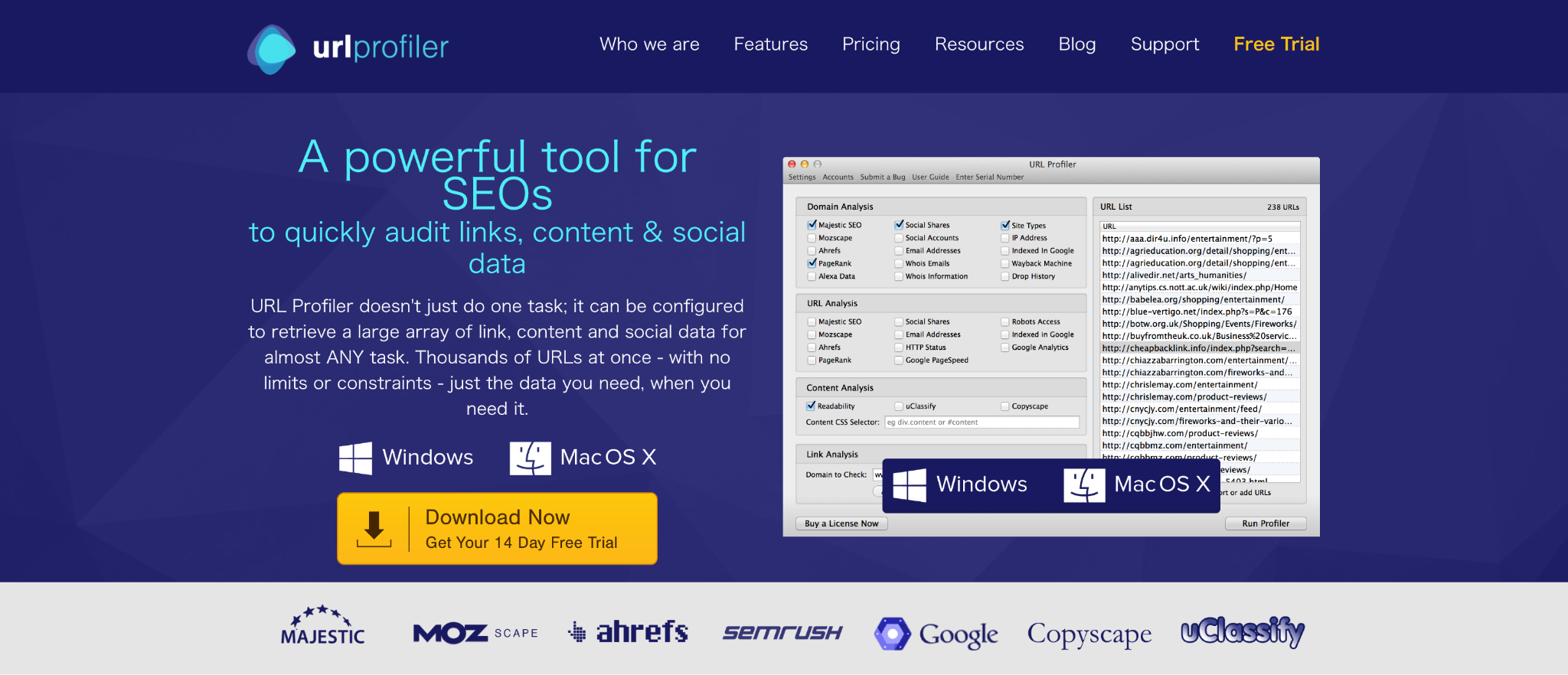

2. URL-Profiler

URL Profiler ist ein URL-Extraktionstool, das auf SEO und Content-Marketing spezialisiert ist und sich zur Wettbewerbsanalyse und Überprüfung von Linkprofilen eignet. Ein multifunktionales und professionelles Werkzeug.

- SEO-Daten können automatisch erfasst werden und es werden nicht nur Linkdaten, sondern auch Inhalts- und SNS-Signalinformationen erfasst.

- Verschiedene Datenexportformate ermöglichen eine einfache Berichterstellung

- Stark in der Verarbeitung großer Datenmengen und kann mehrere URLs in kurzer Zeit analysieren

3. Link-Extraktor

Link Extractor ist ein leichtes Tool zum Extrahieren von URLs, das als Google Chrome-Erweiterung verwendet werden kann. Der Reiz besteht darin, dass Sie damit ganz einfach Links aus Webseiten extrahieren können.

- Einfache Bedienung über einen Browser und sofortige Nutzung nach der Installation

- Über eine einfache Benutzeroberfläche können Sie sofort alle Links innerhalb einer bestimmten Webseite extrahieren.

- Kostenlos verfügbare und für die individuelle Seitenanalyse geeignete Tools

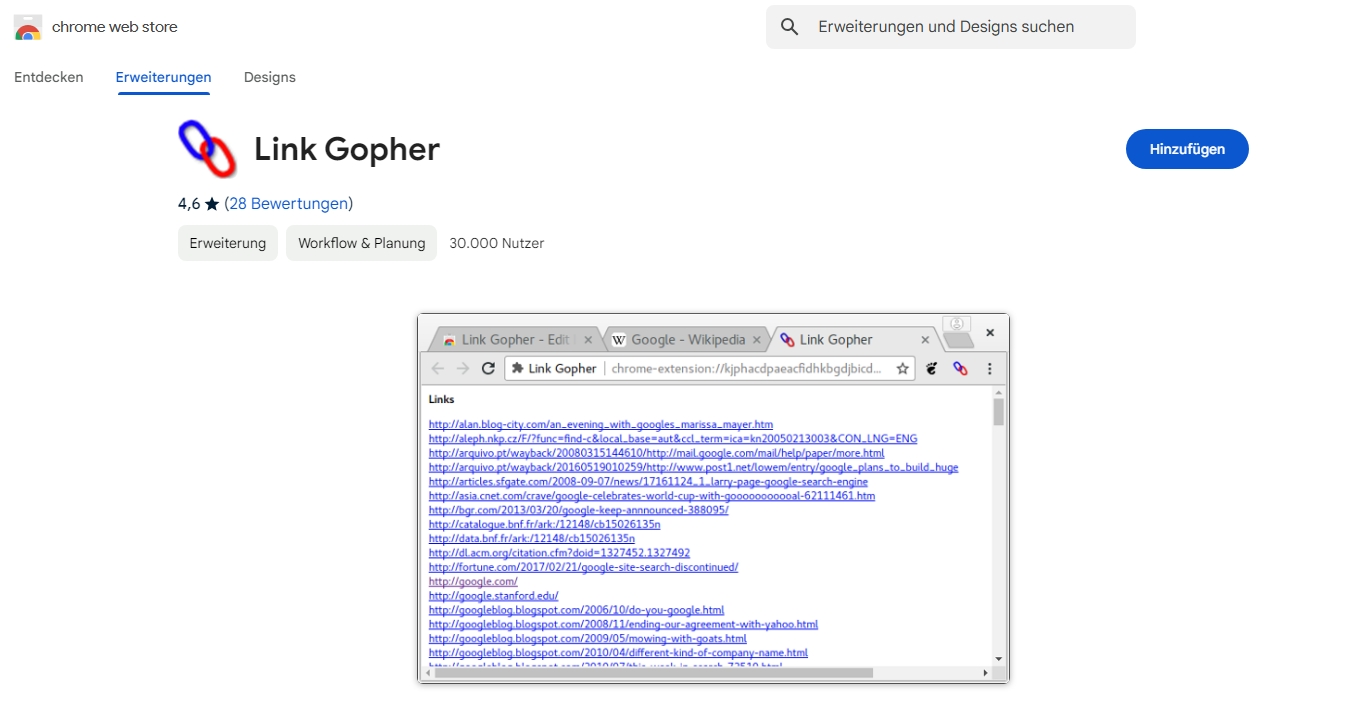

4. Link Gopher

LinkGopher ist ein einfaches und benutzerfreundliches URL-Extraktionstool, das als Chrome-Erweiterung bereitgestellt wird und sich besonders zum Organisieren interner und externer Links eignet.

- Kategorisieren und zeigen Sie Links innerhalb einer Seite an, um die Überprüfung interner und externer Links zu erleichtern

- Die extrahierte URL kann im Textformat ausgegeben werden, was die Datenübertragung erleichtert

- Leicht und kostenlos, einfach zu installieren

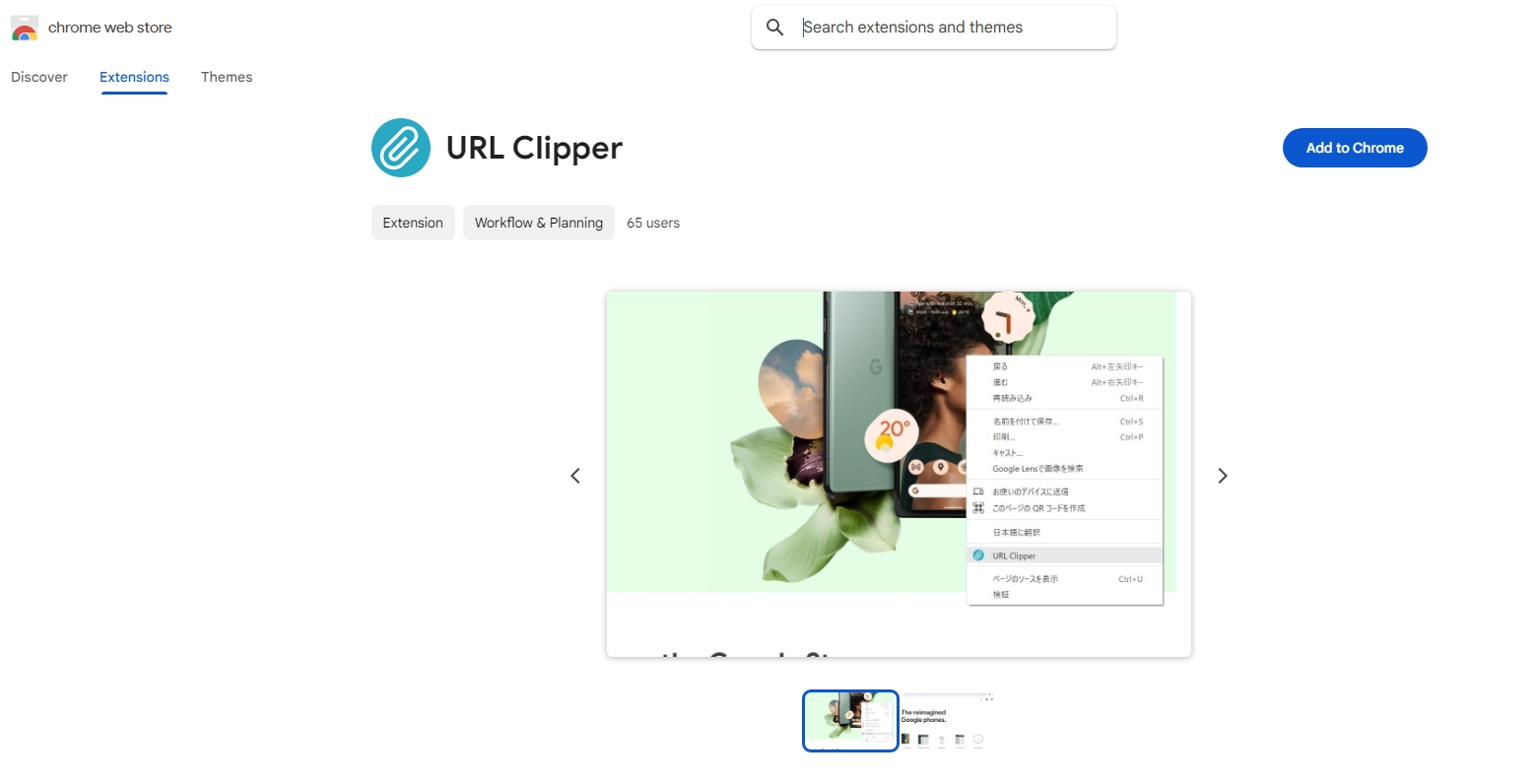

5. URL-Clipper

URL Clipper ist eine einfache, aber äußerst praktische Chrome-Erweiterung, mit der Sie ganz einfach URLs von Seiten erfassen können. Geeignet zum Sammeln von Links für einzelne Seiten.

- Sie können die URL mit einem Klick innerhalb einer Seite kopieren und so problemlos Links sammeln.

- Es gibt eine Funktion zum automatischen Ausschließen doppelter URLs, sodass eine Datenerfassung ohne Verschwendung möglich ist.

- Die Nutzung ist völlig kostenlos, fügen Sie es einfach Ihrem Browser hinzu

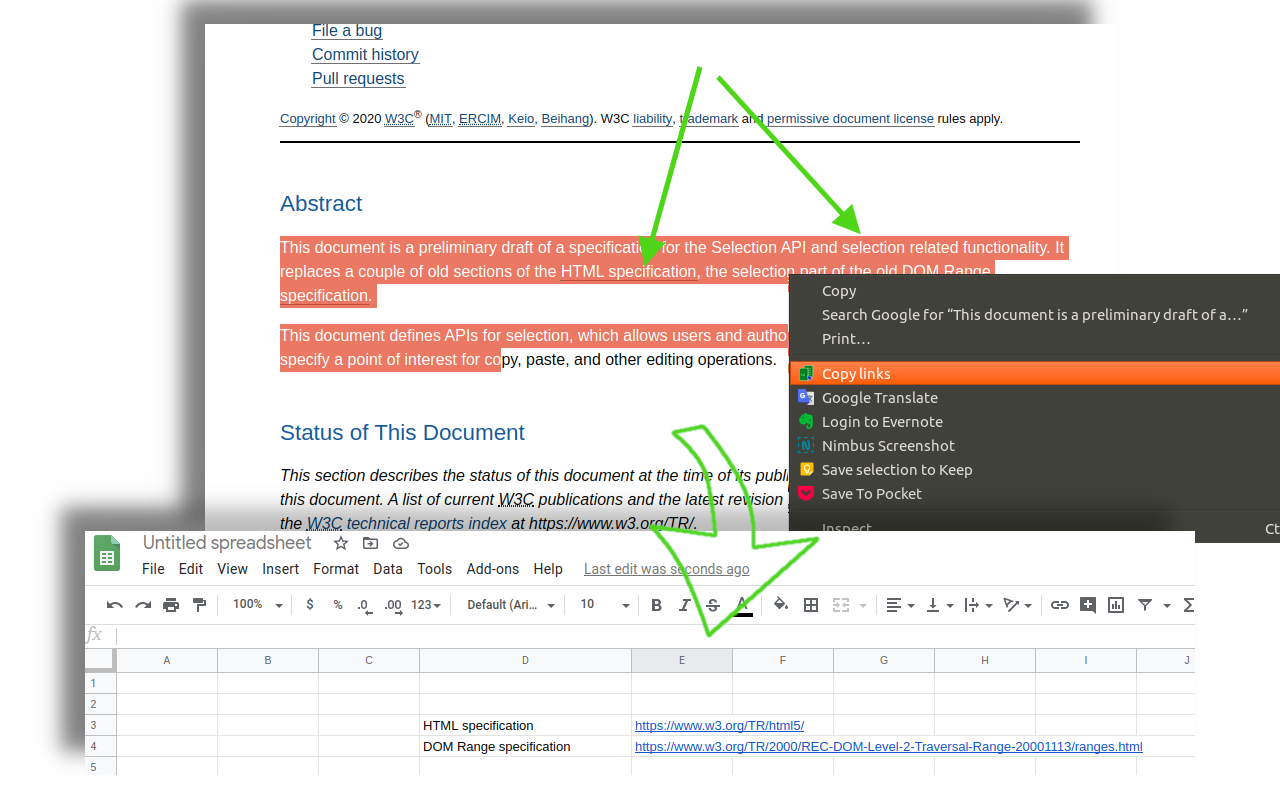

So erhalten Sie mit Python eine Liste von Links auf einer Website

Zusätzlich zur Verwendung eines URL-Extraktionstools gibt es eine Möglichkeit, eine Liste von Links von einer bestimmten Site abzurufen, indem Sie ein Programm mit Python programmieren. Durch die Verwendung der Python-Bibliotheken „BeautifulSoup“ und „Requests“ ist eine hochgradig anpassbare Datenerfassung möglich. Unten finden Sie ein Link-Extraktionsskript mit „BeautifulSoup“.

Codepunkte

- Senden Sie eine HTTP-Anfrage an die in der Anforderungsbibliothek angegebene URL und rufen Sie HTML-Daten ab.

- **BeautifulSoup** analysiert HTML und analysiert Links innerhalb der Seite.

- Extrahieren Sie alle <a>-Tags auf der Seite mit supple.find_all(‘a’) und rufen Sie deren href-Attribute ab.

Zusammenfassung

Die URL-Extraktion ist ein wirksames Mittel für Webmarketing- und SEO-Maßnahmen und kann je nach Einsatz für verschiedene Datenanalysen und Strategieplanungen nützlich sein. Bitte beachten Sie die empfohlenen Tools, die dieses Mal vorgestellt werden, und erfahren Sie, wie Sie sie in Python implementieren, um URL-Daten mit der für Sie am besten geeigneten Methode zu erfassen und für Ihr Unternehmen zu verwenden. Die Auswahl der richtigen Tools verbessert die Arbeitseffizienz und erweitert den Umfang der Datennutzung.

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.