Heutzutage wird Data Mining für unser Leben immer wichtiger. Wenn wir mit zahlreichen Daten konfrontiert sind, kostet es manchmal so viel Zeit. Aber mit Web Scraping Tool oder Data Mining Software könnte man ganz einfach die Daten sammeln und scrapen.

Um unseren Lesern dabei zu helfen, die Technologie der Datenwissenschaft zu beherrschen, haben wir die 80 besten zu lesenden Bücher über Datenwissenschaft und 88 Ressourcen und Tools zum Werden eines Datenwissenschaftler veröffentlicht. In diesem Artikel konzentriere ich mich auf den Bereich des Data Mining. Außer dem Begriff und der Gesetzlichkeit von Data Mining habe ich auch 10 wichtigsten Fähigkeiten zusammengefasst, die Sie benötigen.

Was ist Data Mining?

Data Mining ist systematische Anwendung statistischer Methoden auf große Datenbestände, so dass man neu Trend erkennen oder beherrschen kann. Das heißt, dass Data Mining bedeutet, gültige Informationen aus riesigen Datensätzen zu extrahieren und die Informationen in potenziell nützliche und letztlich verständliche Muster für die weitere Verwendung umzuwandeln.

Es umfasst nicht nur die Datenverarbeitung und -verwaltung, sondern bezieht auch die intelligenten Methoden des maschinellen Lernens, der Statistik und der Datenbanksysteme mit ein, wie Wikipedia definiert. In einigen Fällen könnte man vielleicht aufgrund der Größe von Daten nicht manuell verarbeiten und benötigt deshalb computergestützte Methoden.

Ist Data Mining legal?

In Wikipedia gibt es diese Erklärung: Typischerweise wird man hier jedoch nicht Data-Mining einsetzen, sondern einfachere und spezialisierte Analysemethoden zur Deanonymisierung. Eine derartige Anwendung – und vor allem die unzulängliche Anonymisierung zuvor – sind dann möglicherweise illegal (nach dem Datenschutzrecht).

Das heißt, dass Data Mining eigentlich legal ist, wenn es nur um die extrahierten Daten und die Aktion geht. Das größte Problem ist es, wie man diese Daten verwendet und wofür die Daten benutzt werden.

10 Fähigkeiten für Data Mining

Informatik-Kenntnisse

1. Programmier-/Statistiksprache: R, Python, C++, Java, Matlab, SQL, SAS, Shell/Awk/Sed…

Data Mining beruht in hohem Maße auf der Programmierung, und dennoch gibt es keine einheitliche Meinung darüber, welche Sprache die beste für Data Mining ist. Es hängt alles von dem Datensatz ab, mit dem Sie arbeiten. Peter Gleeson hat vier Spektren als Referenz vorgeschlagen: Spezifität, Allgemeinheit, Produktivität und Leistung. Sie können als Achsenpaar betrachtet werden (Spezifität – Allgemeinheit, Leistung – Produktivität). Die meisten Sprachen lassen sich irgendwo auf dieser Karte einordnen. Laut einer Untersuchung von KD Nuggets sind R und Python die beliebtesten Programmiersprachen für Data Science.

Weitere Ressourcen:

- Welche Sprachen sollte man für Data Science lernen [Freecode Camp]

- Data-Mining-Algorithmen in R [Wikibooks]

- Die besten Python-Module für Data Mining [KD Nuggets]

2. Rahmenwerke für die Verarbeitung von Big Data: Hadoop, Storm, Samza, Spark, Flink

Verarbeitungsframeworks verarbeiten die Daten im System, z. B. durch Auslesen aus nichtflüchtigen Speichern und Einlesen von Daten in Ihr Datensystem. Dies ist der Prozess der Extraktion von Informationen und Erkenntnissen aus großen Mengen einzelner Datenpunkte. Er kann in 3 Kategorien eingeteilt werden: Batch-only, Stream-only und Hybrid.

Hadoop und Spark sind die bisher am häufigsten implementierten Frameworks, da Hadoop eine gute Option für nicht zeitkritische Batch-Workloads darstellt und in der Implementierung kostengünstiger ist als andere. Spark hingegen ist eine gute Option für gemischte Arbeitslasten und bietet eine schnellere Batch-Verarbeitung und Mikro-Batch-Verarbeitung für Streams.

Weitere Ressourcen:

- Hadoop, Storm, Samza, Spark und Flink: Big Data-Frameworks im Vergleich [Digital Ocean]

- Datenverarbeitungs-Framework für Data Mining [Google Scholar]

3. Betriebssystem: Linux

Linux ist ein beliebtes Betriebssystem für Data-Mining-Wissenschaftler, das viel stabiler und effizienter für den Betrieb großer Datensätze ist. Es ist von Vorteil, wenn Sie die gängigen Linux-Befehle kennen und in der Lage sind, ein verteiltes Spark-System für maschinelles Lernen unter Linux einzusetzen.

4. Datenbank-Kenntnisse: Relationale Datenbanken & nicht-relationale Datenbanken

Um große Datenmengen zu verwalten und zu verarbeiten, müssen Sie über Kenntnisse in relationalen Datenbanken wie SQL oder Oracle verfügen. Oder Sie müssen nicht-relationale Datenbanken kennen, deren Haupttypen sind: Column: Cassandra, HBase; Dokument: MongoDB, CouchDB; Schlüsselwert: Redis, Dynamo.

Statistik- und Algorithmus-Kenntnisse

5. Grundlegende Statistikkenntnisse:Wahrscheinlichkeit, Wahrscheinlichkeitsverteilung, Korrelation, Regression, Lineare Algebra, Stochastische Prozesse…

Wenn wir uns an die Definition des Begriffs Data Mining erinnern, wissen wir, dass es beim Data Mining nicht nur um Kodierung oder Informatik geht. Es befindet sich an den Schnittstellen zwischen mehreren Bereichen, von denen die Statistik ein wesentlicher Bestandteil ist. Grundlegende Kenntnisse der Statistik sind für einen Data Miner unerlässlich, da sie ihm helfen, Fragen zu identifizieren, genauere Schlussfolgerungen zu ziehen, zwischen Kausalität und Korrelation zu unterscheiden und auch die Sicherheit seiner Ergebnisse zu quantifizieren.

Weitere Ressourcen:

- Welche statistischen Methoden sollte ich kennen, um Data Science zu betreiben [Quora]

- Statistische Methoden für Data Mining [Research Gate]

6. Datenstruktur & Algorithmen

Zu den Datenstrukturen gehören Arrays, verknüpfte Listen, Stapel, Warteschlangen, Bäume, Hashtabellen, Mengen usw., und zu den gängigen Algorithmen gehören Sortieren, Suchen, dynamische Programmierung, Rekursion usw.

Die Beherrschung von Datenstrukturen und Algorithmen ist für das Data Mining von entscheidender Bedeutung, denn sie ermöglicht es Ihnen, bei der Verarbeitung großer Datenmengen kreativere und effizientere algorithmische Lösungen zu finden.

Weitere Ressourcen:

- Daten, Struktur und die Data Science Pipeline [IBM Developer]

- Coursera: Datenstrukturen und Algorithmen [UNIVERSITY OF CALIFORNIA SAN DIEGO]

7. Maschinelles Lernen/Tiefes Lernen Algorithmus

Dies ist einer der wichtigsten Teile des Data Mining. Algorithmen des maschinellen Lernens erstellen ein mathematisches Modell von Beispieldaten, um Vorhersagen zu treffen oder Entscheidungen zu treffen, ohne dass sie explizit für die Durchführung der Aufgabe programmiert werden. Und Deep Learning ist Teil einer breiteren Familie von Methoden des maschinellen Lernens. Maschinelles Lernen und Data Mining verwenden oft die gleichen Methoden und überschneiden sich erheblich.

Weitere Ressourcen:

- Grundlagen der Algorithmen des maschinellen Lernens mit Python- und R-Codes [Analytics Vidhya]

- Eine kuratierte Liste von fantastischen Frameworks, Bibliotheken und Software für maschinelles Lernen (nach Sprache) [Github josephmisiti]

8. Verarbeitung natürlicher Sprache

Die Verarbeitung natürlicher Sprache (Natural Language Processing, NLP), ein Teilgebiet der Informatik und der künstlichen Intelligenz, hilft Computern, die menschliche Sprache zu verstehen, zu interpretieren und zu manipulieren. NLP wird häufig für die Segmentierung von Wörtern, die syntaktische und semantische Analyse, automatische Zusammenfassungen und textuelle Folgerungen verwendet. Für Data Miner, die mit großen Textmengen umgehen müssen, ist es ein Muss, die NLP-Algorithmen zu kennen.

Weitere Ressourcen:

- 10 NLP-Aufgaben für Datenwissenschaftler [Analytics Vidhya]

- Eine kuratierte Liste von fantastischen Frameworks, Bibliotheken und Software für maschinelles Lernen (nach Sprache) [Github josephmisiti]

- Open Source NLP-Bibliotheken: Standford NLP; Apache OpenNLP; Naturel Language Toolkit

Andere

9. Projekterfahrung

Ihre Projekterfahrung ist der wichtigste Beweis für Ihre Data-Mining-Fähigkeiten. Auf die Frage, wie man den ersten Job in der Datenwissenschaft bekommt, sagte David Robinson, der Chief Data Scientist bei DataCamp, „Die effektivste Strategie für mich war, öffentlich zu arbeiten. Ich habe gebloggt und gegen Ende meiner Promotion viel Open-Source-Entwicklung betrieben, was dazu beigetragen hat, meine datenwissenschaftlichen Fähigkeiten öffentlich unter Beweis zu stellen.“

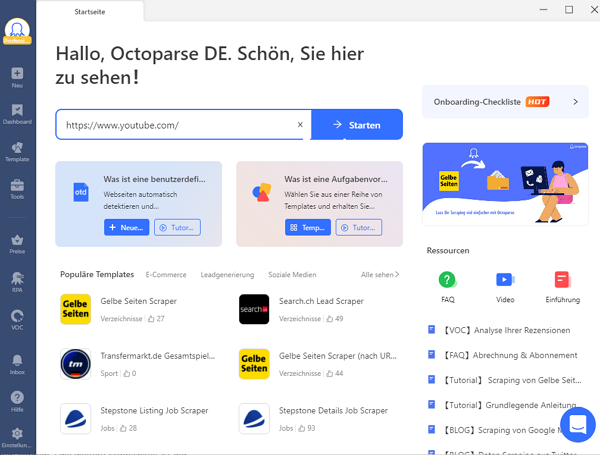

Der Einsatz von Tools zur Unterstützung Ihrer Projektbearbeitung ist wichtig. Als einfaches, aber leistungsstarkes Web-Data-Mining-Tool ist Octoparse eine gute Wahl für Sie, da es automatisch Datenextraktion machen kann. Es ermöglicht Ihnen, hochpräzise Extraktionsregeln zu erstellen. Die in Octoparse ausgeführten Crawler werden durch die konfigurierte Regel bestimmt. Die Extraktionsregel teilt Octoparse mit, welche Website besucht werden soll, wo sich die Daten befinden, die gecrawlt werden sollen, welche Art von Daten Sie suchen und vieles mehr.

Sie können Daten mit Octoparse Web Data Miner in 3 einfachen Schritten extrahieren. Oder Sie können auch der detaillierten Octoparse-Bedienungsanleitung folgen:

- Schritt 1: Kopieren Sie die Ziel-URL und fügen Sie sie in das Octoparse-Hauptfenster ein, nachdem Sie es auf Ihre Geräte heruntergeladen haben.

- Schritt 2: Extrahieren Sie Daten im automatischen Erkennungsmodus und passen Sie den Arbeitsablauf auf der rechten Seite an. Sie können auch die voreingestellten Vorlagen ausprobieren.

- Schritt 3: Führen Sie die Aufgabe aus, nachdem Sie eine Vorschau erhalten haben. Nach ein paar Minuten können Sie die Daten in Excel, CSV oder andere Formate herunterladen, die für die weitere Verwendung geeignet sind.

10. Kommunikations- und Präsentationsfähigkeiten

Data Miner befassen sich nicht nur mit Daten, sondern sind auch dafür verantwortlich, anderen die Ergebnisse und Erkenntnisse zu erklären, die sie aus den Daten ziehen. Manchmal müssen sie diese auch einem nichttechnischen Publikum erklären, z. B. dem Marketingteam. Sie sollten in der Lage sein, Datenergebnisse zu interpretieren und Geschichten zu erzählen, sowohl mündlich als auch schriftlich und in Form von Präsentationen.

NO-Code Data Mining Tool

Octoparse ist ein einfacher und intuitiver Web Scraper für die Datenextraktion ohne Codierung. Es kann sowohl auf Windows- als auch auf Mac OS-Systemen verwendet werden. Unterdessen ist Octoparse eine Sorftware besonders einfach für die Anfänger. Egal, ob Sie zum ersten Mal selbst starten, ein erfahrener Experte oder Unternehmer sind, es wird Ihre Bedürfnisse in 3 Schritten erfüllen:

- Schritt 1: Unterladen Octoparse und registrieren Sie.

- Schritt 2: Öffnen Sie die Webseite, die Sie scrapen müssen, und kopieren Sie die URL. Fügen Sie dann die URL in Octoparse ein und starten Sie das automatische Scraping. Passen Sie später das Datenfeld im Vorschaumodus oder Workflow auf der rechten Seite an.

- Schritt 3: Starten Sie das Scraping, indem Sie auf “Apply und Run” klicken. Die extrahierten Daten können in eine Excel-Datei auf Ihr lokales Gerät heruntergeladen werden.

Hier bekommen Sie Octoparse! 🤩

Preis: $0~$249 pro Monat

Packet & Preise: Octoparse Premium-Preise & Verpackung

Kostenlose Testversion: 14-tägige kostenlose Testversion

Herunterladen: Octoparse für Windows und MacOs

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Autor*in: Das Octoparse Team ❤️

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.