Kein einziges Unternehmen kann ohne Daten überleben. Tatsache ist jedoch, dass wir mit Daten überschwemmt werden. Besonders aufgrund der Covid-19-Pandemie brauchen wir sogar viel Daten für Ihren Unternehmen, so dass man eine bessere Entscheidung treffen könnte. In diesem Fall könnte man beim Web Scraping einen umfassenden Überblick auf der Tendenz der Pandemie in den Rohdaten bekommen. Die Umwandlung von Daten in wertvolle Informationen ist für Unternehmen, die weiter wachsen wollen, von zentraler Bedeutung. Business Intelligence kommt zum Einsatz, wenn es Rohdaten in verwertbare Erkenntnisse umwandelt. Wie funktioniert BI? Ich werde dies anhand eines konkreten Beispiels von der Datenextraktion bis zur Dateninterpretation erläutern.

In den folgenden Abschnitten erfahren Sie etwas über die Definition von Rohdaten und den Unterschied zwischen Rohdaten und Informationen. Außerdem erhalten Sie auch, wie Sie Rohdaten in 3 Schlüsselschritten in Informationen umwandeln.

Was sind Rohdaten?

Rohdaten werden auch als Primärdaten bezeichnet. Sie werden aus einer Quelle gesammelt und müssen verarbeitet werden, um sie aufschlussreich zu machen. Im Geschäftsleben können Daten überall vorkommen. Es können externe Daten sein: Daten, die im Internet kursieren, wie Bilder, Instagram-Posts, Facebook-Follower, Kommentare und Follower der Konkurrenz. Es können aber auch interne Daten sein: Daten aus einem betrieblichen System wie einem Content Management System (CMS).

Im Vergleich dazu sind Informationen verarbeitete und organisierte Daten, die in Form von Mustern und Trends zur besseren Entscheidungsfindung dargestellt werden. Ich möchte hier Martin Doyle zitieren: „Computer brauchen Daten. Menschen brauchen Informationen. Daten sind ein Baustein. Informationen geben Bedeutung und Kontext.“

Wie kann man Rohdaten in nützliche Informationen umwandeln?

Jetzt haben Sie eine allgemeine Vorstellung von den beiden, lassen Sie uns den mittleren Teil im Detail aufschlüsseln. Wir werden den Prozess der Rohdatenauswertung in 3 große Schritte unterteilen.

Schritt 1: Extraktion der Rohdaten

Dies ist der wichtigste Schritt, um die folgenden Schritte zu ermöglichen. Es handelt sich um einen Null-zu-Eins-Prozess, bei dem wir mit dem Aufbau von Blöcken beginnen müssen. Bei der Datenextraktion geht es darum, Daten aus verschiedenen Quellen im Internet zu scrapen. In dieser Phase läuft der gesamte Prozess in drei Schritten ab:

- Identifizieren der Quelle: Bevor wir mit der Extraktion beginnen, ist es ganz wichtig und notwendig, ob die Quelle legal zu extrahieren ist und die Qualität der Daten stimmt. Dazu können Sie Terms of Service (ToS) prüfen, um detaillierte Informationen zu erhalten. Wir alle wissen zum Beispiel, dass LinkedIn eine Menge Werte in Bezug auf Verkaufsperspektiven hat. LinkedIn hat sich das auch gedacht und ist daher sehr streng mit jeder Art von Scraping-Technik, die auf seine Websites zugreift.

- Beginnen mit der Extraktion: Sobald Sie die Quellen bereit haben, können Sie mit der Extraktion beginnen. Es gibt viele Möglichkeiten, wie Sie Daten extrahieren können. Eine gute Methode ist heutzutage das Web Scraping. Ein automatisiertes Web-Scraping-Tool ist sehr nützlich, da Sie damit keine eigenen Skripte schreiben oder Entwickler einstellen müssen. Es ist die nachhaltigste und zugänglichste Lösung für Unternehmen mit begrenztem Budget, aber großem Bedarf an Daten.

Bestes Datenextraktionstool (keine Kodierung)

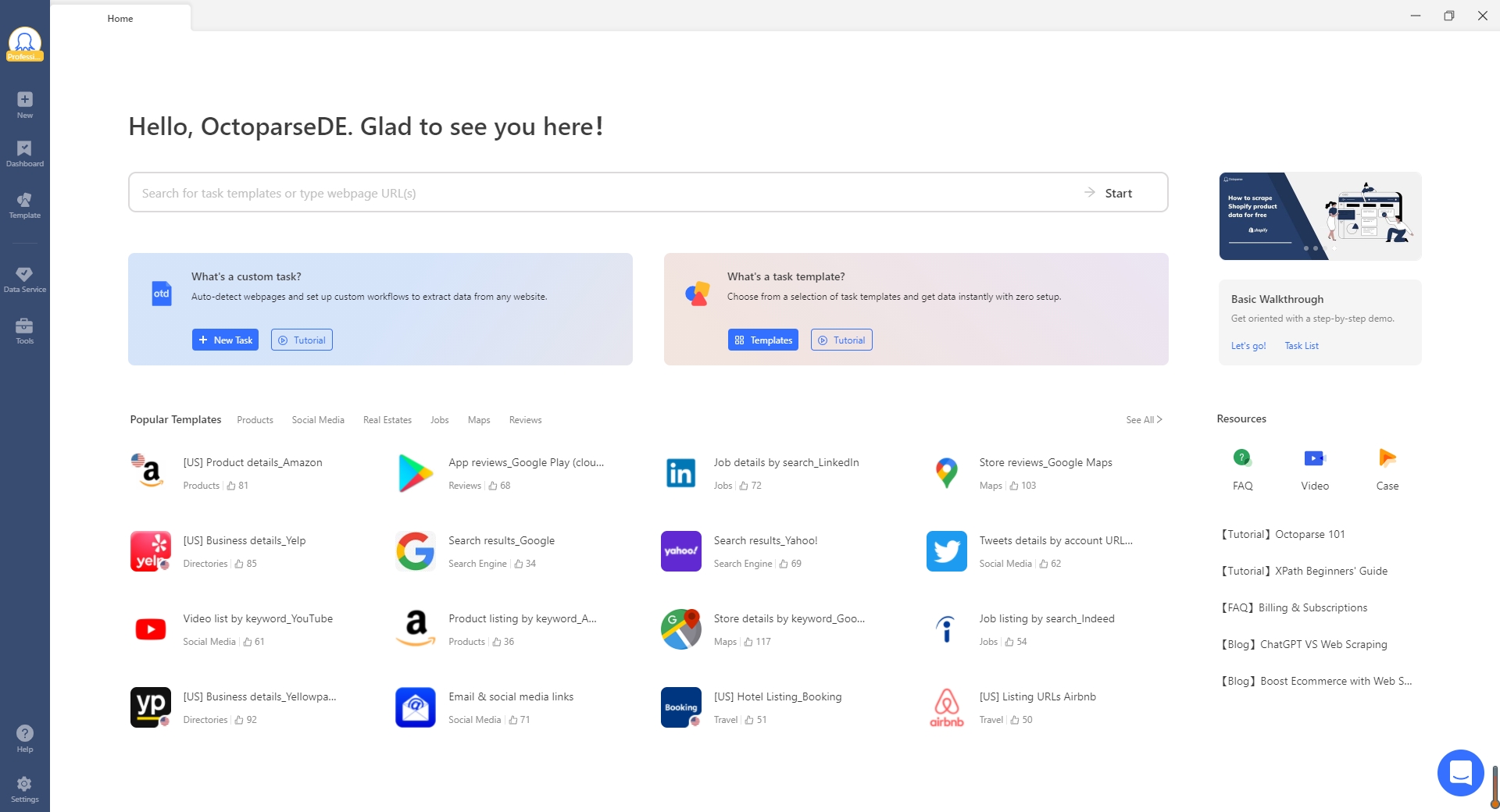

Wenn ich ein paar der besten Web-Scraping-Tools nennen soll, sticht Octoparse als das intuitivste und benutzerfreundlichste Web-Scraping-Tool unter den anderen hervor. Seine bemerkenswerten Funktionen wie Dateidownloads, Cloud-Läufe und vieles mehr machen das Extrahieren von Webdaten zu einem einfachen Prozess und bieten Ihnen das reibungsloseste und zuverlässigste Scraping-Erlebnis. Darüber hinaus bietet es über 50 Web-Scraping-Vorlagen, die integrierte Crawler sind, die Sie ohne weitere Konfiguration verwenden können. Es verfügt auch über einen automatischen Erkennungsmodus, der für Anfänger, die keine Ahnung vom Programmieren haben, sehr gut geeignet ist. Wir empfehlen Ihnen also, es zuerst auszuprobieren, bevor Sie zu früh zur nächsten Option wechseln.

Sie können die Datenextraktion von jeder Website in den folgenden 3 Schritten abschließen. Weitere Details finden Sie auf der Octoparse-Hilfezentrum.

Prozess 1: Fügen Sie den Link zur Zielseite in das Octoparse-Hauptfenster ein und klicken Sie auf den „Start“ Button. Sie können auch nach beliebigen Schlüsselwörtern suchen, um die voreingestellten Vorlagen zu finden.

Prozess 2: Standardmäßig wird die automatische Erkennungsfunktion aktiviert. Erstellen Sie hier einen Workflow, und ändern Sie das gewünschte Datenfeld durch Ziehen oder klicken Sie auf den Workflow/Tipps auf der rechten Seite.

Prozess 3: Prüfen Sie den Workflow und sehen Sie sich das Datenbeispiel an, um sicherzustellen, dass alle gewünschten Daten extrahiert werden können. Speichern Sie den Workflow und führen Sie ihn aus, um mit der Extraktion der Daten zu beginnen. Sie können die Daten in Excel oder einem anderen Format auf Ihre lokalen Geräte herunterladen.

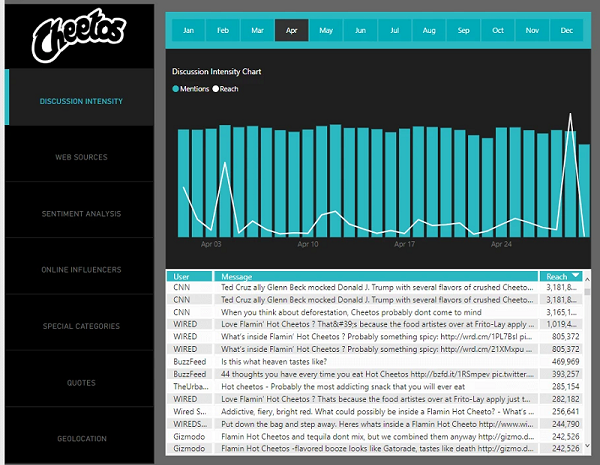

Hier ist ein Beispiel für die Ausgabe: Mit der Octoparse Twitter Scraping-Vorlage habe ich 5k Zeilen an Daten gesammelt, einschließlich die Benutzer-ID, Handles, Inhalte, Video-URLs und Bild-URLs. Sobald Sie die Daten erhalten haben, können Sie sie in das gewünschte Format ausgeben oder über eine API mit einer Analyseplattform wie PowerBI oder Tableau verbinden. Da ich kein Experte für PowerBI bin, habe ich mir den Bericht von Microsoft ausgeliehen, um meinen Standpunkt darzustellen. Die Idee ist, dass Sie soziale Medien überwachen können, indem Sie jeden Tag eine Twitter-Extraktion planen und eine Verbindung zu einer bevorzugten Analyseplattform über API herstellen.

Schritt 2: Datenanalyse

In der Analysephase muss die Genauigkeit der Daten überprüft werden, da sich die Qualität der Daten direkt auf das Analyseergebnis auswirken kann. In dieser Phase werden die Daten in verschiedenen Berichtsformaten wie Visualisierung und Dashboard an die Benutzer weitergegeben. Verwenden wir Power BI zur Überwachung und Analyse von Social-Media-Plattformen, um meine Marketingstrategie, die Produktqualität und das Krisenmanagement zu testen.

Dies ist ein Beispiel für die Verwendung von POWER BI, um die Daten in Informationen zu verwandeln.

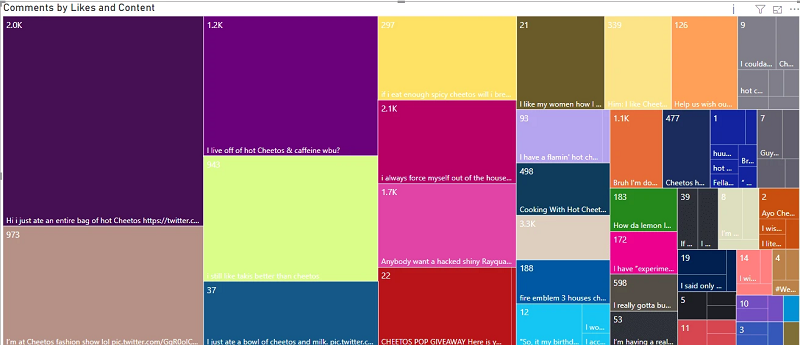

Oder Sie können analysieren, welche Beiträge die meisten Likes erhalten.

Okay, jetzt haben Sie das visuelle Dashboard, wie können Sie es analysieren?

In der Wirtschaft müssen Informationen im Zusammenhang mit dem Kontext des Unternehmens interpretiert werden. Der Kontext ist die wichtigste Komponente, um verwertbare Erkenntnisse zu gewinnen. Nehmen wir Cheetos als Beispiel. Sie können sehen, dass die Trendlinie der Erwähnungen im April bei 50.000 liegt. Die Anzahl der Erwähnungen von Cheetos in Twitter steigt im April auf 50.000. Das ist eine riesige Zahl, die aber nichts Wertvolles aussagt, außer dem Volumen der Erwähnungen zu diesem Zeitpunkt.

Wie wäre es, wenn ich die Anzahl der Erwähnungen aus den Vormonaten herausnehme und sie mit denen dieses Monats vergleiche?

- April: 50k Erwähnungen

- März: 40k Erwähnungen

- Februar: 1673 Erwähnungen

Nun, da wir den Kontext liefern, interpretiere ich die Informationen folgendermaßen:

- Cheetos gewinnt 10k Erwähnungen von März bis April.

- Cheetos gewinnt 38.000 Erwähnungen von Februar bis März.

Wir können sagen, dass Cheetos fast über Nacht populär geworden sind. Und das Mundpropaganda-Marketing ist erfolgreich. Daher sollten wir diese Strategie fortsetzen und jeden in Cheetos eintauchen lassen.

Eingentlich sind Daten an sich bedeutungslos. Die meisten Unternehmen verfügen über ähnliche Arten von Daten, aber in unterschiedlichem Umfang. Die Informationen, die sie gewinnen, sind jedoch unterschiedlich. Der Transformationsprozess bezieht den Kontext der jeweiligen Organisation mit ein.

Schritt 3: Speicherung der Daten

Die Datenspeicherung ist die Schlüsselkomponente, da die Unternehmen auf sie angewiesen sind, um die Daten zu bewahren. Die Datenspeicherung variiert in Kapazität und Geschwindigkeit. Mit der Fülle von Big Data tauchen immer mehr Speicheranbieter auf und drängen auf den Markt. Hier finden Sie eine Liste zuverlässiger Anbieter, die Sie bevorzugen.

Web-Scraping-Tools wie Octoparse bieten eine Reihe von Funktionen für die Datenextraktion aus dynamischen Websites, die Datenbereinigung mit integrierter Regex, den Datenexport in strukturierte Formate und die Cloud-Speicherung. Das Beste daran ist, dass es mit geringem Aufwand eine Verbindung zu Ihrer lokalen Datenbank herstellen kann. Ertrinken Sie nicht in den Daten, sondern lassen Sie sich von einem intelligenten Tool mitnehmen.

Hier bekommen Sie Octoparse! 🤩

Preis: $0~$249 pro Monat

Packet & Preise:Octoparse Premium-Preise & Verpackung

Kostenlose Testversion: 14-tägige kostenlose Testversion

Herunterladen:Octoparse für Windows und MacOs

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Autor*in: Das Octoparse Team ❤️