Web Scraping, auch Datenextraktion genannt, ist der Prozess der Verwendung von Software zur Extraktion von Daten aus Online-Websites. Nachrichten-Web-Scraping wird verwendet, um automatisch Nachrichten, Blogbeiträge, Artikel und ähnliche Informationen aus Online-Quellen zu sammeln. Diese fortschrittliche Technik ist weit verbreitet, vor allem weil sie in kurzer Zeit eine große Menge an Daten abrufen kann.

In diesem Artikel wird erläutert, was Web-Scraping von Nachrichten und Artikeln ist und welche Bedeutung es hat. Außerdem werden die rechtlichen Aspekte untersucht und eine einfache Anleitung zum effektiven Scraping von Nachrichten und Artikeln gegeben.

Was ist Web Scraping für Nachrichten und Artikel?

Web Scraping für Nachrichten und Artikel beginnt mit der Sammlung von Seiten-URLs, auf denen sich die benötigten Daten befinden. Anschließend wird ein Web Scraping-Tool oder -Skript verwendet, um die gewünschten Inhalte abzurufen und für die spätere Verwendung zu speichern. Dieser Prozess ermöglicht es Nachrichtenagenturen, Journalisten, Forschern und Unternehmen, mit den neuesten Informationen auf dem Laufenden zu bleiben, zahlreiche Nachrichtenquellen schnell zu überwachen, Konkurrenten zu verfolgen und sogar Daten für maschinelle Lernalgorithmen bereitzustellen.

Nachrichten- und Artikel-Websites, die sich für Data Scraping eignen

Da sie häufig mit zeitkritischen Inhalten aktualisiert werden, gehören Nachrichten-Websites zu den am häufigsten gescrapten Websites. Dazu gehören globale Nachrichtenquellen wie CNN, T-Online.de, Bild.de, Oddsportal usw. Auch spezialisierte Nachrichtenplattformen wie Bloomberg für Finanznachrichten. Diese Websites bieten ein breites Spektrum an Daten, von lokalen bis hin zu internationalen Nachrichten.

Artikel-Websites bieten vertieftes Wissen über bestimmte Bereiche. Dazu gehören beispielsweise Leitartikel und Meinungsbeiträge von Websites wie Medium sowie informative Artikel von Digital Journal. Das Scraping von Artikel-Websites erweist sich als vorteilhaft für das Kuratieren von Inhalten, Wettbewerbsanalysen oder den Erwerb von branchenspezifischem Wissen.

Die Bedeutung von Web Scraping für Artikel und Nachrichten

In der schnelllebigen digitalen Welt ist es wichtig, mit den neuesten Informationen auf dem Laufenden zu bleiben. Web Scraping stellt eine wichtige Veränderung beim Zugriff auf und der Nutzung von Online-Nachrichten und -Inhalten dar, da es die Sammlung von Nachrichten und Artikeln automatisieren und vereinfachen kann.

Nachrichten-Aggregation: Web Scraping spielt eine entscheidende Rolle bei der Konsolidierung von Online-Nachrichten und Artikeln aus verschiedenen Quellen auf einer einzigen Plattform für den bequemen Zugriff. Web Scraping erreicht all dies automatisch und spart Zeit im Vergleich zu dem mühsamen Prozess des manuellen Auffindens, Zusammenstellens und Organisierens von Artikeln aus zahlreichen Nachrichten-Websites. Für Journalisten, Forscher und alle anderen, die sich über das Weltgeschehen auf dem Laufenden halten wollen, ist dies sehr hilfreich und zeitsparend.

Akademische Forschung: Forscher benötigen häufig eine Vielzahl von Informationen aus veröffentlichten Werken und Webpublikationen. Mit Web-Scraping-Techniken können Forscher genauer und effizienter Daten aus bestimmten Artikeln abrufen, die sich auf ihre Studienfrage beziehen. Web Scraping kann auch helfen, Muster, Trends und Verbindungen zwischen verschiedenen Forschungsthemen oder -bereichen zu erkennen, was zur Entdeckung neuer Forschungsmöglichkeiten führen kann.

Stimmungsanalyse: Die Stimmungsanalyse extrahiert, misst und identifiziert Daten aus einer Vielzahl von Quellen mithilfe von Techniken zur Verarbeitung natürlicher Sprache. In diesem Prozess ist Web Scraping ein zuverlässiger Weg, um die notwendigen Daten zu sammeln, insbesondere wenn es sich um Kundenrezensionen, Feeds sozialer Netzwerke oder Nachrichten handelt. Die Automatisierung des Prozesses ermöglicht die Erfassung präziserer Daten über die öffentliche Meinung zu Unternehmen, Produkten oder Ereignissen. Unternehmen können die gesammelten Daten nutzen, um ihre Markenreputation zu verwalten, Branchentrends zu antizipieren, datengestützte Entscheidungen zu treffen und die Erfahrungen der Verbraucher besser zu verstehen.

Die Rechtmäßigkeit des Scraping von Daten aus Nachrichten- und Artikelseiten

Die Rechtmäßigkeit des Web-Scrapings von Nachrichten- und Artikel-Websites ist komplex und hängt von verschiedenen Faktoren ab. Die rechtlichen Ansichten zu Web-Scraping variieren je nach Jurisdiktion, und die entsprechenden Regeln können erheblich unterschiedlich sein. Im Allgemeinen gilt Web-Scraping als rechtmäßig, es kann jedoch illegal sein, wenn es gegen Nutzungsbedingungen verstößt, Urheberrechte verletzt oder unbefugten Zugriff auf Daten ermöglicht.

Einige Websites untersagen Web Scraping ausdrücklich in ihren Nutzungsbedingungen, was rechtliche Folgen nach sich ziehen kann. Wenn die Informationen jedoch öffentlich zugänglich sind und das Scraping nicht gegen die Nutzungsbedingungen verstößt, ist es in der Regel rechtlich unbedenklich. Es ist wichtig, beim Web-Scraping die Datenschutzrichtlinien zu beachten und gegebenenfalls die Zustimmung einzuholen.

Wie man Nachrichten- und Artikel-Websites ohne Programmierung scrapen kann

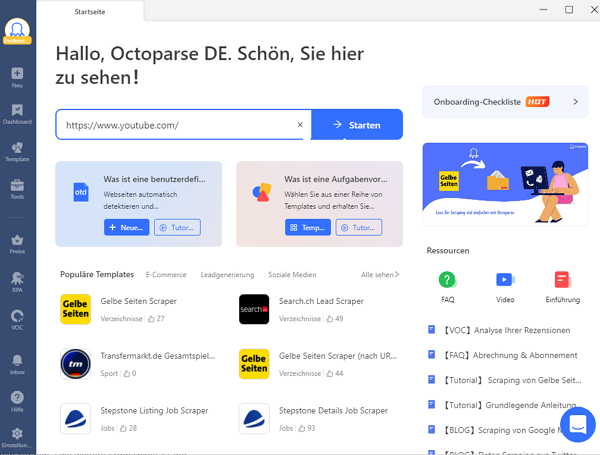

Machen Sie sich keine Sorgen, wenn Ihre technischen Kenntnisse oder Ihr Wissen über Python-Programmierung nicht erstklassig sind. Octoparse ist hier, um Ihre Web-Scraping-Bedürfnisse zu erleichtern. Mit seinen tausenden von Funktionen erleichtert es das schnelle Scraping von Nachrichten von fast allen Websites, auch ohne Python oder technische Kenntnisse.

Octoparse ist sowohl in einer kostenlosen als auch in einer Premium-Version erhältlich und bietet eine Vielzahl umfassender Funktionen. Es ist in der Lage, mehrere Nachrichtenseiten in kürzester Zeit zu scrapen. Aber wie genau kann man es für das Scraping von Websites nutzen?

Schritt 1: Geben Sie die URL(s) der Nachrichten- und Artikelseite ein

Kopieren Sie einfach die gewünschte(n) URL(s) und fügen Sie sie in die Suchleiste in Octoparse ein. Klicken Sie auf die Schaltfläche „Start“, eine neue Aufgabe wird gestartet und die entsprechende Webseite wird in Octoparse’s eingebautem Browser geladen.

Schritt 2: Erstellen Sie einen Workflow und wählen Sie die gewünschten Datenfelder aus

Warten Sie, bis die Seite vollständig geladen ist, und klicken Sie dann in den Tipps auf „Webpage-Daten automatisch erkennen“. Octoparse scannt die Seite und markiert extrahierbare Daten für Sie. Sie können die erkannten Datenfelder bearbeiten und überflüssige Felder am unteren Rand entfernen. Klicken Sie auf „Workflow erstellen“, sobald Sie alle gewünschten Daten ausgewählt haben. Der Workflow wird dann auf der rechten Seite angezeigt.

Schritt 3: Ausführen der Aufgabe und Export der gesammelten Daten

Sobald Sie alle Details überprüft haben, können Sie mit einem Klick auf die Schaltfläche „Ausführen“ fortfahren. Dann haben Sie die Möglichkeit, die Aufgabe entweder auf Ihrem eigenen Gerät auszuführen oder die Cloud-Server von Octoparse zu nutzen. Nachdem der Prozess vollständig abgeschlossen ist, können Sie die gesammelten Daten zur weiteren Verwendung in lokale Dateien wie Excel oder eine Datenbank wie Google Sheets verschieben.

Übrigens lohnt es sich immer, zuerst zu prüfen, ob es eine Vorlage gibt, die für Sie geeignet ist. In diesem Fall müssen Sie nur ein paar Parameter eingeben, um die benötigten Daten abzurufen. Wenn keine der Vorlagen Ihren Anforderungen entspricht und Sie keinen eigenen Scraper erstellen möchten, senden Sie uns eine E-Mail mit Ihren Projektdetails und Anforderungen. Wir sind Ihnen gerne behilflich!

Octoparse bietet über 100 benutzerfreundliche Vorlagen, um Daten zu extrahieren. Über 30.000 Nutzer verwenden die Vorlagen

https://www.octoparse.de/template/odds-portal-scraper

Zusammenfassung

News Scraping ist eine effiziente Methode, um wichtige Informationen zu globalen Schlagzeilen ohne intensive Recherche zu sammeln. Octoparse ist ein hervorragendes Tool, das eine schnelle Datenextraktion aus Nachrichten-Websites ermöglicht und dabei hilft, nützliche Nachrichten- und Artikeldaten zu sammeln, um das Geschäft anzukurbeln. Also, was hält Sie auf? Laden Sie einfach die Octoparse-Software herunter und beginnen Sie mit dem nahtlosen Scraping von Artikeln und Nachrichten-Websites!

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.