Von dem Alltagsleben zu den Ereignisse ganzer Welt spielt Web Scraping eine wichtige Rolle, wenn wir die Daten brauchen und sie analysieren möchten, um unsere Entscheidung effektiver und besser zu treffen. Aber die meisten Leute haben wahrscheinlich einen unklaren Überklick über den Begriff von Web Scraping. Deshalb werden wir heute zusammen Web Scraping lernen.

Was ist ein Web Scraping Tool?

Web Scraping, auch Screen Scraping oder Data Scraping genannt, ist eine Technologie zur Datenerfassung. Beim Web Scraping werden Daten von Websites extrahiert und gespeichert, sodass man sie analysieren oder bearbeiten kann.

Ein Web Scraper kann leicht als ein Werkzeug verstanden werden, das Ihnen hilft, unstrukturierte Daten von Websites schnell auszulesen und zu erfassen sowie sie in strukturierte Formate wie Excel, Text oder CVS umzuwandeln. Der am meisten anerkannte Wert eines Web Scraping Tools besteht darin, dass es einen von der unrealistisch mühsamen Arbeit des Kopierens und Einfügens befreit, die ewig gedauert hätte. Die Software kann automatisch durchgeführt werden, so dass Sie die benötigten Daten pünktlich im gewünschten Format erhalten.

Es gibt viele verschiedene Web Scraping Tools, einige erfordern einen eher technischen Hintergrund, andere werden von Nicht-Programmierern entwickelt. Ich werde die fünf besten Web Scraping Tools, die ich bisher verwendet habe, eingehend vergleichen und dabei auch auf die Preise und den Inhalt der verschiedenen Pakete eingehen.

Ist Web Scraping erlaubt?

Ich kann Ihnen bestimmt sagen, natürlich JA! In vielen Fällen ist Web Scraping legal und erlaubt. Der Bundesgerichtshof hat dazu im Jahr 2014 festgelegt, dass Web Scraping legal ist, wenn man bei der Datenerfassung keine Schutzwand überschritten hat. Eigentlich werden nur die öffentlichen Daten in meisten Fällen abgeruft. Wenn jedoch einige Websites Datenschutz beim Web Scraping hätten, sollten Sie seine Regeln befolgen.

Wer braucht Daten?

- Ich bin Student und brauche Daten zur Unterstützung meiner Forschung/Abschlussarbeit oder zur Datenerfassung von Jobs.

- Ich bin Marketinganalyst und muss Daten zur Unterstützung meiner Marketingstrategie sammeln.

- Ich bin Produktguru und benötige Daten für eine Wettbewerbsanalyse der verschiedenen Produkte.

- Ich bin CEO und benötige Daten über alle Geschäftsbereiche, die mir bei meinem strategischen Entscheidungsprozess helfen.

- Ich bin Datenanalyst und kann meine Arbeit nicht ohne Daten erledigen.

- Ich bin im E-Commerce tätig und muss wissen, wie sich die Preise für die Produkte entwickeln werden, die ich verkaufe.

- Ich bin Händler und brauche UNBEGRENZTE Finanzdaten, um meine nächsten Schritte auf dem Markt zu planen.

- Ich bin im Bereich des maschinellen Lernens tätig und brauche eine Fülle von Urdaten, um meine Bots zu trainieren.

Es gibt so viele weitere, buchstäblich unzählige Gründe, warum Menschen Daten benötigen!

Die beliebtesten Web Scraping Tools

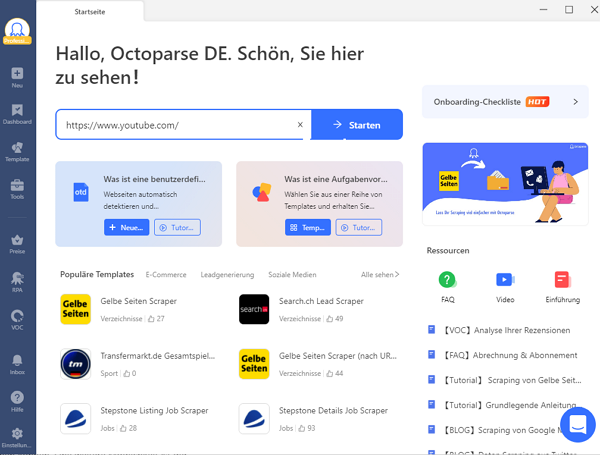

1. Octoparse ⭐⭐⭐⭐⭐

Octoparse ist ein einfach zu bedienendes Web Scraping Tool, das entwickelt wurde, um kompliziertes Web Scraping für Nicht-Programmierer zu erleichtern. Als intelligenter Web Scraper für Windows und MacOS„errät“ es automatisch die gewünschten Datenfelder für den Benutzer*innen, was eine Menge Zeit und Energie spart, da Sie die Daten nicht manuell auswählen müssen.

Octoparse ist leistungsfähig genug, um mit dynamischen Websites umzugehen und mit jeder Website auf verschiedene Weise zu interagieren, z. B. Authentifizierung, Texteingabe, Auswahl aus Dropdown-Menüs, Hovering über dynamische Menüs, unendliches Scrollen und vieles mehr. Octoparse bietet sowohl Cloud-basierte Extraktion (kostenpflichtige Funktion) als auch lokale Extraktion (kostenlos). Für präzises Scrapen verfügt Octoparse außerdem über integrierte XPath- und Regular Expression-Tools, die den Benutzern helfen, Daten mit hoher Genauigkeit zu scrapen.

- Vorteile: Keine Programmierkenntnisse erforderlich, Vorlagen für gängige Websites, Cloud-Extraktion.

- Nachteile: Eingeschränkte Anpassungsmöglichkeiten.

- Preis: Kostenloser Plan verfügbar; 14 Tage lang kostenlos ausprobieren.

2. Parsehub ⭐⭐⭐⭐

Parsehub ist eine weitere benutzerfreundliche Web Scraping Software, die keine Programmierkenntnisse benötigt. Da es sich um eine Desktop-Anwendung handelt, wird Parsehub von verschiedenen Systemen wie Windows, Mac OS X und Linux unterstützt. Wie Octoparse kann Parsehub auch mit den bereits erwähnten komplizierten Szenarien von Web Scraping umgehen. Obwohl Parsehub beabsichtigt, eine einfache Web-Scraping-Erfahrung zu bieten, muss ein normaler Benutzer für Web Scraping dennoch ein bisschen Technologie erlernen, um viele der fortgeschrittenen Funktionen vollständig zu verstehen.

- Vorteile: Unterstützt JavaScript, AJAX, Cookies; kostenlose Version verfügbar.

- Nachteile: Begrenzte Projekte in der kostenlosen Version, erfordert Internetverbindung.

- Preis: Kostenloser Plan mit bis zu 5 Projekten; kostenpflichtige Pläne ab $189/Monat.

3. Dexi.io ⭐⭐⭐⭐

Dexi.io ist auch ein Cloud-basierter Web Scraper, der Entwicklungs-, Hosting- und Planungsdienste anbietet. Dexi.io kann sehr leistungsfähig sein, erfordert aber im Vergleich zu Octoparse und Parsehub fortgeschrittenere Programmierkenntnisse. Mit Dexi sind drei Arten von Robotern verfügbar: Extractor, Crawler und Pipes. Dexi unterstützt die Integration mit vielen Diensten von Drittanbietern wie Captcha-Solver, Cloud-Speicher und viele mehr.

- Vorteile: Großes Proxy-Netzwerk, dedizierte Scraper für spezifische Websites.

- Nachteile: Hohe Kosten, komplexe Benutzeroberfläche.

- Preis: Pläne ab $500/Monat.

4. Mozenda ⭐⭐⭐⭐

Mozenda bietet einen Cloud-basierten Web-Scraping-Service an, der dem von Octoparse Cloud-Datenextraktion ähnelt. Als eine der „ältesten“ Web Scraping Software auf dem Markt bietet Mozenda ein hohes Maß an Konsequenz, eine ansprechende Benutzeroberfläche und alles, was man für den Start eines Web-Scraping-Projekts benötigt.

Mozenda besteht aus zwei Teilen: der Mozenda Web Console und dem Agent Builder. Der Mozenda Agent Builder ist eine Windows-Anwendung, mit der ein Scraping-Projekt erstellt wird. Gleichzeitig ist die Web-Konsole eine Web-Anwendung, mit der Benutzer Zeitpläne für die Ausführung der Projekte oder den Zugriff auf die extrahierten Daten festlegen können. Ähnlich wie Octoparse ist Mozenda auch sowohl auf ein Windows-System als auch auf ein Mac-System angewiesen. Aber für Mac-Benutzer kann es etwas kompliziert sein.

5. Import.io ⭐⭐⭐⭐

Berühmt für seine „Magie“ – die automatische Umwandlung jeder Website in strukturierte Daten – ist Import.io bei den Benutzer ganz beliebt. Allerdings fanden viele Nutzer am Ende heraus, dass es nicht wirklich „magisch“ genug war, um verschiedene Arten von Websites zu verarbeiten. Aber es unterliegt keinem Zweifel, dass Import.io ein schönes, gut geführtes Interface hat und den Datenerhebung in Echtzeit über JSON REST-basierte Streaming-APIs unterstützt. Außerdem ist es eine Webanwendung, die in verschiedenen Systemen ausgeführt werden kann.

- Vorteile: Benutzerfreundliche Point-and-Click-Funktionalität, API-Integration.

- Nachteile: Hohe Kosten, eingeschränkte Unterstützung für dynamische Websites.

- Preis: Pläne ab $399/Monat.

6. Apify ⭐⭐⭐

Eine Plattform mit über Hundert vorgefertigten Scraping-APIs und Unterstützung für benutzerdefinierte Scraper.

- Vorteile: Große Bibliothek vorgefertigter Scraper, Unterstützung für Python und JavaScript, flexible Preisgestaltung.

- Nachteile: Zusätzliche Kosten für bestimmte Funktionen, unterstützt nur Python und JavaScript.

- Preis: Kostenloser Plan mit $5 Plattformguthaben; kostenpflichtige Pläne ab $49/Monat.

7. ScrapingBee ⭐⭐⭐

Ein Web-Scraping-API, das Proxys und Headless-Browser verwaltet, um das Scraping zu vereinfachen.

- Vorteile: Unterstützt JavaScript-Rendering, IP-Rotation, CAPTCHA-Lösung.

- Nachteile: Erfordert Programmierkenntnisse, zusätzliche Kosten für erweiterte Funktionen.

- Preis: Pläne ab $49/Monat.

8. Web Scraper ⭐⭐⭐

Ein Browser-Plugin für Chrome und Firefox, das Daten von Websites extrahiert.

- Vorteile: Einfach zu bedienen, kostenlos verfügbar.

- Nachteile: Begrenzte Funktionen, nicht ideal für komplexe Websites.

- Preis: Kostenlos; kostenpflichtige Cloud-Pläne ab $50/Monat.

9. Content Grabber ⭐⭐

Ein leistungsstarkes Desktop-Tool für professionelle Web-Scraping-Aufgaben.

- Vorteile: Umfangreiche Anpassungsmöglichkeiten, unterstützt komplexe Websites.

- Nachteile: Hohe Kosten, erfordert Einarbeitung.

- Preis: Pläne ab $449/Jahr.

10. Common Crawl ⭐⭐

Eine gemeinnützige Organisation, die kostenlose Web-Crawling-Daten zur Verfügung stellt.

- Vorteile: Kostenlos, umfangreiche Datenarchive.

- Nachteile: Erfordert technische Kenntnisse zur Datenverarbeitung.

- Preis: Kostenlos.

11. Diffbot ⭐⭐

Ein KI-gestütztes Tool, das Webinhalte in strukturierte Daten umwandelt.

- Vorteile: Automatische Datenstrukturierung, umfangreiche Wissensdatenbank.

- Nachteile: Hohe Kosten, eingeschränkte Flexibilität.

- Preis: Kostenloser Plan mit begrenzten Optionen; kostenpflichtige Pläne ab $299/Monat.

Zusammenfassung

Niemand ist perfekt. Und gibt es auch nicht ein Werkzeug, das perfekt ist. Alle Tools haben ihre Vor- und Nachteile und sind aus irgendeinem Grund für verschiedene Menschen besser geeignet. Octoparse und Mozenda sind einfacher zu verwenden als alle anderen Scraper. Anhand von diesen Tools ist Web Scraping auch für Nicht-Programmierer möglich zu machen, daher können Sie durch dem Ansehen von ein paar Video-Tutorials schnell ihr eigenes Data Scraping anfangen. Import.io ist ebenfalls auch einfach zu nutzen, funktioniert aber gut mit einer einfachen Webstruktur. Dexi.io und Parsehub sind beide leistungsstarke Scraper mit robusten Funktionen. Sie erfordern jedoch einige Programmierkenntnisse, um sie zu beherrschen.

Ich hoffe, dass dieser Artikel Ihnen einen guten Start in Ihr Web-Scraping-Projekt ermöglicht. Schreiben Sie mir eine Nachricht, wenn Sie Fragen haben. Viel Spaß bei der Datenjagd!

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Autor*in: Das Octoparse Team ❤️

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.