Stellen Sie sich vor, dass Sie etwas jetzt in Google suchen und alle Ergebnislinks zur späteren Verwendung in eine Excel-Datei kopieren wollen. Was sollten Sie in diesem Fall machen? Ganz genau, Sie müssen alle Ergebnisse kopieren und in eine Tabelle einfügen. Wir nennen den Prozess „Datenextraktion“. Das heißt, dass man während des Prozesses Data Mining verwendet.

Es ist ganz sicher, dass Sie verrückt werden müssten, wenn Sie immer auf die Links klicken und sie manuell kopieren sowie einfügen müssen. Sie werden sich vielleicht fragen, „Gibt es eine Maschine, die die ganze Arbeit automatisch für mich erledigen kann?“ Die Antwort ist – Ja! Es gibt gerade diese Maschine wie einen Web Scraper, die Ihnen helfen werden.

Ein Web Scraper ist ein Werkzeug, das dazu verwendet wird, die Daten aus Websites auszulesen und sie zu scrapen. Es kann automatisch bestimmte Daten aus dem Internet sammeln oder kopieren und die Daten in eine zentrale lokale Datenbank oder Tabellenkalkulation eingeben, um sie später abzurufen oder zu analysieren.

Es gibt einige kostenlose Web Scraper, mit denen Sie Ihren eigenen Scraper ohne Programmierkenntnisse erstellen können. In diesem Artikel stellen wir Ihnen mehrere Web Scraper vor, sodass Sie einen geeigneten Web Scraper wählen können!

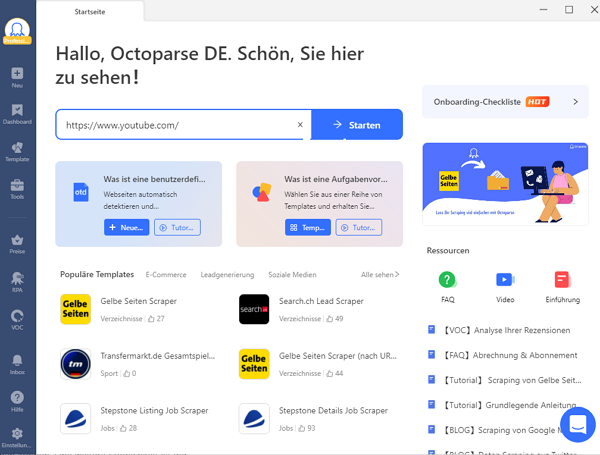

Octoparse

Octoparse ist ein Cloud-basierter Web Crawler, mit dem Sie ganz einfach Webdaten ohne Programmierung extrahieren können. Mit einem benutzerfreundlichen Interface kann es leicht mit allen Arten von Websites umgehen, unabhängig von JavaScript, AJAX oder einer dynamischen Website. Sein fortschrittlicher Algorithmus für maschinelles Lernen kann die Daten genau lokalisieren, wenn Sie darauf klicken.

Octoparse kann mit einem kostenlosen Plan verwendet werden. Gleichzeitig ist eine kostenlose Testversion der kostenpflichtigen Versionen ebenfalls verfügbar. Es unterstützt XPath-Einstellungen zum präzisen Lokalisieren von Webelementen und die Regex-Einstellung zum Umformatieren extrahierter Daten. Außerdem kann es auch IP-Proxys und Captcha-Lösungdienst anbieten. Die extrahierten Daten können über Excel/CSV oder API gescrapt oder in Ihre eigene Datenbank exportiert werden. Octoparse verfügt über eine leistungsstarke Cloud-Plattform, um wichtige Funktionen wie geplante Extraktion und automatische IP-Rotation zu erreichen.

Octoparse bietet über 100 benutzerfreundliche Vorlagen, um Daten zu extrahieren. Über 30.000 Nutzer verwenden die Vorlagen

https://www.octoparse.de/template/email-social-media-scraper

Hier bekommen Sie Octoparse! 🤩

Preis: $0~$249 pro Monat

Packet & Preise: Octoparse Premium-Preise & Verpackung

Kostenlose Testversion: 14-tägige kostenlose Testversion

Herunterladen: Octoparse für Windows und MacOs

Import.io

Import.io ist eine webbasierte Software für Web Scraping. Mithilfe hochentwickelter Algorithmen für maschinelles Lernen extrahiert es Text, URLs, Bilder, Dokumente und sogar Screenshots von Listen- und Detailseiten mit nur einer URL, die Sie eingeben. Der Zugriff auf die Daten kann über APIs, XLSX/CSV, Google Sheet usw. erfolgen. Sie können festlegen, wann die Daten extrahiert werden sollen. Und es werden fast alle Kombinationen von Zeiten, Tagen, Wochen, Monaten usw. unterstützt. Es gibt auch eine tolle Funktion, dass es nach der Datenextraktion sogar einen Datenreport anbieten könnte.

Trotz all dieser leistungsstarken Funktionen hat Import.io seine kostenlose Version storniert und jeder Benutzer kann nur eine 7-tägige kostenlose Testversion erhalten. Derzeit gibt es vier kostenpflichtige Versionen mit einer unterschiedlichen Begrenzung der Extraktoren, Abfragen und Funktionen: Essential ($299/Monat), Professional ($1.999/Jahr), Enterprise ($4.999/Jahr) und Premium ($9.999/Jahr).

Parsehub

Parsehub, eine Cloud-basierte Desktop-App für Data Mining, ist ein einfach zu bedienender Web Scraper mit einer grafischen App-Oberfläche.

Es kann mit allen interaktiven Seiten funktionen, mühelos Formulare durchsuchen, Dropdowns öffnen, sich bei Websites anmelden, auf Karten klicken und Websites mit unendlichem Scrollen, Tabs und Pop-ups verarbeiten usw. Mit seiner Machine-Learning-Relationship-Engine, die die Seite durchsucht und die Hierarchie der Elemente versteht, können Sie die Daten in Sekundenschnelle extrahieren. Damit können Sie auf die Daten über API, CSV/Excel, Google Sheet oder Tableau zugreifen.

Parsehub ist am Anfang kostenlos verwendet. Aber es hat eine Begrenzung der Extraktionsgeschwindigkeit (200 Seiten in 40 Minuten), der Seiten pro Lauf (200 Seiten) und der Anzahl von Projekte (5 Projekte) im kostenlosen Plan. Wenn Sie eine hohe Extraktionsgeschwindigkeit oder mehr Seiten benötigen, sollten Sie sich besser für den Standard-Plan ($149/Monat) oder den Professional-Plan ($499/Monat) entscheiden.

Mozenda

Ein weiterer webbasierter Scraper, Mozenda, sammelt ebenfalls auf magische Weise Daten, indem er Webdaten, unabhängig von ihrem Typ, in ein strukturiertes Format umwandelt.

Es identifiziert automatisch Listen und hilft Ihnen bei der Erstellung von Agenten, die präzise Daten über viele Seiten hinweg sammeln. Mozenda kann nicht nur Webseiten scrapen, sondern auch Daten aus Dokumenten wie Excel, Word, PDF usw. Extrahieren, wie Sie aus Websites die Daten extrahieren. Es unterstützt auch die Veröffentlichung der Ergebnisse im CSV-, TSV-, XML- oder JSON-Format in einer bestehenden Datenbank oder direkt in gängigen BI-Tools wie Amazon Web Services oder Microsoft Azure® für schnelle Analysen und Visualisierungen.

Mozenda bietet eine 30-tägige kostenlose Testversion an, danach können Sie aus den flexiblen Preisplänen wählen. Es gibt die Professional-Version ($100/Monat) und die Enterprise-Version ($450/Monat), die jeweils unterschiedliche Limits für Verarbeitungsguthaben, Speicherplatz und Agenten haben.

Content Grabber

Content Grabber, der eine typische Point-and-Click-Benutzeroberfläche hat, kann beliebigen Inhalt von fast jeder Website extrahieren und die extrahierten Daten als strukturierte Daten in einem Format speichern, einschließlich Excel-Berichten, XML, CSV und den meisten Datenbanken.

Bei der Entwicklung von Content Grabber standen Leistung und Skalierbarkeit an erster Stelle. Um in jedem Szenario maximale Leistung zu erzielen, gibt es eine Reihe von verschiedenen Browsern – vom voll dynamischen Webbrowser bis zum ultraschnellen HTML5-Parser-Browser. Er geht das Problem der Zuverlässigkeit frontal an und bietet starke Unterstützung für Debugging, Fehlerbehandlung und Protokollierung.

Sie können eine 15-tägige kostenlose Testversion herunterladen, die alle Funktionen der Professional Edition bietet, aber gibt es maximal 50 Seiten pro Agent unter Windows. Das monatliche Abonnement kostet $149 für die Professional Edition und $299 für ein Premium-Abonnement. Content Grabber ermöglicht es, Benutzer*innen eine Lizenz erwerben, um die Software dauerhaft zu besitzen.

Zusammenfassung

Alle diese Web Scraper können grundsätzlich verschiedene Extraktionsbedürfnisse befriedigen. Und Software, wie Octoparse, hat sogar Blogs, um Neuigkeiten und Fälle von Datenextraktion zu teilen. Aber es ist wichtig, die Funktionen, Beschränkungen und natürlich den Preis der verschiedenen Software entsprechend Ihren inpiduellen Anforderungen zu berücksichtigen, wenn Sie sich für eine entscheiden wollen. Zum Glück bieten einige Produkte eine kostenlose Testversion an, bevor man sie kauft.

Wir hoffen, dass Web Scraping mit diesen Scrapern kein Problem mehr für Sie darstellt!

👍👍 Wenn Sie Interesse an Octoparse und Web Scraping haben, können Sie es zunächst 14 Tage lang kostenlos ausprobieren.

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Autor*in: Das Octoparse Team ❤️

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.