Seit Jahren kommt E-Commerce mit dem rasanten Wachstum der globalen Wirtschaft zu einem Schlagwort. Alle Unternehmen bestreben sich daran, das Online Geschäft durch Amazon, eBay sowie Tiktok zu entwickeln und vergrößern. Und es ist auch ein dringender Trend, sich konkurrenzfähiger als anderen zu machen. Aber wodurch kann man das Ziel erreichen? Hier gibt es eine Lösung: die Daten. Es ist so zu sagen, dass die Daten, die bei allen Veranstaltungen von Kaufen und Verkaufen auf Internet entstanden sind, zu dem Schlüssel geworden ist. Man kann durch Analysieren solcher Daten Marketingstrategie treffen und Geschäft verbessern.

In diesem Artikel erfahren Sie, wie man mit Hilfe der Web Scraping Tool die Daten aus E-Commerce Website extrahieren kann.

Was ist Datenextraktion?

Bei der Datenextraktion geht es darum, verschiedene Arten von Daten aus den unterschiedlichsten Quellen zu sammeln und abzurufen. Viele dieser Quellen sind dabei schlecht organisiert oder komplett unstrukturiert. Mit Datenextraktion ist es möglich, Daten so zu konsolidieren, zu verarbeiten und zu verfeinern, dass sie an einem zentralen Ort zur Transformation gespeichert werden können – egal, ob in einer lokalen, Cloud-basierten oder hybriden Umgebung.

Warum ist Datenextraktion so wichtig?

Die Nachfrage nach der Extraktion von Daten aus E-Commerce-Websites wächst mit dem Aufschwung des Online-Shoppings. Die Daten auf E-Commerce Websites umfassen detaillierte Informationen über Angebote, Preis, Material, Lagerstand und vieles mehr.

Für diese, die Online-Shop geführt haben, geht es bei der Verwaltung eines E-Commerce Geschäft nicht nur darum, nur den Shop einzurichten, sondern sich ständig bemühen, die tägliche Statistik zu überwachen, den Marktstrend zu folgen, die Konkurrenz durch Analyse der Branchen zu erhöhen, technische Probleme zu beheben, Social Media Marketing zu betreiben, den Ruf der Marke zu pflegen usw. Daher spielt die Extraktion von Daten eine wichtige Rolle bei der Verbesserung und Vergrößerung der Führung eines E-Commerce Geschäfts.

Wobei hilft die Datenextrakeion bei E-Commerce?

Für E-Commerce Unternehmen sind Daten mit der immer tiefen Intergration der Handelsverhalten mit Internet einen wichtigen Bestandteil für Marektingstrategie. Um das Online-Geschäft zu verbessern muss man die Daten so viel wie möglich benutzen. Dann ist eine Frage zuerst gestellt. Wobei können die Daten verwendet werden?

Preisüberwachung

Die Preisüberwachung kommt zu einem ganz wichtigen Mittel für die Bemühung um eine Geschäftsstrategie. Damit kann nicht nur die Preise von Ihren eignen Artikeln sondern auch die von den Kokurenten auf einem offenbaren Online-Verkaufsplattform nämlich Amazon, eBay, Lazada zur Überwachung gestellt werden. Auf solchen Plattformen sind außer Preis auch Inventar, Bewertungen und alle anderen Informationen für jedes Geschäft in transparenten, einfachen, rechtzeitigen und legalen Weisen zugängig. Das bedeutet, dass Sie sich nicht nur auf den Preis konzentrieren können, sondern auch andere Aspekte Ihrer Konkurrenz im Auge behalten können. Daher stehen Ihnen neben den Preisen mehr zur Verfügung. Die Preisüberwachung ist mehr als Preise.

Marketanalyse

Fast jeder kann sein eigenes Geschäft online starten. Heutezutage kommen immer meher Unternehmen im Internet vor, was bedeutet, dass der Wettbewerb unter den Händlern insbesondere den Einzelhändlern härter wird. Um Ihr Unternehmen von der Masse abzuheben und nachhaltiges Wachstum zu erhalten, können Sie mehr tun, als nur Ihren Preis zu senken oder Werbekampagnen zu starten.

Sie könnten für ein Unternehmen in einer Anfangsphase produktiv sein, während Sie langfristig darauf achten sollten, was andere Spieler tun, und Ihre Strategien an die sich ständig verändernde Umgebung anpassen.

Sie können Ihre Kunden und Ihre Konkurrenten analysieren, indem Sie Produktpreise, Kundenverhalten, Produktbewertungen, Ereignisse, Lagerbestände und Anforderungen usw. sammeln. Mit diesen Informationen Sie erhalten Einblicke, wie Sie Ihren Service und Ihre Produkte verbessern und sich von Ihren Mitbewerbern abheben können.

Lead-Generierung

Es besteht kein Zweifel, dass die Fähigkeit, mehr Leads zu generieren, eine der wichtigsten Fähigkeiten ist, um Ihr Geschäft auszubauen. Wie kann man Leads effektiv generieren? Viele Leute sprechen darüber, aber nur wenige von ihnen wissen, wie man es macht. Die meisten Verkäufer suchen jedoch immer noch auf traditionelle, manuelle Weise nach Leads im Internet.

Heutzutage suchen intelligentere Verkäufer mit Hilfe von Web Scraping Tools nach Leads, deren Infos über soziale Medien, Yellow Page,Foren usw. zum Erhalten sind. Damit können Sie mehr Zeit für die Kontakte mit den hohen potenziallen Kunden sparen.

Daten von E-Commerce-Websites extrahieren

Um Daten von E-Commerce Websites zu extrahieren gibt es zwei Möglichkeiten. Man kann einen Scraper entweder mit Programmierungskenntnissen selbständig erstellen oder mit Hilfe von einem Scraping Tool. Für diese, die nicht vertraut mit Progammierung sind, kommt das Scraping Tool eben die beste Wahl.

Es ist wichtig, zuerst zu verstehen, wie ein Scraper funktioniert und worauf Webseiten aufgebaut sind, bevor Sie mit der Extraktion von Webdaten beginnen.

1. Erstellen Sie einen Scraper mit Programmiersprachen und geben Sie dann die URL einer Website ein, von der Sie scrapen möchten. Es sendet eine HTTP-Anfrage an die URL der Webseite. Wenn die Website Ihnen den Zugriff gewährt, antwortet sie auf Ihre Anfrage, indem sie den Inhalt von Webseiten zurückgibt.

2. Der Scraper inspiziert die Seite und interpretiert eine Baumstruktur des HTML. Die Baumstruktur funktioniert wie ein Navigator, der dem Scraper hilft, den Pfaden durch die Webstruktur zu folgen, um die Daten zu erhalten.

3. Danach extrahiert das Web Scraping Tool die Datenfelder, die Sie zum Scrapen und Speichern benötigen. Wenn die Extraktion abgeschlossen ist, wählen Sie ein Format und exportieren Sie die Daten.

Der Prozess des Web Scrapings ist leicht zu verstehen, aber es ist definitiv nicht einfach, insbesonders für Nicht-Progammierer. Glücklicherweise gibt es dank der Entwicklung von Big Data viele kostenlose Tools zum Web Scraping. Bleiben Sie dran, es gibt einige schöne und kostenlose Scraper die ich Ihnen gerne empfehlen würde.

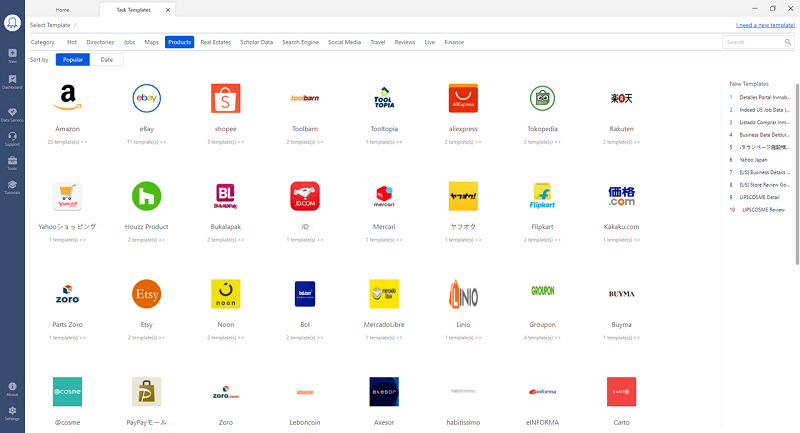

Octoparse ist ein leistungsstarkes Tool zur Extraktion von Webdaten. Seine benutzerfreundliche Point-and-Click-Schnittstelle kann Sie mühelos durch den gesamten Extraktionsprozess führen. Darüber hinaus machen der automatische Erkennungsprozess und die gebrauchsfertigen Vorlagen das Abkratzen für neue Starter viel einfacher.

Im folgenden Video sehen Sie die Extraktion von Amazon als Belspiel nach. Wenn Sie sich dafür interessieren, können Sie probeweise Octoparse herunterladen und eine Aufgabe erstellen.

Wenn Sie die Daten aus anderen Websites sowie eBay, Walmart scrapen möchten, finden Sie bei Octoparse mehr Vorlagen.

Hier bekommen Sie Octoparse! 🤩

Preis: $0~$249 pro Monat

Packet & Preise:Octoparse Premium-Preise & Verpackung

Kostenlose Testversion: 14-tägige kostenlose Testversion

Herunterladen:Octoparse für Windows und MacOs

Wenn Sie Probleme bei der Datenextraktion haben, oder uns etwas Vorschlägen geben möchten, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬

Autor*in: Das Octoparse Team ❤️