Beim Scraping von Daten kann es zu einigen unangenehmen Dingen kommen, beispielsweise zu einer Unterbrechung der Datenextraktionsaufgaben. Manche Scraper erfordern beispielsweise, dass Ihr Computer während der Verarbeitung im Wachmodus bleibt, aber Ihr Computer fährt aus unerwarteten Gründen plötzlich herunter. Die Cloud-Datenextraktion ist da, um solche Probleme zu lösen. In diesem Beitrag tauchen wir in das Cloud-Web-Scraping ein und finden heraus, wie die Cloud-Extraktion von Octoparse das Sammeln von Daten stabiler und müheloser macht.

Was ist Cloud-Datenextraktion

Cloud Scraping, auch bekannt als Cloud-Datenextraktion, bezeichnet den Prozess der Nutzung von Cloud-basierten Servern und Infrastrukturen zum Extrahieren von Daten von Websites. Dabei werden Daten aus verschiedenen Quellen extrahiert und in einer Cloud-Umgebung zur weiteren Verarbeitung, Analyse oder Speicherung gespeichert. Die Cloud-Datenextraktion bietet gegenüber herkömmlichen lokalen Extraktionsmethoden mehrere Vorteile, darunter Skalierbarkeit, Flexibilität und Kosteneffizienz. Unternehmen nutzen mittlerweile cloudbasierte Tools und Dienste, um Datenextraktionsprozesse zu automatisieren und große Datenmengen zu verarbeiten.

Wenn Sie beispielsweise Daten mit Cloud-Extraktion extrahieren, müssen Sie eine Regel konfigurieren und diese auf die Cloud-Plattform hochladen. Anschließend wird Ihre Aufgabe einem oder mehreren Cloud-Servern zugewiesen, um die Daten gleichzeitig über zentrale Steuerungsbefehle zu extrahieren. Wenn Ihre Aufgabe in drei Teile aufgeteilt und gleichmäßig auf drei Cloud-Server verteilt wird, dauert sie nur ein Drittel der ursprünglichen Zeit im Vergleich zur Ausführung auf Ihrem Gerät.

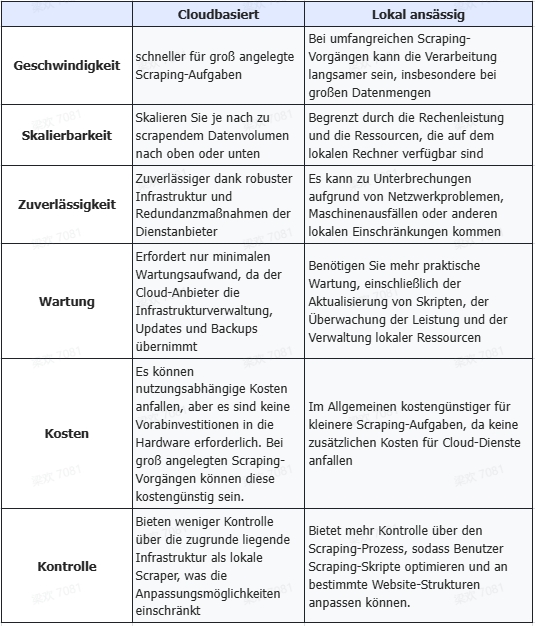

Cloud-Web-Scraper vs. lokale Web-Scraper

Cloudbasierte Scraper und lokale Scraper stellen zwei unterschiedliche Ansätze für das Web Scraping dar. Bei der Auswahl einer Option zwischen ihnen,Unternehmen könnten Faktoren wie Geschwindigkeit, Skalierbarkeit, Zuverlässigkeit, Wartung, Kosten usw., um den am besten geeigneten Ansatz für ihre Web-Scraping-Anforderungen zu ermitteln. Hier sind einige wichtige Unterschiede zwischen Cloud-Web-Scrapern und lokalen Web-Scrapern.

Was ist der Octoparse Cloud-Extraktionsmodus

Bisher haben wir die Stärken des Cloud-basierten Web Scrapings kennengelernt. Es gibt viele Cloud-Web Scraper auf dem Markt, und Octoparse wird aufgrund seiner leistungsstarken Funktionen am meisten empfohlen.

Octoparse bietet außerdem eine leistungsstarke Cloud-Funktion, mit der Benutzer ihre Aufgaben rund um die Uhr ausführen können. Während Sie Aufgaben mit Octoparse-Cloud-Servern ausführen, können Sie das Scraping beschleunigen, Blockaden durch eine große Anzahl von Adressen vermeiden und Ihr System und Octoparse eng per API verknüpfen.

Hier sind einige Gründe, warum Sie sich für Octoparse zur Cloud-Datenextraktion entscheiden sollten.

Extrahieren Sie Daten ohne Pausen und Zeitlimit

Wenn Sie den Octoparse-Cloud-Dienst zum Abrufen von Daten von Websites verwenden, müssen Sie sich keine Sorgen mehr über Fehler wie gelegentliche Netzwerkunterbrechungen oder das Einfrieren des Computers machen. Wenn solche Fehler auftreten, können Cloud-Server ihre Arbeit trotzdem sofort wieder aufnehmen. Wenn Sie Daten zu einem bestimmten Zeitpunkt extrahieren oder Ihre Daten routinemäßig aktualisieren müssen, können Sie über Octoparse eine Cloud-Extraktionsaufgabe planen.

Legen Sie parallele Aufgaben fest, um den Extraktionsprozess zu beschleunigen

Wie oben erwähnt, können Sie mit Cloud-Plattformen eine Scraping-Aufgabe in mehrere Abschnitte unterteilen und diese mehreren Servern zuweisen, um gleichzeitig Daten zu extrahieren. Der Octoparse-Cloud-Modus bietet jetzt bis zu 20 Knoten für kostenpflichtige Pläne. Während Sie Daten mit der Octoparse-Cloud-Plattform extrahieren, versucht Octoparse, Ihre Aufgabe in kleinere Unteraufgaben aufzuteilen und jede Unteraufgabe auf einem separaten Cloud-Knoten auszuführen, um die Datenextraktion zu beschleunigen. Die Cloud-Knoten können Aufgaben rund um die Uhr ausführen und sind bis zu 4-20 Mal schneller als die lokale Extraktion.

Blockierung durch IP-Rotation vermeiden

Wenn Sie Erfahrung mit Web Scraping haben, wurden Sie möglicherweise beim Scraping von Websites blockiert. Blockiert zu werden ist ein häufiges Problem für Scraper, da viele Websites möglicherweise über hohe Sicherheitsmaßnahmen verfügen, um Web Scraper zu erkennen und zu blockieren. Um dieses Problem zu lösen, bietet der Octoparse-Cloud-Dienst Tausende von Cloud-Knoten mit jeweils einer eindeutigen IP-Adresse zur IP-Rotation. So können Ihre Anfragen auf der Zielwebsite über verschiedene IPs ausgeführt werden, wodurch die Wahrscheinlichkeit minimiert wird, dass Sie von der Zielwebsite verfolgt und blockiert werden.

So verwenden Sie die Octoparse Cloud-Datenextraktion Schritt für Schritt

Der Cloud-Extraktionsmodus ist die erweiterte Funktion von Octoparse. Bitte stellen Sie sicher, dass Sie bereits den Octoparse Standard-/Professional-/Enterprise-Tarif abonniert haben. Starten Sie anschließend Octoparse auf Ihrem Gerät und folgen Sie den unten stehenden Schritten.

Schritt 1: Richten Sie Ihre Extraktionsaufgabe ein

Ähnlich wie beim lokalen Scraping-Modus sollten Sie zunächst Ihren Workflow einrichten. Kopieren Sie die Zielwebsite, die Sie scrapen möchten, und fügen Sie sie ein. Mit der Point-and-Click-Oberfläche und der automatischen Erkennungsfunktion von Octoparse können Sie ganz einfach einen Scraping-Workflow erstellen.

Schritt 2: Passen Sie Ihren Data Scraping-Workflow an

Überprüfen und spezifizieren Sie die benötigten Datenfelder, wie Produktdetails, Preise, Bewertungen usw. Sie können in diesem Schritt Paginierung, XPath, IP-Proxy und andere erweiterte Funktionen einrichten. Löschen oder fügen Sie Datenfelder nach Bedarf hinzu.

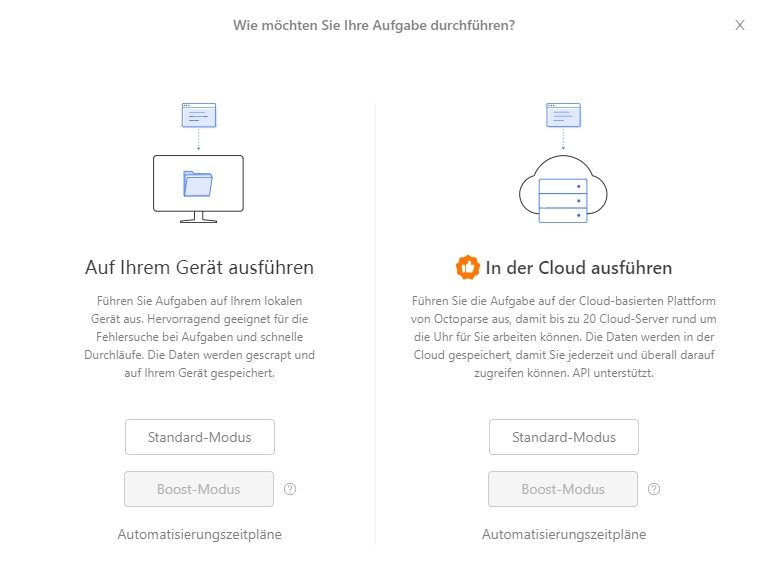

Schritt 3: Führen Sie Ihre Aufgabe in der Cloud aus

Klicken Sie nach Abschluss des Workflows auf die Schaltfläche „Ausführen“ und wählen Sie unter „In der Cloud ausführen“ den Standardmodus oder den Boost-Modus aus , um einen Lauf in der Cloud auszuführen. Sie müssen Ihren Computer nicht eingeschaltet lassen und sich keine Gedanken über die Leistung machen.

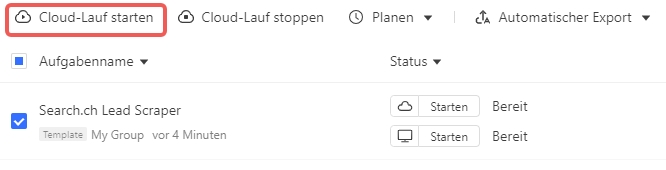

Sie können auch mehrere Aufgaben gleichzeitig aus der Cloud ausführen. Wählen Sie aus der Aufgabenliste alle Aufgaben aus, die ausgeführt werden müssen, und klicken Sie auf „Cloud Run starten“, um sie gemeinsam in der Cloud auszuführen.

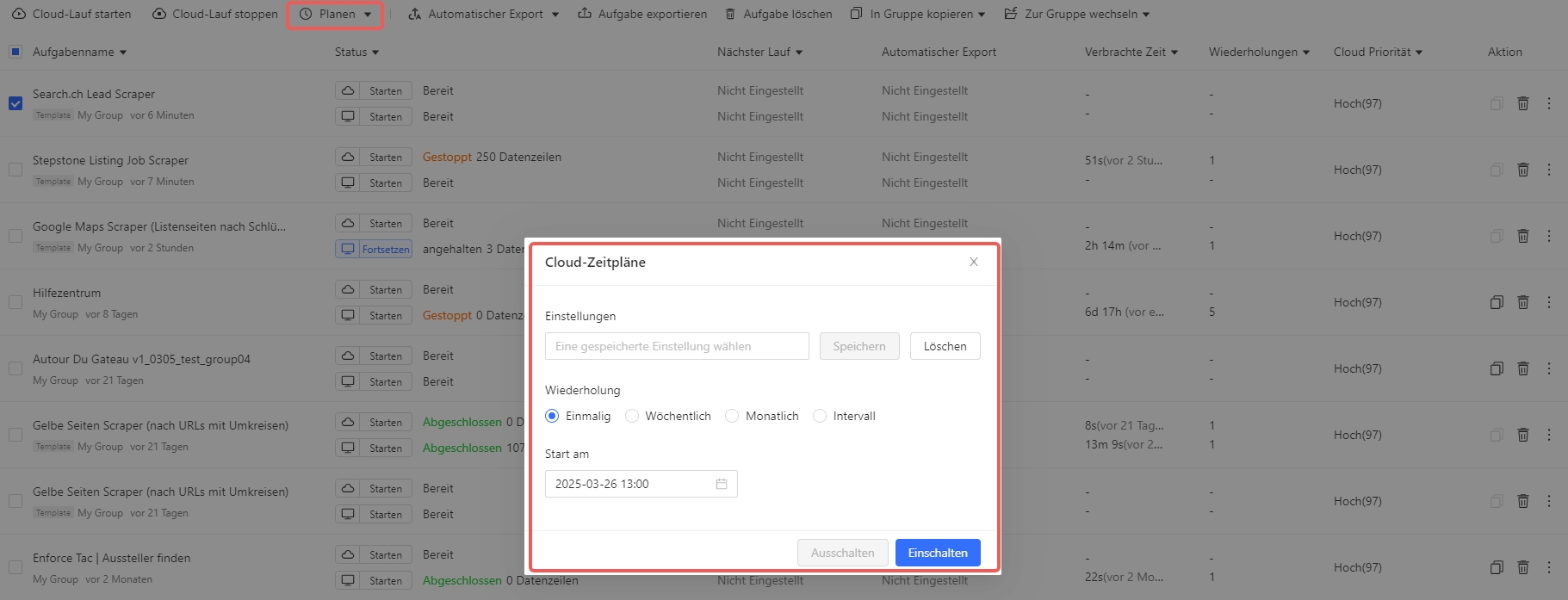

Die Planung des Cloud Scraping ist jederzeit möglich. Wählen Sie „Cloud-Läufe planen“ für eine einzelne Aufgabe und klicken Sie auf die Schaltfläche „Planen für“, um die Planungszeit festzulegen.

Weitere Einzelheiten zu den Einstellungen für das Cloud Scraping mit Octoparse finden Sie im Tutorial zur Cloud-Datenextraktion.

Verknüpfen Sie Octoparse und Ihr System über die API

Der Octoparse-Clouddienst bietet Ihnen auch eine API, um Ihr System oder andere Tools eng mit Octoparse zu verknüpfen, sodass Sie Scraped-Daten direkt in Ihre Datenbank exportieren können, anstatt erst Zeit damit zu verbringen, Datendateien auf Ihre Geräte zu exportieren. Sie können beispielsweise extrahierte Daten über die Octoparse-API in Google Sheets exportieren. Oder wenn Ihr Team Programmiererfahrung hat und den Prozess zum Exportieren von Daten oder zum Steuern von Aufgaben automatisieren muss, können Sie mit Postman eine Verbindung zu den Octoparse-APIs herstellen.

Zusammenfassung

Cloudbasiertes Web Scraping ist die Lösung, um Ihren Datenextraktionsprozess zu vereinfachen. Im Vergleich zur lokalen Lösung ist es effektiver und kann Ihnen helfen, häufige Probleme wie Blockierungen und CAPTCHA zu lösen. Wenn Sie Probleme bei der Datenextraktion haben, kontaktieren Sie bitte uns per E-Mail (support@octoparse.com). 💬 Probieren Sie Octoparse jetzt 14 Tage lang kostenlos aus und lassen Sie Cloud-Server Ihr Web Scraping-Erlebnis auf die nächste Stufe bringen!

Konvertiere Website-Daten direkt in Excel, CSV, Google Sheets und Ihre Datenbank.

Scrape Daten einfach mit Auto-Dedektion, ganz ohne Coding.

Scraping-Vorlagen für beliebte Websites, um Daten mit wenigen Klicks zu erhalten.

Mit IP-Proxys und fortschrittlicher API wird nie blockiert.

Cloud-Dienst zur Planung von Datenabfragen zu jedem gewünschten Zeitpunkt.